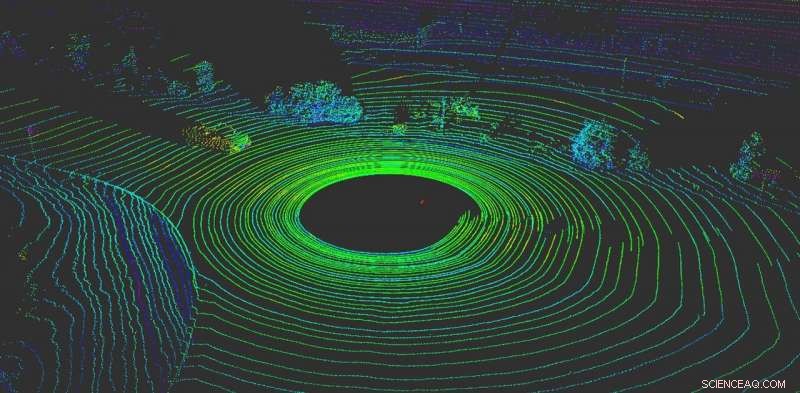

LiDAR aiuta un veicolo autonomo a "visualizzare" ciò che lo circonda. Credito:Yulong Can con i dati di Baidu Apollo, CC BY-ND

Niente è più importante per un veicolo autonomo che percepire cosa sta succedendo intorno ad esso. Come i conducenti umani, i veicoli autonomi hanno bisogno della capacità di prendere decisioni istantanee.

Oggi, la maggior parte dei veicoli autonomi si affida a più sensori per percepire il mondo. La maggior parte dei sistemi utilizza una combinazione di telecamere, sensori radar e sensori LiDAR (rilevamento e distanza della luce). A bordo, i computer fondono questi dati per creare una visione completa di ciò che accade intorno all'auto. Senza questi dati, i veicoli autonomi non avrebbero alcuna speranza di navigare in sicurezza nel mondo. Le auto che utilizzano più sistemi di sensori funzionano meglio e sono più sicure:ogni sistema può fungere da controllo sugli altri, ma nessun sistema è immune da attacchi.

Sfortunatamente, questi sistemi non sono infallibili. I sistemi di percezione basati su telecamere possono essere ingannati semplicemente applicando adesivi sui segnali stradali per cambiarne completamente il significato.

Il nostro lavoro, dal gruppo di ricerca RobustNet dell'Università del Michigan, ha dimostrato che il sistema di percezione basato su LiDAR può essere compreso, pure. Con lo spoofing strategico dei segnali del sensore LiDAR, l'attacco è in grado di ingannare il sistema di percezione basato su LiDAR del veicolo facendogli "vedere" un ostacolo inesistente. Se questo accade, un veicolo potrebbe causare un incidente bloccando il traffico o frenando bruscamente.

Spoofing dei segnali LiDAR

I sistemi di percezione basati su LiDAR hanno due componenti:il sensore e il modello di apprendimento automatico che elabora i dati del sensore. Un sensore LiDAR calcola la distanza tra se stesso e l'ambiente circostante emettendo un segnale luminoso e misurando quanto tempo impiega quel segnale a rimbalzare su un oggetto e tornare al sensore. Questa durata di questo avanti e indietro è anche conosciuta come "tempo di volo".

Un'unità LiDAR invia decine di migliaia di segnali luminosi al secondo. Quindi il suo modello di apprendimento automatico utilizza gli impulsi restituiti per dipingere un'immagine del mondo intorno al veicolo. È simile al modo in cui un pipistrello usa l'ecolocalizzazione per sapere dove si trovano gli ostacoli di notte.

Il problema è che questi impulsi possono essere falsificati. Per ingannare il sensore, un aggressore può puntare il proprio segnale luminoso sul sensore. Questo è tutto ciò che serve per confondere il sensore.

Però, è più difficile falsificare il sensore LiDAR per "vedere" un "veicolo" che non c'è. Per avere successo, l'attaccante deve sincronizzare con precisione i segnali sparati al LiDAR della vittima. Questo deve accadere a livello di nanosecondi, poiché i segnali viaggiano alla velocità della luce. Piccole differenze risaltano quando il LiDAR calcola la distanza utilizzando il tempo di volo misurato.

Se un utente malintenzionato inganna con successo il sensore LiDAR, deve quindi anche ingannare il modello di apprendimento automatico. Il lavoro svolto presso il laboratorio di ricerca OpenAI mostra che i modelli di apprendimento automatico sono vulnerabili a segnali o input appositamente predisposti, i cosiddetti esempi contraddittori. Per esempio, adesivi appositamente generati sui segnali stradali possono ingannare la percezione basata sulla telecamera.

Abbiamo scoperto che un utente malintenzionato potrebbe utilizzare una tecnica simile per creare perturbazioni che funzionano contro LiDAR. Non sarebbero un adesivo visibile, ma segnali contraffatti creati appositamente per ingannare il modello di apprendimento automatico facendogli credere che ci siano ostacoli presenti quando in realtà non ce ne sono. Il sensore LiDAR alimenterà i falsi segnali dell'hacker al modello di apprendimento automatico, che li riconoscerà come un ostacolo.

L'esempio contraddittorio, l'oggetto falso, potrebbe essere creato per soddisfare le aspettative del modello di apprendimento automatico. Per esempio, l'aggressore potrebbe creare il segnale di un camion che non si muove. Quindi, per condurre l'attacco, potrebbero installarlo a un incrocio o posizionarlo su un veicolo guidato davanti a un veicolo autonomo.

Due possibili attacchi

Per dimostrare l'attacco progettato, abbiamo scelto un sistema di guida autonoma utilizzato da molte case automobilistiche:Baidu Apollo. Questo prodotto ha oltre 100 partner e ha raggiunto un accordo di produzione di massa con più produttori, tra cui Volvo e Ford.

Utilizzando i dati dei sensori del mondo reale raccolti dal team di Baidu Apollo, abbiamo dimostrato due diversi attacchi. Nel primo, un "attacco di frenata di emergenza, " abbiamo mostrato come un aggressore può fermare improvvisamente un veicolo in movimento inducendolo a pensare che un ostacolo sia apparso sul suo percorso. Nel secondo, un "attacco di congelamento AV, "Abbiamo usato un ostacolo contraffatto per ingannare un veicolo che era stato fermato a un semaforo rosso per rimanere fermo dopo che il semaforo diventa verde.

Sfruttando le vulnerabilità dei sistemi di percezione della guida autonoma, speriamo di far scattare un allarme per i team che costruiscono tecnologie autonome. La ricerca su nuovi tipi di problemi di sicurezza nei sistemi di guida autonoma è appena iniziata, e speriamo di scoprire più possibili problemi prima che possano essere sfruttati per strada da cattivi attori.

Questo articolo è stato ripubblicato da The Conversation con una licenza Creative Commons. Leggi l'articolo originale.