I robotici stanno sviluppando robot automatizzati in grado di apprendere nuovi compiti esclusivamente osservando gli esseri umani. A casa, potresti un giorno mostrare a un robot domestico come fare le faccende di routine. Credito:Christine Daniloff, MIT

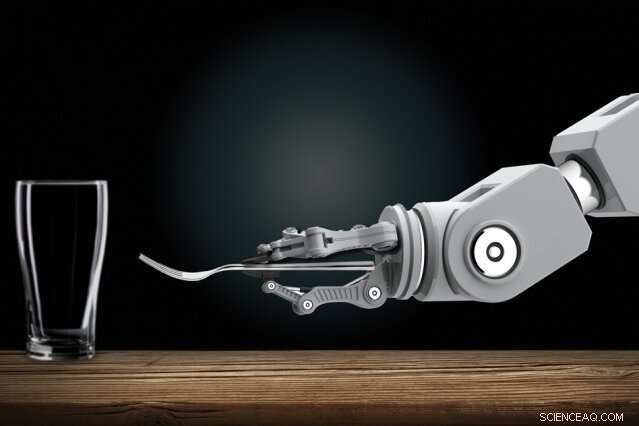

L'addestramento di robot interattivi potrebbe un giorno essere un lavoro facile per tutti, anche quelli senza esperienza di programmazione. I robotisti stanno sviluppando robot automatizzati in grado di apprendere nuovi compiti esclusivamente osservando gli esseri umani. A casa, potresti un giorno mostrare a un robot domestico come fare le faccende di routine. Nel posto di lavoro, potresti addestrare robot come nuovi dipendenti, mostrando loro come svolgere molti compiti.

Facendo progressi su quella visione, I ricercatori del MIT hanno progettato un sistema che consente a questi tipi di robot di apprendere compiti complicati che altrimenti li ostacolerebbero con troppe regole confuse. Uno di questi compiti è apparecchiare una tavola da pranzo in determinate condizioni.

Al suo centro, il sistema "Pianificazione con specifiche incerte" (PUnS) dei ricercatori offre ai robot la capacità di pianificazione simile a quella umana per valutare contemporaneamente molti requisiti ambigui e potenzialmente contraddittori per raggiungere un obiettivo finale. Così facendo, il sistema sceglie sempre l'azione più probabile da intraprendere, sulla base di una "convinzione" su alcune probabili specifiche per il compito che dovrebbe svolgere.

Nel loro lavoro, i ricercatori hanno compilato un set di dati con informazioni su come otto oggetti:una tazza, bicchiere, cucchiaio, forchetta, coltello, piatto da cena, piccolo piatto, e ciotola:può essere posizionato su un tavolo in varie configurazioni. Un braccio robotico ha osservato per la prima volta dimostrazioni umane selezionate casualmente di apparecchiare la tavola con gli oggetti. Quindi, i ricercatori hanno incaricato il braccio di impostare automaticamente un tavolo in una configurazione specifica, negli esperimenti del mondo reale e nella simulazione, in base a ciò che aveva visto.

Per avere successo, il robot ha dovuto soppesare molti possibili ordini di piazzamento, anche quando gli oggetti sono stati volutamente rimossi, impilato, o nascosto. Normalmente, tutto ciò confonderebbe troppo i robot. Ma il robot dei ricercatori non ha commesso errori su diversi esperimenti del mondo reale, e solo una manciata di errori su decine di migliaia di esecuzioni di test simulate.

"La visione è mettere la programmazione nelle mani di esperti di dominio, chi può programmare i robot in modi intuitivi, piuttosto che descrivere gli ordini a un ingegnere da aggiungere al loro codice, " dice il primo autore Ankit Shah, uno studente laureato presso il Dipartimento di Aeronautica e Astronautica (AeroAstro) e l'Interactive Robotics Group, che sottolinea che il loro lavoro è solo un passo per realizzare quella visione. "Quel modo, i robot non dovranno più eseguire attività preprogrammate. Gli operai di fabbrica possono insegnare a un robot a svolgere più complesse attività di assemblaggio. I robot domestici possono imparare a impilare gli armadietti, caricare la lavastoviglie, o apparecchiare la tavola dalle persone a casa."

Insieme a Shah sul giornale ci sono lo studente laureato di AeroAstro e dell'Interactive Robotics Group Shen Li e il leader dell'Interactive Robotics Group Julie Shah, professore associato di AeroAstro e del Laboratorio di informatica e intelligenza artificiale.

Scommesse di copertura dei bot

I robot sono ottimi pianificatori in compiti con chiare "specifiche, " che aiutano a descrivere il compito che il robot deve svolgere, considerando le sue azioni, ambiente, e obiettivo finale. Imparare ad apparecchiare la tavola osservando le dimostrazioni, è pieno di specifiche incerte. Gli articoli devono essere posizionati in determinati punti, a seconda del menù e di dove si siedono gli ospiti, e in certi ordini, a seconda della disponibilità immediata di un articolo o delle convenzioni sociali. Gli attuali approcci alla pianificazione non sono in grado di affrontare specifiche così incerte.

Un approccio popolare alla pianificazione è "apprendimento per rinforzo, " una tecnica di apprendimento automatico per tentativi che li premia e li penalizza per le azioni mentre lavorano per completare un'attività. Ma per le attività con specifiche incerte, è difficile definire ricompense e penalizzazioni chiare. In breve, i robot non imparano mai completamente il bene dal male.

Il sistema dei ricercatori, chiamato PUnS (per la pianificazione con specifiche incerte), consente a un robot di mantenere una "credenza" su una gamma di possibili specifiche. La convinzione stessa può quindi essere utilizzata per distribuire ricompense e sanzioni. "Il robot sta essenzialmente coprendo le sue scommesse in termini di ciò che è previsto in un'attività, e compie azioni che soddisfano la sua convinzione, invece di dargli una specifica chiara, " dice Ankit Shah.

Il sistema è costruito su "logica temporale lineare" (LTL), un linguaggio espressivo che consente il ragionamento robotico sui risultati attuali e futuri. I ricercatori hanno definito modelli in LTL che modellano varie condizioni basate sul tempo, come quello che deve succedere ora, deve alla fine accadere, e deve accadere finché non si verifica qualcos'altro. Le osservazioni del robot di 30 dimostrazioni umane per apparecchiare la tavola hanno prodotto una distribuzione di probabilità su 25 diverse formule LTL. Ogni formula codificava una preferenza, o specifica, leggermente diversa per l'impostazione della tabella. Quella distribuzione di probabilità diventa la sua convinzione.

"Ogni formula codifica qualcosa di diverso, ma quando il robot considera varie combinazioni di tutti i modelli, e cerca di soddisfare tutto insieme, finisce per fare la cosa giusta alla fine, " dice Ankit Shah.

Seguendo i criteri

I ricercatori hanno anche sviluppato diversi criteri che guidano il robot verso il soddisfacimento dell'intera convinzione su quelle formule candidate. Uno, ad esempio, soddisfa la formula più probabile, che scarta tutto il resto tranne il modello con la più alta probabilità. Altri soddisfano il maggior numero di formule uniche, senza considerare la loro probabilità complessiva, oppure soddisfano più formule che rappresentano la più alta probabilità totale. Un altro minimizza semplicemente l'errore, quindi il sistema ignora le formule con alta probabilità di errore.

I progettisti possono scegliere uno qualsiasi dei quattro criteri da preimpostare prima della formazione e del test. Ognuno ha il proprio compromesso tra flessibilità e avversione al rischio. La scelta dei criteri dipende interamente dal compito. In situazioni critiche per la sicurezza, ad esempio, un progettista può scegliere di limitare la possibilità di fallimento. Ma dove le conseguenze del fallimento non sono così gravi, designers can choose to give robots greater flexibility to try different approaches.

With the criteria in place, the researchers developed an algorithm to convert the robot's belief—the probability distribution pointing to the desired formula—into an equivalent reinforcement learning problem. This model will ping the robot with a reward or penalty for an action it takes, based on the specification it's decided to follow.

In simulations asking the robot to set the table in different configurations, it only made six mistakes out of 20, 000 tries. In real-world demonstrations, it showed behavior similar to how a human would perform the task. If an item wasn't initially visible, ad esempio, the robot would finish setting the rest of the table without the item. Quindi, when the fork was revealed, it would set the fork in the proper place. "That's where flexibility is very important, " Shah says. "Otherwise it would get stuck when it expects to place a fork and not finish the rest of table setup."

Prossimo, the researchers hope to modify the system to help robots change their behavior based on verbal instructions, corrections, or a user's assessment of the robot's performance. "Say a person demonstrates to a robot how to set a table at only one spot. The person may say, 'do the same thing for all other spots, ' or, 'place the knife before the fork here instead, '" Shah says. "We want to develop methods for the system to naturally adapt to handle those verbal commands, without needing additional demonstrations."

Questa storia è stata ripubblicata per gentile concessione di MIT News (web.mit.edu/newsoffice/), un popolare sito che copre notizie sulla ricerca del MIT, innovazione e didattica.