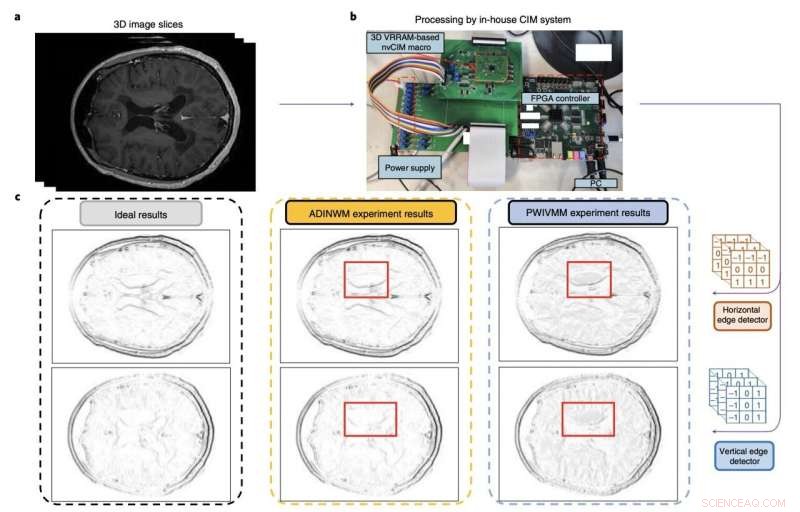

Figura che riassume la valutazione e le prestazioni della macro di calcolo in memoria dei ricercatori. Credito:Huo et al (Nature Electronics , 2022).

Le architetture di apprendimento automatico basate su reti neurali convoluzionali (CNN) si sono rivelate estremamente preziose per un'ampia gamma di applicazioni, che vanno dalla visione artificiale all'analisi di immagini e all'elaborazione o generazione del linguaggio umano. Per affrontare compiti più avanzati, tuttavia, queste architetture stanno diventando sempre più complesse e impegnative dal punto di vista computazionale.

Negli ultimi anni, molti ingegneri elettronici in tutto il mondo hanno quindi cercato di sviluppare dispositivi in grado di supportare l'archiviazione e il carico computazionale di complesse architetture basate sulla CNN. Ciò include dispositivi di memoria più densi in grado di supportare grandi quantità di pesi (cioè i parametri addestrabili e non addestrabili considerati dai diversi livelli delle CNN).

I ricercatori dell'Accademia cinese delle scienze, dell'Istituto di tecnologia di Pechino e di altre università cinesi hanno recentemente sviluppato un nuovo sistema di calcolo in memoria che potrebbe aiutare a eseguire modelli più complessi basati sulla CNN in modo più efficace. La loro componente di memoria, introdotta in un articolo pubblicato su Nature Electronics , si basa su macro di calcolo in memoria non volatili costituite da array di memristor 3D.

"Il ridimensionamento di tali sistemi su array 3D potrebbe fornire maggiore parallelismo, capacità e densità per le necessarie operazioni di moltiplicazione di matrice vettoriale", hanno scritto Qiang Huo e i suoi colleghi nel loro articolo. "Tuttavia, il ridimensionamento a tre dimensioni è impegnativo a causa di problemi di produzione e variabilità dei dispositivi. Segnaliamo una macro di calcolo in memoria non volatile da due kilobit basata su una memoria ad accesso casuale resistivo verticale tridimensionale fabbricata utilizzando un 55 processo complementare nm-ossido di metallo-semiconduttore."

Le memorie resistive ad accesso casuale, o RRAM, sono dispositivi di archiviazione non volatili (cioè che conservano i dati anche dopo un'interruzione dell'alimentazione) basati su memristori. I memristori sono componenti elettronici che possono limitare o regolare il flusso di corrente elettrica nei circuiti, registrando la quantità di carica che in precedenza scorreva attraverso di essi.

Le RRAM funzionano essenzialmente variando la resistenza attraverso un memristore. Mentre studi passati hanno dimostrato il grande potenziale di questi dispositivi di memoria, le versioni convenzionali di questi dispositivi sono separate dai motori dei computer, il che limita le loro possibili applicazioni.

I dispositivi RRAM di calcolo in memoria sono stati progettati per superare questa limitazione, incorporando i calcoli all'interno della memoria. Ciò può ridurre notevolmente il trasferimento di dati tra memorie e processori, migliorando in definitiva l'efficienza energetica dell'intero sistema.

Il dispositivo di calcolo in memoria creato da Huo e dai suoi colleghi è una RRAM 3D con strati impilati verticalmente e circuiti periferici. I circuiti del dispositivo sono stati fabbricati utilizzando la tecnologia CMOS a 55 nm, la tecnologia alla base della maggior parte dei circuiti integrati oggi sul mercato.

I ricercatori hanno valutato il loro dispositivo utilizzandolo per eseguire operazioni complesse e per eseguire un modello per rilevare i bordi nelle scansioni cerebrali MRI. Il team ha addestrato i propri modelli utilizzando due set di dati MRI esistenti per l'addestramento di strumenti di riconoscimento delle immagini, noti come set di dati MNIST e CIFAR-10.

"La nostra macro può eseguire operazioni di moltiplicazione di matrice vettoriale 3D con un'efficienza energetica di 8,32 tera-operazioni al secondo per watt quando i dati di input, peso e output sono rispettivamente di 8,9 e 22 bit e la densità di bit è di 58,2 bit µm –2 ", hanno scritto i ricercatori nel loro articolo. "Mostriamo che la macro offre un rilevamento dei bordi MRI cerebrale più accurato e una migliore precisione dell'inferenza sul set di dati CIFAR-10 rispetto ai metodi convenzionali".

Nei test iniziali, il sistema RRAM verticale di calcolo in memoria creato da Huo e dai suoi colleghi ha ottenuto risultati notevoli, superando gli approcci RRAM convenzionali. In futuro, potrebbe quindi rivelarsi estremamente prezioso per l'esecuzione di modelli complessi basati sulla CNN in modo più efficiente dal punto di vista energetico, consentendo anche migliori precisioni e prestazioni. + Esplora ulteriormente

© 2022 Rete Science X