Nel gioco di esplorazione dello scout, per allinearsi con i valori umani, il robot impara dal feedback umano alle proposte. Credito immagine:Sig.ra Zhen Chen@BIGAI.

I metodi di intelligenza artificiale (AI) sono diventati sempre più avanzati negli ultimi decenni, ottenendo risultati notevoli in molte attività del mondo reale. Tuttavia, la maggior parte dei sistemi di intelligenza artificiale esistenti non condivide le proprie analisi e i passaggi che hanno portato alle loro previsioni con gli utenti umani, il che può rendere estremamente difficile una valutazione affidabile.

Un gruppo di ricercatori dell'UCLA, dell'UCSD, dell'Università di Pechino e dell'Istituto di intelligenza artificiale generale di Pechino (BIGAI) ha recentemente sviluppato un nuovo sistema di intelligenza artificiale in grado di spiegare i suoi processi decisionali agli utenti umani. Questo sistema, introdotto in un documento pubblicato su Science Robotics , potrebbe essere un nuovo passo verso la creazione di un'IA più affidabile e comprensibile.

"Il campo dell'IA spiegabile (XAI) mira a creare fiducia collaborativa tra robot e umani e il progetto DARPA XAI è servito da grande catalizzatore per far avanzare la ricerca in quest'area", ha affermato il dott. Luyao Yuan, uno dei primi autori dell'articolo , ha detto a TechXplore. "All'inizio del progetto DARPA XAI, i team di ricerca si concentrano principalmente sull'ispezione dei modelli per le attività di classificazione rivelando all'utente il processo decisionale dei sistemi di intelligenza artificiale; ad esempio, alcuni modelli possono visualizzare determinati livelli di modelli CNN, sostenendo di ottenere un determinato livello di XAI."

Il Dr. Yuan ei suoi colleghi hanno partecipato al progetto DARPA XAI, che era specificamente mirato allo sviluppo di nuovi e promettenti sistemi XAI. Durante la partecipazione al progetto, hanno iniziato a riflettere su cosa significherebbe XAI in senso lato, in particolare sugli effetti che potrebbe avere sulle collaborazioni tra uomo e macchina.

Il recente documento del team si basa su uno dei loro lavori precedenti, pubblicato anche su Science Robotics , in cui il team ha esplorato l'impatto che i sistemi spiegabili potrebbero avere sulle percezioni e sulla fiducia di un utente nell'IA durante le interazioni uomo-macchina. Nel loro studio passato, il team ha implementato e testato un sistema di intelligenza artificiale fisicamente (cioè nel mondo reale), mentre nel loro nuovo studio lo hanno testato in simulazioni.

"Il nostro paradigma è in contrasto con quasi tutti quelli proposti dai team nel programma DARPA XAI, che si è concentrato principalmente su quello che chiamiamo il paradigma utente passivo macchina-attivo", ha detto a TechXplore il prof. Yixin Zhu, uno dei supervisori del progetto. "In questi paradigmi, gli utenti umani devono controllare attivamente e tentare di capire cosa sta facendo la macchina (quindi 'utente attivo') sfruttando alcuni modelli che rivelano il potenziale processo decisionale dei modelli di IA."

I sistemi XAI che seguono quello che il Prof. Zhu definisce il paradigma "utente passivo macchina-attivo" richiedono agli utenti di verificare costantemente con l'IA per comprendere i processi alla base delle sue decisioni. In questo contesto, la comprensione da parte dell'utente dei processi di un'IA e la fiducia nelle sue previsioni non ha alcun impatto sui futuri processi decisionali dell'IA, motivo per cui la macchina viene definita "passiva".

Al contrario, il nuovo paradigma introdotto dal Dr. Yuan, dal Prof. Zhu e dai loro colleghi segue quello che il team definisce un paradigma utente attivo macchina attivo. Ciò significa essenzialmente che il loro sistema può apprendere attivamente e adattare il proprio processo decisionale in base al feedback ricevuto dagli utenti al volo. Questa capacità di adattarsi contestualmente è caratteristica di quella che viene spesso definita la terza/prossima ondata di IA.

"Affinché i sistemi di intelligenza artificiale assistano i loro utenti come ci aspettiamo, i sistemi attuali richiedono che l'utente codifichi obiettivi definiti da esperti", ha affermato il dottor Yuan. "Ciò limita il potenziale del teaming uomo-macchina, poiché tali obiettivi possono essere difficili da definire in molte attività, rendendo i sistemi di intelligenza artificiale inaccessibili alla maggior parte delle persone. Per affrontare questo problema, il nostro lavoro consente ai robot di stimare le intenzioni e i valori degli utenti durante la collaborazione in tempo reale, risparmiando la necessità di codificare in anticipo obiettivi complicati e specifici per i robot, fornendo così un migliore paradigma di teaming uomo-macchina."

L'obiettivo del sistema creato dal Dr. Yuan e dai suoi colleghi è raggiungere il cosiddetto "allineamento dei valori". Ciò significa essenzialmente che un utente umano può capire perché un robot o una macchina agisce in un modo specifico o giunge a conclusioni specifiche e la macchina o il robot può dedurre perché l'utente umano agisce in modi specifici. Questo può migliorare significativamente la comunicazione uomo-robot.

"Questa natura bidirezionale e le prestazioni in tempo reale sono le maggiori sfide del problema e il momento clou dei nostri contributi", ha affermato il prof. Zhu. "Mettendo insieme i punti precedenti, penso che ora capirai perché il titolo del nostro articolo è "Allineamento del valore uomo-robot bidirezionale in situ".

Per addestrare e testare il loro sistema XAI, i ricercatori hanno progettato un gioco chiamato "esplorazione scout", in cui gli esseri umani devono completare un'attività in team. Uno degli aspetti più importanti di questo gioco è che gli esseri umani e i robot devono allineare le loro cosiddette "funzioni di valore".

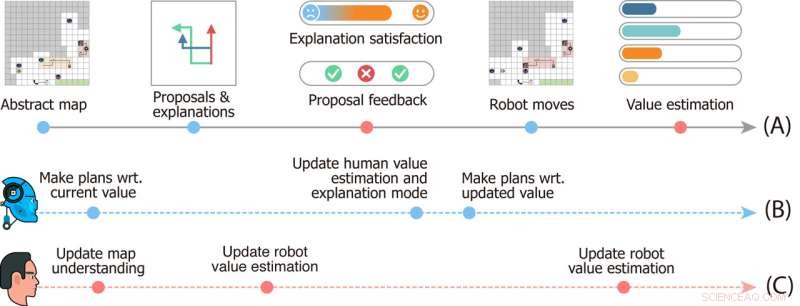

Progettazione dello studio del gioco di esplorazione scout. Timeline (A) indica gli eventi che accadono in un singolo round del gioco. Le linee temporali (B) e (C) descrivono rispettivamente le dinamiche mentali dei robot e dell'utente. Credito immagine:Sig.ra Zhen Chen@BIGAI.

"Nel gioco, un gruppo di robot può percepire l'ambiente; questo emula le applicazioni del mondo reale in cui il gruppo di robot dovrebbe lavorare autonomamente per ridurre al minimo gli interventi umani", ha affermato il prof. Zhu. "L'utente umano, tuttavia, non può interagire direttamente con l'ambiente; all'utente è stata invece assegnata una particolare funzione di valore, rappresentata dall'importanza di alcuni fattori (es. tempo totale per completare il tempo e risorse raccolte in movimento )."

Nel gioco di esplorazione scout, il team di robot non ha accesso alla funzione di valore data agli utenti umani e deve dedurla. Poiché questo valore non può essere facilmente espresso e comunicato, per completare il compito il robot e il team umano devono dedurlo l'uno dall'altro.

"La comunicazione è bidirezionale nel gioco:da un lato, il robot propone all'utente più piani di attività e spiega i pro e i contro di ciascuno di essi, e dall'altro l'utente fornisce feedback sulle proposte e valuta ogni spiegazione, "Il dottor Xiaofeng Gao, uno dei primi autori del documento, ha detto a TechXplore. "Queste comunicazioni bidirezionali consentono ciò che è noto come allineamento del valore".

In sostanza, per completare le attività di "esplorazione scout", il team di robot deve capire quale funzione di valore degli utenti umani si basa semplicemente sul feedback dell'uomo. Nel frattempo, gli utenti umani apprendono le stime del valore attuale dei robot e possono offrire un feedback che li aiuta a migliorare e, in definitiva, li guida verso la risposta corretta.

"Abbiamo anche integrato la teoria della mente nel nostro modello computazionale, consentendo al sistema di intelligenza artificiale di generare spiegazioni adeguate per rivelare il suo valore attuale e stimare il valore degli utenti dal loro feedback in tempo reale durante l'interazione", ha affermato il dottor Gao. "Abbiamo quindi condotto studi approfonditi sugli utenti per valutare il nostro framework".

Nelle valutazioni iniziali, il sistema creato dal Dr. Yuan, dal Prof. Zhu, dal Dr. Gao e dai loro colleghi ha ottenuto risultati notevoli, portando all'allineamento dei valori nel gioco di esplorazione dello scout al volo e in modo interattivo. Il team ha scoperto che il robot si è allineato con la funzione di valore dell'utente umano già nel 25% del gioco, mentre gli utenti potrebbero ottenere percezioni accurate delle funzioni di valore della macchina a metà del gioco.

"L'abbinamento della convergenza (i) dal valore dei robot ai valori reali dell'utente e (ii) dalla stima dell'utente dei valori dei robot ai valori attuali dei robot forma un allineamento di valori bidirezionale ancorato al valore reale dell'utente", ha affermato il dott. Yuan ha detto. "Riteniamo che la nostra struttura evidenzi la necessità di costruire macchine intelligenti che apprendano e comprendano le nostre intenzioni e valori attraverso le interazioni, che sono fondamentali per evitare molte delle storie di fantascienza distopiche rappresentate nei romanzi e sul grande schermo."

Il recente lavoro di questo team di ricercatori è un contributo significativo all'area di ricerca incentrata sullo sviluppo di un'IA più comprensibile. Il sistema proposto potrebbe servire da ispirazione per la creazione di altri sistemi XAI in cui robot o assistenti intelligenti interagiscono attivamente con gli esseri umani, condividendo i loro processi e migliorando le loro prestazioni in base al feedback che ricevono dagli utenti.

"L'allineamento dei valori è il nostro primo passo verso la collaborazione uomo-robot generico", ha spiegato il dottor Yuan. "In questo lavoro, l'allineamento del valore avviene nel contesto di una singola attività. Tuttavia, in molti casi, un gruppo di agenti collabora in molte attività. Ad esempio, ci aspettiamo che un robot domestico ci aiuti con molte faccende quotidiane, invece di acquistare molti robot, ciascuno in grado di svolgere un solo tipo di lavoro."

Finora, il sistema XAI dei ricercatori ha ottenuto risultati molto promettenti. Nei loro prossimi studi, il Dr. Yuan, il Prof. Zhu, il Dr. Gao e i loro colleghi hanno in programma di esplorare casi di allineamento del valore uomo-robot che potrebbero essere applicati in molte diverse attività del mondo reale, in modo che gli utenti umani e gli agenti dell'IA possano accumularsi informazioni che hanno acquisito sui reciproci processi e capacità mentre collaborano a compiti diversi.

"Nei nostri prossimi studi, cerchiamo anche di applicare la nostra struttura a più compiti e robot fisici", ha affermato il dottor Gao. "Oltre ai valori, crediamo che allineare altri aspetti dei modelli mentali (ad es. Credenze, desideri, intenzioni) tra umani e robot sarebbe anche una direzione promettente".

I ricercatori sperano che il loro nuovo paradigma di intelligenza artificiale spiegabile aiuterà a migliorare la collaborazione tra esseri umani e macchine su numerosi compiti. Inoltre, sperano che il loro approccio aumenterà la fiducia degli esseri umani nei sistemi basati sull'intelligenza artificiale, inclusi assistenti intelligenti, robot, bot e altri agenti virtuali.

"Ad esempio, puoi correggere Alexa o Google Home quando commette un errore, ma farà lo stesso errore la prossima volta che lo utilizzerai", ha aggiunto il prof. Zhu. "Quando il tuo Roomba va da qualche parte in cui non vuoi che vada e cerca di combatterlo, non capisce perché segue solo la logica dell'IA predefinita. Tutto ciò vieta all'IA moderna di entrare nelle nostre case. Come primo passo, il nostro lavoro mostra il potenziale per risolvere questi problemi, un passo avanti verso il raggiungimento di ciò che la DARPA ha chiamato "adattamento contestuale" nella terza ondata di intelligenza artificiale". + Esplora ulteriormente

© 2022 Rete Science X