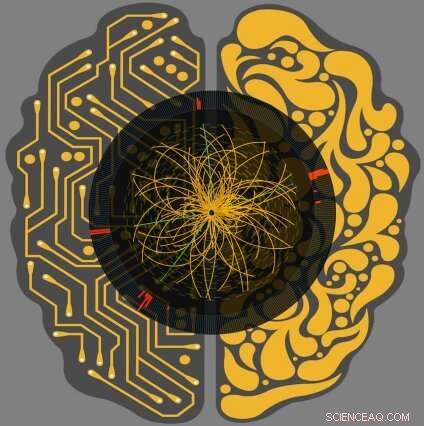

L'intelligenza artificiale interfacciata con il Large Hadron Collider può portare a una maggiore precisione nell'analisi dei dati, che possono migliorare le misurazioni delle proprietà fisiche fondamentali e potenzialmente portare a nuove scoperte. Credito:FermiLab

Una nuova tecnologia di apprendimento automatico testata da un team internazionale di scienziati tra cui l'assistente professore del MIT Philip Harris e il postdoc Dylan Rankin, sia del Laboratorio di Scienze Nucleari, può individuare tracce di particelle specifiche in un oceano di dati del Large Hadron Collider (LHC) in un batter d'occhio.

Sofisticato e rapido, il nuovo sistema offre uno sguardo al ruolo rivoluzionario che l'apprendimento automatico giocherà nelle future scoperte nella fisica delle particelle man mano che i set di dati diventano più grandi e più complessi.

L'LHC crea circa 40 milioni di collisioni ogni secondo. Con una quantità così grande di dati da vagliare, ci vogliono computer potenti per identificare quelle collisioni che possono interessare gli scienziati, se, forse, un accenno di materia oscura o una particella di Higgs.

Ora, scienziati del Fermilab, CERN, MIT, l'Università di Washington, e altrove hanno testato un sistema di apprendimento automatico che accelera l'elaborazione da 30 a 175 volte rispetto ai metodi esistenti.

Tali metodi attualmente elaborano meno di un'immagine al secondo. In contrasto, il nuovo sistema di apprendimento automatico può rivedere fino a 600 immagini al secondo. Durante il suo periodo di formazione, il sistema ha imparato a individuare un tipo specifico di pattern di particelle post-collisione.

"I modelli di collisione che stiamo identificando, quark superiori, sono una delle particelle fondamentali che sondano al Large Hadron Collider, "dice Harris, che è membro del Dipartimento di Fisica del MIT. "È molto importante analizzare quanti più dati possibile. Ogni dato contiene informazioni interessanti su come interagiscono le particelle".

Questi dati arriveranno come mai prima d'ora dopo il completamento degli attuali aggiornamenti di LHC; entro il 2026, si prevede che l'acceleratore di particelle di 17 miglia produrrà 20 volte la quantità di dati che produce attualmente. Per rendere le cose ancora più urgenti, anche le immagini future verranno scattate a risoluzioni più elevate di quelle attuali. In tutto, scienziati e ingegneri stimano che LHC avrà bisogno di più di 10 volte la potenza di calcolo che ha attualmente.

"La sfida della corsa futura, "dice Harris, "diventa sempre più difficile man mano che i nostri calcoli diventano più accurati e indaghiamo effetti sempre più precisi".

I ricercatori del progetto hanno addestrato il loro nuovo sistema per identificare le immagini dei quark top, il tipo più massiccio di particella elementare, circa 180 volte più pesante di un protone. "Con le architetture di machine learning a nostra disposizione, siamo in grado di ottenere risultati di alta qualità scientifica, paragonabile ai migliori algoritmi di identificazione dei quark top al mondo, " spiega Harris. "L'implementazione di algoritmi di base ad alta velocità ci offre la flessibilità necessaria per migliorare l'elaborazione LHC nei momenti critici in cui è più necessaria".

Questa storia è stata ripubblicata per gentile concessione di MIT News (web.mit.edu/newsoffice/), un popolare sito che copre notizie sulla ricerca del MIT, innovazione e didattica.