Un rivelatore di muoni a forma di ruota fa parte di un aggiornamento del rivelatore di particelle ATLAS al CERN. Un nuovo studio applica "unfolding, " o tecniche di correzione degli errori utilizzate per i rilevatori di particelle, ai problemi con il rumore nell'informatica quantistica. Credito:Julien Marius Ordan/CERN

Prendendo in prestito una pagina dai libri di testo di fisica e astronomia delle alte energie, un team di fisici e scienziati informatici presso il Lawrence Berkeley National Laboratory (Berkeley Lab) del Dipartimento dell'energia degli Stati Uniti ha adattato e applicato con successo una tecnica comune di riduzione degli errori nel campo dell'informatica quantistica.

Nel mondo delle particelle subatomiche e dei rivelatori di particelle giganti, e galassie lontane e telescopi giganti, gli scienziati hanno imparato a vivere, e lavorare, con incertezza. Stanno spesso cercando di estrarre interazioni di particelle ultra rare da un enorme groviglio di interazioni di altre particelle e "rumore" di fondo che può complicare la loro caccia, o cercando di filtrare gli effetti delle distorsioni atmosferiche e della polvere interstellare per migliorare la risoluzione delle immagini astronomiche.

Anche, problemi intrinseci con i rilevatori, come con la loro capacità di registrare tutte le interazioni delle particelle o di misurare esattamente le energie delle particelle, può comportare la lettura errata dei dati da parte dell'elettronica a cui sono collegati, quindi gli scienziati devono progettare filtri complessi, sotto forma di algoritmi informatici, per ridurre il margine di errore e restituire i risultati più accurati.

I problemi del rumore e dei difetti fisici, e la necessità di algoritmi di correzione e mitigazione degli errori, che riducono la frequenza e la gravità degli errori, sono comuni anche nel nascente campo dell'informatica quantistica, e uno studio pubblicato sulla rivista npj Informazioni quantistiche scoperto che sembrano esserci alcune soluzioni comuni, pure.

Ben Nachman, un fisico del Berkeley Lab coinvolto in esperimenti di fisica delle particelle al CERN come membro del gruppo ATLAS del Berkeley Lab, ha visto la connessione del calcolo quantistico mentre lavorava a un calcolo di fisica delle particelle con Christian Bauer, un fisico teorico del Berkeley Lab che è coautore dello studio. ATLAS è uno dei quattro rivelatori di particelle giganti al Large Hadron Collider del CERN, il più grande e potente collisore di particelle al mondo.

"In ATLAS, spesso dobbiamo 'spiegarci, ' o correggere per gli effetti del rivelatore, " disse Nachman, l'autore principale dello studio. "Le persone hanno sviluppato questa tecnica per anni".

Negli esperimenti all'LHC, particelle chiamate protoni si scontrano a una velocità di circa 1 miliardo di volte al secondo. Per far fronte a questo incredibilmente impegnato, ambiente "rumoroso" e problemi intrinseci legati alla risoluzione energetica e altri fattori associati ai rivelatori, i fisici usano tecniche di "dispiegamento" per la correzione degli errori e altri filtri per vagliare questo guazzabuglio di particelle fino ai più utili, dati accurati.

"Ci siamo resi conto che gli attuali computer quantistici sono molto rumorosi, pure, " Nachman ha detto, quindi trovare un modo per ridurre questo rumore e ridurre al minimo gli errori - la mitigazione degli errori - è una chiave per far progredire l'informatica quantistica. "Un tipo di errore è legato alle operazioni effettive che fai, e uno riguarda la lettura dello stato del computer quantistico, " osservò:quel primo tipo è noto come errore di gate, e quest'ultimo è chiamato errore di lettura.

L'ultimo studio si concentra su una tecnica per ridurre gli errori di lettura, chiamato "dispiegamento bayesiano iterativo" (IBU), che è familiare alla comunità della fisica delle alte energie. Lo studio confronta l'efficacia di questo approccio con altre tecniche di correzione e mitigazione degli errori. Il metodo IBU si basa sul teorema di Bayes, che fornisce un modo matematico per trovare la probabilità che un evento si verifichi quando ci sono altre condizioni relative a questo evento che sono già note.

Nachman ha notato che questa tecnica può essere applicata all'analogo quantistico dei computer classici, noti come computer quantistici basati su porte universali.

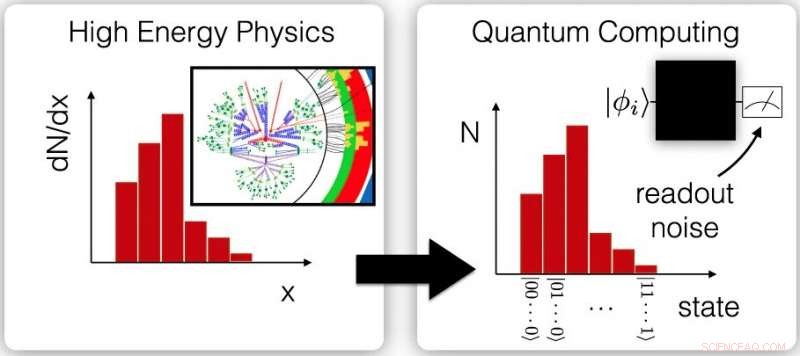

Questi grafici mostrano la connessione tra misurazioni ordinate della fisica delle alte energie relative alla dispersione delle particelle, chiamate misurazioni della sezione trasversale differenziale (a sinistra) e misurazioni ripetute degli output dei computer quantistici (a destra). Queste somiglianze offrono l'opportunità di applicare tecniche di mitigazione degli errori simili ai dati di entrambi i campi. Credito:Berkeley Lab; npj Quantum Inf 6, 84 (2020), DAINA:10.1038/s41534-020-00309-7

Nell'informatica quantistica, che si basa su bit quantistici, o qubit, trasportare informazioni, lo stato fragile noto come sovrapposizione quantistica è difficile da mantenere e può decadere nel tempo, facendo in modo che un qubit visualizzi uno zero anziché uno:questo è un esempio comune di errore di lettura.

La sovrapposizione prevede che un bit quantistico possa rappresentare uno zero, un solo, o entrambe le quantità contemporaneamente. Ciò consente capacità di elaborazione uniche non possibili nell'elaborazione convenzionale, che si basano su bit che rappresentano un uno o uno zero, ma non entrambi contemporaneamente. Un'altra fonte di errore di lettura nei computer quantistici è semplicemente una misurazione errata dello stato di un qubit a causa dell'architettura del computer.

Nello studio, i ricercatori hanno simulato un computer quantistico per confrontare le prestazioni di tre diverse tecniche di correzione degli errori (o attenuazione degli errori o spiegamento). Hanno scoperto che il metodo IBU è più robusto in un ambiente molto rumoroso, ambiente soggetto a errori, e ha leggermente superato gli altri due in presenza di modelli di rumore più comuni. Le sue prestazioni sono state confrontate con un metodo di correzione degli errori chiamato Ignis che fa parte di una raccolta di strumenti di sviluppo software di calcolo quantistico open source sviluppati per i computer quantistici di IBM, e una forma molto elementare di dispiegamento nota come metodo di inversione della matrice.

I ricercatori hanno utilizzato l'ambiente di calcolo quantistico simulato per produrre più di 1, 000 pseudo-esperimenti, e hanno scoperto che i risultati per il metodo IBU erano i più vicini alle previsioni. I modelli di rumore utilizzati per questa analisi sono stati misurati su un computer quantistico da 20 qubit chiamato IBM Q Johannesburg.

"Abbiamo preso una tecnica molto comune dalla fisica delle alte energie, e l'ha applicato all'informatica quantistica, e ha funzionato davvero bene, come dovrebbe, " Ha detto Nachman. C'era una curva di apprendimento ripida. "Ho dovuto imparare ogni sorta di cose sull'informatica quantistica per essere sicuro di sapere come tradurla e implementarla su un computer quantistico".

Ha detto che è stato anche molto fortunato a trovare collaboratori per lo studio con esperienza nell'informatica quantistica al Berkeley Lab, compreso Bert de Jong, che guida un DOE Office of Advanced Scientific Computing Research Quantum Algorithms Team e un progetto Accelerated Research for Quantum Computing nella divisione di ricerca computazionale del Berkeley Lab.

"È emozionante vedere come la pletora di conoscenze che la comunità dei fisici delle alte energie ha sviluppato per ottenere il massimo da esperimenti rumorosi possa essere utilizzata per ottenere di più da computer quantistici rumorosi, " ha detto de Jong.

I computer quantistici simulati e reali utilizzati nello studio variavano da cinque qubit a 20 qubit, e la tecnica dovrebbe essere scalabile a sistemi più grandi, disse Nachman. Ma le tecniche di correzione e mitigazione degli errori che i ricercatori hanno testato richiederanno più risorse di calcolo con l'aumentare delle dimensioni dei computer quantistici, quindi Nachman ha affermato che il team è concentrato su come rendere i metodi più gestibili per i computer quantistici con array di qubit più grandi.

Nachman, Bauer, e de Jong hanno anche partecipato a uno studio precedente che propone un modo per ridurre gli errori di gate, che è l'altra principale fonte di errori di calcolo quantistico. Ritengono che la correzione degli errori e la mitigazione degli errori nell'informatica quantistica possano in definitiva richiedere un approccio mix-and-match, utilizzando una combinazione di diverse tecniche.

"È un momento emozionante, " Nachman ha detto, poiché il campo dell'informatica quantistica è ancora giovane e c'è molto spazio per l'innovazione. "Le persone hanno almeno ricevuto il messaggio su questi tipi di approcci, e c'è ancora spazio per il progresso." Ha osservato che l'informatica quantistica ha fornito una "spinta a pensare ai problemi in un modo nuovo, "aggiungendo, "Ha aperto un nuovo potenziale scientifico".