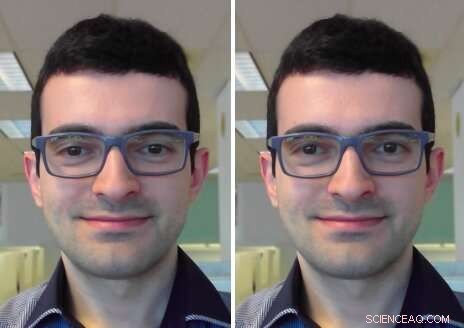

Correzione del contatto visivo:nel riquadro di input (a sinistra) l'utente sta guardando lo schermo. Nel frame di output (a destra) il suo sguardo è corretto per guardare nella telecamera. Attestazione:Isikdogan, Gerasimow &Michael.

Quando si partecipa a una videochiamata o a una conferenza, spesso è difficile mantenere un contatto visivo diretto con gli altri partecipanti, poiché ciò richiede di guardare nella fotocamera piuttosto che sullo schermo. Sebbene la maggior parte delle persone utilizzi regolarmente i servizi di videochiamata, finora, non c'è stata una soluzione diffusa a questo problema.

Un team di ricercatori di Intel ha recentemente sviluppato un modello di correzione del contatto visivo che potrebbe aiutare a superare questo fastidio ripristinando il contatto visivo nelle chat video dal vivo, indipendentemente da dove si trovano la fotocamera e il display di un dispositivo. A differenza degli approcci proposti in precedenza, questo modello centra automaticamente lo sguardo di una persona senza la necessità di input che specifichino l'angolo di reindirizzamento o la telecamera/display/geometria dell'utente.

"L'obiettivo principale del nostro progetto è migliorare la qualità delle esperienze di videoconferenza rendendo più facile mantenere il contatto visivo, "Leo Isikdogan, uno dei ricercatori che ha condotto lo studio, ha detto a TechXplore. "È difficile mantenere il contatto visivo durante una videochiamata perché non è naturale guardare nella telecamera durante una chiamata. Le persone guardano l'immagine dell'altra persona sul display, o a volte guardano anche la propria immagine di anteprima, ma non nella fotocamera. Con questa nuova funzione di correzione del contatto visivo, gli utenti potranno avere una conversazione naturale faccia a faccia."

L'obiettivo principale dello studio condotto da Isikdogan e dai suoi colleghi era creare un'esperienza di videochat naturale. Per realizzare questo, volevano che la loro funzione di correzione del contatto visivo funzionasse solo quando un utente è coinvolto nella conversazione, piuttosto che quando distolgono naturalmente gli occhi dallo schermo (ad esempio quando guardano fogli o manipolano oggetti nell'ambiente circostante).

"Correzione del contatto visivo e reindirizzamento dello sguardo in generale, non sono nuove idee di ricerca, " Ha detto Isikdogan. "Molti ricercatori hanno proposto modelli per manipolare dove le persone stanno guardando nelle immagini. Però, alcuni di questi richiedono configurazioni hardware speciali, altri necessitano di ulteriori informazioni dall'utente, come verso quale direzione e di quanto deve essere il reindirizzamento, e altri utilizzano processi computazionalmente costosi che sono fattibili solo per l'elaborazione di video preregistrati."

Il nuovo sistema sviluppato da Isikdogan e dai suoi colleghi utilizza una rete neurale convoluzionale profonda (CNN) per reindirizzare lo sguardo di una persona deformando e sintonizzando gli occhi nei suoi frame di input. Essenzialmente, la CNN elabora un'immagine monoculare e produce un campo vettoriale e una mappa di luminosità per correggere lo sguardo dell'utente.

In contrasto con gli approcci precedentemente proposti, il loro sistema può funzionare in tempo reale, pronto all'uso e senza richiedere alcun input da parte degli utenti o hardware dedicato. Inoltre, il correttore funziona su una varietà di dispositivi con diverse dimensioni del display e posizioni della fotocamera.

"Il nostro correttore del contatto visivo utilizza una serie di meccanismi di controllo che prevengono cambiamenti improvvisi e assicurano che il correttore del contatto visivo eviti di eseguire qualsiasi correzione innaturale che altrimenti sarebbe inquietante, " ha detto Isikdogan. "Per esempio, la correzione viene facilmente disabilitata quando l'utente sbatte le palpebre o guarda da qualche parte lontano."

I ricercatori hanno addestrato il loro modello in modo bidirezionale su un ampio set di dati di dati generati sinteticamente, immagini fotorealistiche ed etichettate. Hanno quindi valutato la sua efficacia e il modo in cui gli utenti l'hanno percepita in una serie di test alla cieca.

"I nostri test alla cieca hanno mostrato che la maggior parte delle persone non sa quando accendiamo o spegniamo il nostro algoritmo, non vedono artefatti ma si sentono come se avessero un contatto visivo con la persona con cui stanno comunicando, "Gilad Michele, un altro ricercatore coinvolto nello studio, ha detto a TechXplore.

interessante, i ricercatori hanno osservato che il loro modello aveva anche imparato a prevedere lo sguardo in ingresso (cioè, dove pensava che un utente stesse guardando prima che il suo sguardo fosse corretto), anche se non è mai stato addestrato a farlo. Credono che questa capacità possa essere un sottoprodotto del continuo reindirizzamento del modello dello sguardo dell'utente al centro, senza specificare dove un utente stava guardando in primo luogo.

"Il modello ha semplicemente dedotto lo sguardo in ingresso in modo che possa spostarlo al centro, " ha spiegato Isikdogan. "Pertanto, possiamo discutibilmente considerare il problema della correzione del contatto visivo come un parziale superset di previsione dello sguardo".

I risultati raccolti dai ricercatori evidenziano anche il valore dell'utilizzo di dati sintetici fotorealistici per addestrare algoritmi. Infatti, il loro modello ha ottenuto risultati notevoli anche se durante l'addestramento si è basato quasi interamente su immagini generate al computer. I ricercatori sono tutt'altro che i primi a sperimentare dati di allenamento sintetici, eppure il loro studio è un'ulteriore conferma delle sue potenzialità per la realizzazione di applicazioni altamente performanti.

"Abbiamo anche confermato che è una buona pratica tenere a mente la reversibilità della mappatura quando si costruiscono modelli che manipolano i loro input, " ha aggiunto Isikdogan. "Ad esempio, se il modello si sposta di alcuni pixel dal basso a sinistra al centro, dovremmo essere in grado di chiedere al modello di spostarli indietro in basso a sinistra e ottenere un'immagine che sembra quasi identica all'immagine originale. Questo approccio impedisce al modello di modificare le immagini in modo irreparabile".

Nel futuro, il sistema proposto da Isikdogan, Michael e il loro collega Timo Gerasimow potrebbero aiutare a migliorare le esperienze di videoconferenza, avvicinandoli ancora di più alle interazioni di persona. I ricercatori stanno ora pianificando di finalizzare il loro sistema in modo che possa essere applicato ai servizi di videoconferenza esistenti.

"Ci impegniamo molto per assicurarci che la nostra soluzione sia pratica e pronta per essere utilizzata in prodotti reali, "Michael ha detto. "Ora potremmo provare a migliorare alcuni dei risultati dei sottoprodotti dell'algoritmo come il rilevamento dello sguardo e la valutazione del coinvolgimento per consentire casi d'uso adiacenti".

© 2019 Scienza X Rete