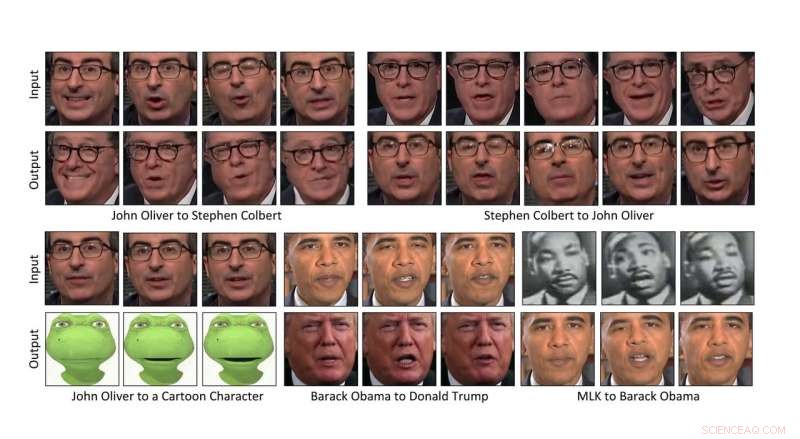

I ricercatori della Carnegie Mellon University hanno escogitato un modo per trasformare automaticamente il contenuto di un video nello stile di un altro, rendendo possibile trasferire le espressioni facciali di una persona al video di un'altra persona, o anche un personaggio dei cartoni animati. Credito:Carnegie Mellon University

I ricercatori della Carnegie Mellon University hanno escogitato un modo per trasformare automaticamente il contenuto di un video nello stile di un altro, che consente di trasferire le espressioni facciali del comico John Oliver a quelle di un personaggio dei cartoni animati, o per far fiorire un narciso più o meno allo stesso modo di un ibisco.

Poiché il metodo basato sui dati non richiede l'intervento umano, può trasformare rapidamente grandi quantità di video, rendendolo un vantaggio per la produzione cinematografica. Può anche essere utilizzato per convertire film in bianco e nero a colori e per creare contenuti per esperienze di realtà virtuale.

"Penso che ci siano molte storie da raccontare, " disse Aayush Bansal, un dottorato di ricerca studente presso l'Istituto di Robotica della CMU. La produzione cinematografica è stata la sua motivazione principale nell'aiutare a ideare il metodo, Lui ha spiegato, consentendo di produrre film in modo più rapido ed economico. "È uno strumento per l'artista che dà loro un modello iniziale che possono poi migliorare, " Ha aggiunto.

La tecnologia ha anche il potenziale per essere utilizzata per i cosiddetti "falsi profondi, " video in cui viene inserita l'immagine di una persona senza autorizzazione, far sembrare che la persona abbia fatto o detto cose che sono fuori dal suo carattere, Bansale riconosciuto.

"È stata una rivelazione per tutti noi del settore che tali falsi sarebbero stati creati e avrebbero avuto un tale impatto, " ha detto. "Trovare il modo per rilevarli sarà importante andare avanti".

Bansal presenterà oggi il metodo all'ECCV 2018, la Conferenza europea sulla visione artificiale, a Monaco di Baviera. I suoi coautori includono Deva Ramanan, Professore associato di robotica alla CMU.

Il trasferimento di contenuti da un video allo stile di un altro si basa sull'intelligenza artificiale. In particolare, una classe di algoritmi chiamati reti generative avversarie (GAN) ha reso più facile per i computer capire come applicare lo stile di un'immagine a un'altra, soprattutto quando non sono stati accuratamente abbinati.

In un GAN, vengono creati due modelli:un discriminatore che impara a rilevare ciò che è coerente con lo stile di un'immagine o video, e un generatore che impara a creare immagini o video che corrispondono a un certo stile. Quando i due lavorano in modo competitivo - il generatore che cerca di ingannare il discriminatore e il discriminatore che valuta l'efficacia del generatore - il sistema alla fine impara come il contenuto può essere trasformato in un certo stile.

Una variante, chiamato ciclo-GAN, completa il ciclo, proprio come tradurre il discorso inglese in spagnolo e poi lo spagnolo di nuovo in inglese e quindi valutare se il discorso tradotto due volte ha ancora senso. L'utilizzo del ciclo-GAN per analizzare le caratteristiche spaziali delle immagini si è dimostrato efficace nel trasformare un'immagine nello stile di un'altra.

Quel metodo spaziale lascia ancora a desiderare per i video, con artefatti e imperfezioni indesiderati che emergono nell'intero ciclo di traduzioni. Per mitigare il problema, i ricercatori hanno sviluppato una tecnica, chiamato Recycle-GAN, che incorpora non solo spaziale, ma informazioni temporali. Queste informazioni aggiuntive, tenendo conto dei cambiamenti nel tempo, limita ulteriormente il processo e produce risultati migliori.

I ricercatori hanno dimostrato che Recycle-GAN può essere utilizzato per trasformare il video di Oliver in quello che sembra essere il collega comico Stephen Colbert e di nuovo in Oliver. Oppure il video del volto di John Oliver può essere trasformato in un personaggio dei cartoni animati. Recycle-GAN consente non solo di copiare le espressioni facciali, ma anche i movimenti e la cadenza della performance.

Gli effetti non si limitano ai volti, o anche corpi. I ricercatori hanno dimostrato che il video di un fiore che sboccia può essere utilizzato per manipolare l'immagine di altri tipi di fiori. Oppure le nuvole che attraversano rapidamente il cielo in una giornata ventosa possono essere rallentate per dare l'impressione di un clima più calmo.

Tali effetti potrebbero essere utili nello sviluppo di auto a guida autonoma in grado di navigare di notte o in caso di maltempo, disse Bansal. Ottenere video di scene notturne o tempeste in cui gli oggetti possono essere identificati ed etichettati può essere difficile, Lui ha spiegato. Riciclare-GAN, d'altra parte, può trasformare scene diurne facilmente ottenute ed etichettate in scene notturne o tempestose, fornendo immagini che possono essere utilizzate per addestrare le auto a operare in quelle condizioni.