Credito:Zimmer, Bonifacio, e Dutech.

I ricercatori dell'Università della Lorena hanno recentemente ideato un nuovo tipo di apprendimento di trasferimento basato sull'apprendimento per rinforzo profondo senza modelli con un ampliamento continuo dello spazio sensomotorio. Il loro approccio, presentato in un articolo pubblicato durante l'ottava Conferenza internazionale congiunta IEEE sullo sviluppo e l'apprendimento e sulla robotica epigenetica, e disponibile gratuitamente su HAL Archives-ouvertes, si ispira allo sviluppo del bambino, in particolare dalla crescita dello spazio sensomotorio che si verifica quando il bambino acquisisce nuove strategie utili.

"Il quadro formale dell'apprendimento per rinforzo può essere utilizzato per modellare un'ampia gamma di problemi, "ha detto Matthieu Zimmer, uno dei ricercatori che ha condotto lo studio. "In questo quadro, un agente utilizza un metodo per tentativi ed errori per apprendere lentamente quale sequenza di azioni è la più appropriata per raggiungere l'obiettivo desiderato. Se vengono soddisfatti alcuni requisiti, quindi la teoria ci dice che abbiamo algoritmi che l'agente può usare per trovare la soluzione ottimale al problema, tuttavia questo può richiedere lunghi periodi di tempo. Per accelerare questo processo, abbiamo esplorato i modi in cui un agente può ottenere buone prestazioni in un minor numero di prove, anche quando non ha quasi alcuna conoscenza del compito che dovrà risolvere."

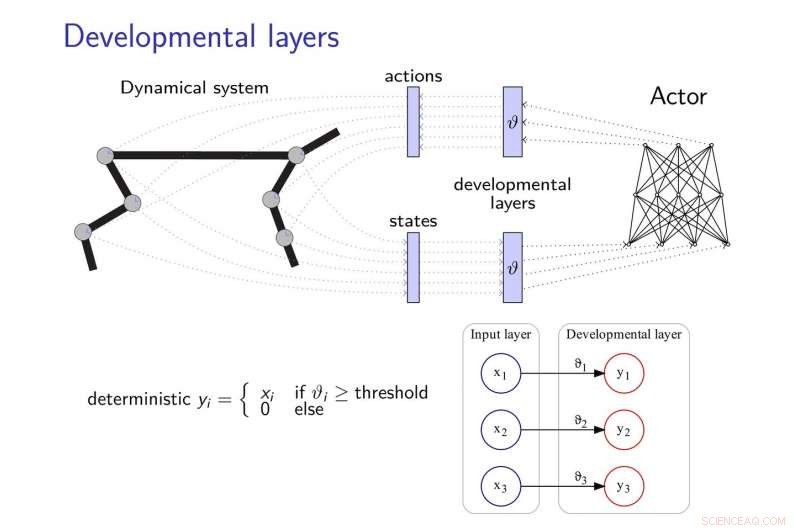

Il metodo di apprendimento del trasferimento proposto da Zimmer e dai suoi colleghi aggiunge livelli di sviluppo alle reti neurali, consentendo loro di sviluppare nuove strategie per completare le attività, soprattutto quando questi compiti sono in qualche modo correlati. Questi strati evolutivi scoprono progressivamente alcune dimensioni dello spazio sensomotorio, seguendo una motivazione euristica intrinseca.

Per mitigare gli effetti dell'"oblio catastrofico, "un problema comune nello sviluppo delle reti neurali, i ricercatori si sono ispirati alla teoria del consolidamento del peso elastico, usandolo per regolare l'apprendimento del controller neurale.

Credito:Zimmer, Bonifacio, e Dutech.

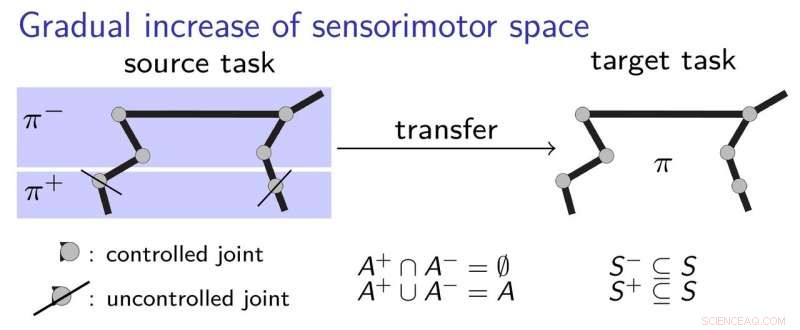

"L'idea di base del nostro lavoro è che l'agente inizi con capacità di percezione e azione molto limitate e poi le sviluppi in modo evolutivo, ispirato da come un bambino impara, "ha detto Alain Dutech, un altro ricercatore che ha condotto lo studio. "Lo spazio in cui l'agente cerca una soluzione si riduce così, e questa soluzione, anche se a un problema degradato, può essere trovato più facilmente. Quindi aumentiamo le capacità dell'agente, sfruttando la precedente soluzione trovata."

Per spiegare meglio come funziona il loro approccio all'apprendimento per trasferimento, i ricercatori usano l'esempio di un bambino che impara ad afferrare una penna. Inizialmente, il bambino potrebbe usare solo il gomito e la spalla, imparare a toccare la penna. Successivamente, potrebbe decidere di iniziare a usare la mano e le dita, aver afferrato le basi su come stabilire al meglio il primo contatto con la penna. Ciò comporta un processo di apprendimento graduale, in cui il bambino acquisisce passo dopo passo strategie sensomotorie, senza dover imparare troppe cose in una volta.

I ricercatori hanno convalidato il loro nuovo approccio utilizzando due algoritmi di deep learning all'avanguardia, vale a dire DDPG e NFAC, testato su Half-Cheetah e Humanoid, due benchmark ambientali ad alta dimensionalità. I loro risultati suggeriscono che la ricerca di una soluzione subottimale in un sottoinsieme dello spazio dei parametri prima di considerare lo spazio completo è una tecnica utile per avviare algoritmi di apprendimento, ottenere prestazioni migliori con un allenamento più breve.

"Nel campo molto attivo e stimolante dell'apprendimento di rinforzo profondo, abbiamo dimostrato che metodi di sviluppo come il nostro, così come altri simili esplorati da altri ricercatori, potrebbe essere combinato con metodi di deep learning per consentire l'apprendimento da zero, con poche conoscenze pregresse, " disse Zimmer.

Nonostante i suoi promettenti risultati, lo studio condotto da Zimmer e dai suoi colleghi ha anche evidenziato il divario che ancora esiste tra le capacità delle reti neurali profonde e gli esseri umani. Infatti, anche quando si utilizza l'apprendimento per rinforzo dello sviluppo, la maggior parte degli agenti esistenti è ancora molto meno versatile ed efficiente degli umani.

"Qualche volta, gli umani possono imparare in una sola prova, eppure anche l'apprendimento artificiale più efficiente richiederà una complessa combinazione di diversi algoritmi per apprendere, stima, memorizzare, confrontare, e ottimizzare, " Zimmer ha detto. "Inoltre, alcuni di questi algoritmi non sono ancora chiaramente definiti".

Dutech e i suoi colleghi stanno ora esplorando nuovi orizzonti nel campo dell'intelligenza artificiale e del deep learning. Ad esempio, vorrebbero sviluppare nuovi modi per un agente di apprendimento per classificare correttamente gli stimoli che percepisce.

"L'apprendimento è molto più efficiente quando l'agente può interpretare ciò che è 'vede' o 'sente', "Dutech ha spiegato. "Oggi, la tendenza è quella di utilizzare il deep learning e le reti neurali per farlo. Stiamo ora esplorando altri metodi per estrarre informazioni pertinenti e utili dalla percezione grezza di agenti artificiali, che dipendono meno dall'avere un enorme corpus di esempi; come l'apprendimento non supervisionato e l'auto-organizzazione".

© 2018 Tech Xplore