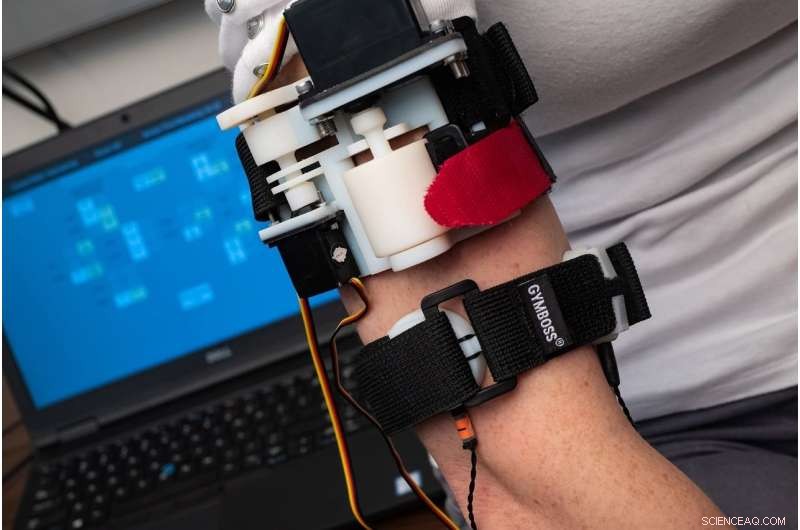

Un nuovo studio condotto da ricercatori del Laboratorio di meccatronica e interfacce aptiche della Rice University ha rilevato che gli utenti avevano bisogno di meno di due ore di formazione per imparare a "sentire" la maggior parte delle parole trasmesse da un bracciale tattile che comunica con segnali composti da compressione, allungamento e vibrazione. Credito:Jeff Fitlow/Rice University

Immagina il panico. Gli allarmi antincendio suonano. Il fumo riempie la stanza, e ti rimane solo il senso del tatto, sentendo disperatamente lungo i muri mentre cerchi di trovare la porta.

Ora immagina che la tecnologia ti guidi attraverso il senso del tatto. Il tuo smartwatch, allertati dagli stessi allarmi, comincia a "parlare" attraverso la tua pelle, dare indicazioni con vibrazioni codificate, stringe e strattona con significati chiari come parole pronunciate.

Questo scenario potrebbe svolgersi in futuro grazie alla tecnologia in fase di sviluppo nel laboratorio dell'ingegnere meccanico Rice Marcia O'Malley, che ha trascorso più di 15 anni a studiare come le persone possono usare il senso tattile per interagire con la tecnologia, che si tratti di robot, arti protesici o software per la riabilitazione dell'ictus.

"La pelle copre tutto il nostro corpo e contiene molti tipi di recettori, e lo vediamo come un canale di informazione sottoutilizzato, " disse O'Malley, direttore della Rice Robotics Initiative e del Rice's Mechatronics and Haptic Interfaces Laboratory (MAHI).

Situazioni di emergenza come lo scenario di incendio sopra descritto sono solo un esempio. O'Malley ha detto che ci sono molte "altre situazioni in cui potresti non voler guardare uno schermo, o hai già molte cose visualizzate visivamente. Per esempio, un chirurgo o un pilota potrebbe trovare molto utile avere un altro canale di comunicazione".

Lo studente laureato alla Rice University Nathan Dunkelberger al lavoro nel laboratorio MAHI. Credito:Jeff Fitlow/Rice University

Con i nuovi finanziamenti della National Science Foundation, O'Malley e la collaboratrice della Stanford University Allison Okamura inizieranno presto a progettare e testare soft, dispositivi indossabili che consentono comunicazioni dirette basate sul tocco da robot vicini. Il finanziamento, reso possibile dalla National Robotics Initiative, è orientato allo sviluppo di nuove forme di comunicazione che aggirino il disordine visivo e il rumore per comunicare in modo rapido e chiaro.

"Alcuni magazzini e fabbriche hanno già più robot che lavoratori umani, e tecnologie come le auto a guida autonoma e i dispositivi di assistenza fisica renderanno le interazioni uomo-robot molto più comuni nel prossimo futuro, " disse O'Malley, Stanley C. Moore Professor di ingegneria meccanica della Rice e professore di informatica e ingegneria elettrica e informatica.

Morbido, i dispositivi indossabili potrebbero far parte di un'uniforme, come una manica, guanto, cinturino o cintura. Fornendo una gamma di segnali tattili, come una stretta o una leggera pressione, o un tratto della pelle in una particolare direzione e luogo, O'Malley ha detto che potrebbe essere possibile costruire un significativo "vocabolario" di sensazioni che portano significati specifici.

"Riesco a vedere l'indicatore di direzione di un'auto, ma solo se lo guardo, " O'Malley ha detto. "Vogliamo una tecnologia che permetta alle persone di sentire i robot che li circondano e di capire chiaramente cosa stanno per fare quei robot e dove stanno per essere. Idealmente, se lo facciamo correttamente, gli spunti saranno facili da imparare e intuitivi."

Gli studenti laureati della Rice University Jenny Sullivan (a sinistra) e Nathan Dunkelberger dimostrano il bracciale tattile MISSIVE nel laboratorio di meccatronica e interfacce aptiche. Credito:Jeff Fitlow/Rice University

Per esempio, in uno studio presentato questo mese all'International Symposium on Wearable Computers (ISWC) a Singapore, Lo studente laureato MAHI Nathan Dunkelberger ha dimostrato che gli utenti avevano bisogno di meno di due ore di formazione per imparare a "sentire" la maggior parte delle parole trasmesse da un bracciale tattile. L'"interfaccia multisensoriale di stretch" sviluppata da MAHI, elementi vibrotattili comprimibili e integrati, " o MISSIVA, è costituito da due bande che si adattano intorno alla parte superiore del braccio. Uno di questi può spremere dolcemente, come un bracciale per la pressione sanguigna, e può anche allungare o tirare leggermente la pelle in una direzione. La seconda fascia ha motori vibrotattili, gli stessi allarmi a vibrazione utilizzati nella maggior parte dei telefoni cellulari, nella parte anteriore, Indietro, lato sinistro e destro del braccio.

Usando questi segnali in combinazione, MAHI ha creato un vocabolario di 23 dei suoni vocali più comuni per gli anglofoni. Questi suoni, che si chiamano fonemi, sono usati in combinazione per formare parole. Per esempio, le parole "ouch" e "chow" contengono gli stessi due fonemi, "ow" e "ch, " in ordine diverso. O'Malley ha detto che comunicare con i fonemi è più veloce dell'ortografia delle parole lettera per lettera, e i soggetti non hanno bisogno di sapere come si scrive una parola, solo come si pronuncia.

Dunkelberger ha detto che gli anglofoni usano 39 fonemi, ma per lo studio proof-of-concept, lui e i colleghi del MAHI hanno usato 23 dei più comuni. Nei test, ai soggetti è stato dato un addestramento limitato, solo 1 ora, 40 minuti, che hanno comportato l'ascolto del fonema parlato mentre lo si sentiva anche visualizzato da MISSIVE. Nelle prove successive, ai soggetti è stato chiesto di identificare 150 parole pronunciate composte da due a sei fonemi ciascuna. Quelli testati hanno ottenuto l'86 percento delle parole corrette.

"Ciò che mostra è che è possibile, con una formazione limitata, insegnare alle persone un piccolo vocabolario di parole che possono ricordare con elevata precisione, " O'Malley ha detto. "E ci sono sicuramente cose che potremmo ottimizzare. Potremmo rendere gli spunti più salienti. Potremmo perfezionare il protocollo di allenamento. Questo era il nostro approccio prototipo, e ha funzionato abbastanza bene".

Nel progetto NSF, ha detto che il team non si concentrerà sul trasmettere parole, ma trasmettere informazioni non verbali.

"Esistono molte potenziali applicazioni per i sistemi di feedback aptico indossabili per consentire la comunicazione tra individui, tra individui e robot o tra individui e agenti virtuali come Google Maps, " Ha detto O'Malley. "Immagina uno smartwatch in grado di trasmetterti direttamente un intero linguaggio di segnali, e privatamente, in modo da non dover guardare affatto lo schermo."