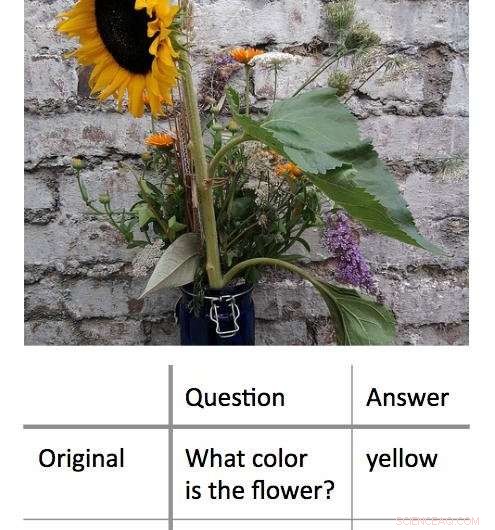

Un nuovo metodo per decodificare i processi decisionali utilizzati dagli algoritmi di apprendimento automatico "scatola nera" funziona trovando l'input minimo che produrrà comunque una risposta corretta. In questo esempio, i ricercatori hanno prima presentato un algoritmo con una foto di un girasole e hanno chiesto "Di che colore è il fiore?" Ciò ha portato alla risposta corretta, 'giallo.' I ricercatori hanno scoperto che potevano ottenere la stessa risposta corretta, con un grado di fiducia altrettanto elevato, ponendo all'algoritmo una domanda composta da una sola parola:"Fiore?" Credito:Shi Feng/Università del Maryland

Intelligenza artificiale, in particolare, apprendimento automatico:fa parte della vita quotidiana degli utenti di computer e smartphone. Dalla correzione automatica degli errori di battitura al consiglio di nuova musica, gli algoritmi di apprendimento automatico possono aiutare a semplificare la vita. Possono anche commettere errori.

Può essere difficile per gli informatici capire cosa è andato storto in questi casi. Questo perché molti algoritmi di apprendimento automatico imparano dalle informazioni e fanno le loro previsioni all'interno di una "scatola nera" virtuale, " lasciando pochi indizi da seguire per i ricercatori.

Un gruppo di scienziati informatici dell'Università del Maryland ha sviluppato un nuovo approccio promettente per l'interpretazione degli algoritmi di apprendimento automatico. A differenza dei tentativi precedenti, che in genere cercava di "rompere" gli algoritmi rimuovendo le parole chiave dagli input per fornire la risposta sbagliata, il gruppo UMD ha invece ridotto gli input al minimo indispensabile per fornire la risposta corretta. In media, i ricercatori hanno ottenuto la risposta corretta con un input di meno di tre parole.

In alcuni casi, gli algoritmi modello dei ricercatori hanno fornito la risposta corretta basata su una singola parola. frequentemente, la parola o la frase inserita sembrava avere una connessione poco evidente con la risposta, rivelando importanti intuizioni su come alcuni algoritmi reagiscono a un linguaggio specifico. Poiché molti algoritmi sono programmati per fornire una risposta indipendentemente da cosa, anche quando richiesto da un input senza senso, i risultati potrebbero aiutare gli scienziati informatici a creare algoritmi più efficaci in grado di riconoscere i propri limiti.

I ricercatori presenteranno il loro lavoro il 4 novembre, 2018 alla Conferenza 2018 sui metodi empirici nell'elaborazione del linguaggio naturale.

"I modelli a scatola nera sembrano funzionare meglio dei modelli più semplici, come alberi decisionali, ma anche le persone che hanno scritto il codice iniziale non possono dire esattamente cosa sta succedendo, " ha detto Jordan Boyd-Graber, l'autore senior dello studio e professore associato di informatica presso l'UMD. "Quando questi modelli restituiscono risposte errate o prive di senso, è difficile capire perché. Quindi invece, abbiamo cercato di trovare l'input minimo che avrebbe prodotto il risultato corretto. L'input medio era di circa tre parole, ma in alcuni casi potremmo ridurlo a una sola parola."

Credito:CC0 Dominio pubblico

In un esempio, i ricercatori hanno inserito una foto di un girasole e la domanda basata sul testo, "Di che colore è il fiore?" come input in un algoritmo modello. Questi input hanno prodotto la risposta corretta "giallo". Dopo aver riformulato la domanda in diverse combinazioni più brevi di parole, i ricercatori hanno scoperto che potevano ottenere la stessa risposta con "fiore?" come unico input di testo per l'algoritmo.

In un altro, esempio più complesso, i ricercatori hanno utilizzato il prompt, "Nel 1899, John Jacob Astor IV ha investito $ 100, 000 per Tesla per sviluppare ulteriormente e produrre un nuovo sistema di illuminazione. Anziché, Tesla ha usato i soldi per finanziare i suoi esperimenti a Colorado Springs".

Hanno quindi chiesto all'algoritmo, "In cosa Tesla ha speso i soldi di Astor?" e ricevuto la risposta corretta, "Esperimenti di Colorado Springs". Riducendo questo input alla singola parola "ha" ha prodotto la stessa risposta corretta.

Il lavoro rivela importanti informazioni sulle regole che gli algoritmi di machine learning applicano alla risoluzione dei problemi. Molti problemi del mondo reale con gli algoritmi si verificano quando un input che ha senso per gli umani si traduce in una risposta senza senso. Dimostrando che è possibile anche il contrario, che input senza senso possono anche produrre risultati corretti, risposte sensate:Boyd-Graber e i suoi colleghi dimostrano la necessità di algoritmi in grado di riconoscere quando rispondono a una domanda senza senso con un alto grado di sicurezza.

"La linea di fondo è che tutta questa roba fantasiosa di apprendimento automatico può effettivamente essere piuttosto stupida, " disse Boyd-Graber, che ha anche co-nomine presso l'Università del Maryland Institute for Advanced Computer Studies (UMIACS) e il College of Information Studies and Language Science Center dell'UMD. "Quando gli informatici addestrano questi modelli, in genere mostriamo loro solo domande o frasi reali. Non mostriamo loro frasi senza senso o singole parole. I modelli non sanno che dovrebbero essere confusi da questi esempi".

La maggior parte degli algoritmi si costringerà a fornire una risposta, anche con dati insufficienti o contrastanti, secondo Boyd-Graber. Questo potrebbe essere al centro di alcuni degli output errati o privi di senso generati dagli algoritmi di apprendimento automatico, negli algoritmi modello utilizzati per la ricerca, così come algoritmi del mondo reale che ci aiutano segnalando e-mail di spam o offrendo indicazioni stradali alternative. Comprendere di più su questi errori potrebbe aiutare gli scienziati informatici a trovare soluzioni e creare algoritmi più affidabili.

"Mostriamo che i modelli possono essere addestrati per sapere che dovrebbero essere confusi, " Boyd-Graber ha detto. "Poi possono semplicemente venire fuori e dire, 'Mi hai mostrato qualcosa che non riesco a capire.'"