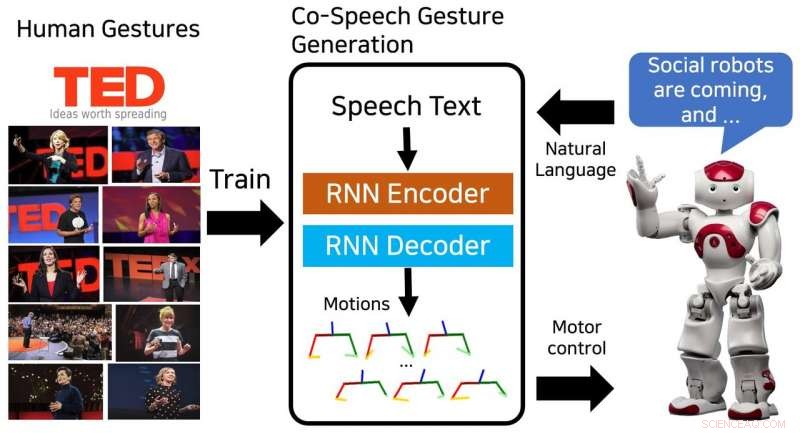

Il modello proposto genera una sequenza di pose della parte superiore del corpo ed è addestrato sui gesti umani dai discorsi TED. Credito:Yoon et al.

I ricercatori dell'Istituto di ricerca sull'elettronica e le telecomunicazioni (ETRI) in Corea del Sud hanno recentemente sviluppato un modello di rete neurale in grado di generare sequenze di gesti di co-speech. Il loro modello, addestrato su 52 ore di TED talk, ha prodotto con successo gesti simili a quelli umani che corrispondevano al contenuto del parlato.

"I dispositivi intelligenti con cui interagiamo si sono evoluti da personal computer a telefoni cellulari e altoparlanti intelligenti, " Youngwoo Yoon, uno dei ricercatori che ha condotto lo studio, ha detto a TechXplore. "Pensiamo che i robot sociali potrebbero essere la prossima piattaforma di interazione. Il movimento fisico è una delle differenze chiave tra i robot sociali e altri dispositivi intelligenti, aprendo nuove possibilità per emulare comportamenti umani o animali, che può aumentare l'intimità."

I gesti di co-speech potrebbero migliorare notevolmente la qualità delle interazioni tra umani e robot sociali. La maggior parte dei robot esistenti produce gesti utilizzando metodi di associazione discorso-gesto basati su regole. Però, queste tecniche richiedono notevoli sforzi, poiché si basano sull'esperienza e sulla conoscenza umana.

"Volevamo generare comportamenti sociali naturali e umani, soprattutto i gesti delle mani mentre si parla, " ha detto Yoon. "Osservare gli altri è un modo molto naturale di apprendere un nuovo comportamento, quindi abbiamo proposto un modello di generazione di gesti basato sull'apprendimento che è stato addestrato su un set di dati di discorsi TED".

Il modello ideato da Yoon e dai suoi colleghi è stato addestrato su un set di dati contenente 52 ore di riprese video dei colloqui TED. Dopo l'allenamento, il modello potrebbe generare sequenze di gesti simili a quelli umani e pose della parte superiore del corpo per abbinare il testo scritto del discorso.

"Progettare i comportamenti sociali dei robot è difficile e richiede tempo perché dobbiamo considerare i contesti, naturalezza, l'estetica del movimento, lo spazio di controllo dei robot, e una serie di altri fattori, "Spiega Yoon. "Recenti studi sull'apprendimento end-to-end hanno fatto luce sul potenziale delle intelligenze artificiali di generare comportamenti così complessi. Dopo aver visto applicazioni di successo nella guida autonoma e nella generazione di movimenti facciali, abbiamo deciso di applicare l'apprendimento end-to-end alla generazione di gesti di co-speech."

Il modello di rete neurale sviluppato da Yoon e dai suoi colleghi ha generato con successo diversi tipi di gesti, tra cui iconico, metaforico, deittico, e battere i gesti. Inoltre, era in grado di generare sequenze continue di gesti per testi vocali di qualsiasi lunghezza.

I ricercatori hanno scoperto che il loro metodo ha superato i metodi di base nella creazione di gesti che assomigliano a quelli degli umani. In una valutazione soggettiva, 46 persone reclutate su Amazon Mechanical Turk hanno ritenuto che i gesti generati fossero simili a quelli umani e che corrispondessero strettamente al contenuto del discorso.

"Abbiamo scoperto che i robot possono apprendere abilità sociali, " ha detto Yoon. "Per la generazione del gesto di co-speech, il modello addestrato sul set di dati su larga scala è abbastanza generale, così il robot può fare gesti simili a quelli umani per qualsiasi discorso. Pensiamo che questo approccio possa essere applicato ad altre abilità sociali, così come ai personaggi dei videogiochi e dei mondi VR."

Lo studio condotto da Yoon e dai suoi colleghi ha evidenziato il potenziale dell'apprendimento end-to-end per la generazione di gesti di co-speech. Nel futuro, potrebbe essere utilizzato per migliorare le interazioni uomo-robot e potrebbe anche ispirare ricerche simili, poiché il set di dati dei colloqui TED che hanno utilizzato è disponibile pubblicamente. I ricercatori stanno ora progettando di portare il loro studio un passo avanti, generando gesti personalizzati per diversi robot.

"I robot possono avere una propria personalità, come le persone, " ha detto Yoon. "Un metodo di generazione di gesti personalizzato potrebbe garantire che robot diversi si esprimano con diversi stili di gesti, secondo la loro persona."

© 2018 Science X Network