Credito:Marat Marihal/Shutterstock

Da quando le aziende hanno iniziato a sviluppare auto a guida autonoma, la gente ha chiesto come i designer affronteranno la questione morale di chi dovrebbe uccidere un'auto a guida autonoma se un incidente mortale è inevitabile. Ricerche recenti suggeriscono che questa domanda potrebbe essere ancora più difficile a cui rispondere per i produttori di automobili di quanto si pensasse in precedenza perché le preferenze morali delle persone variano molto da un paese all'altro.

I ricercatori, con sede presso l'Università di Harvard e il MIT, ha sviluppato un gioco online che simula situazioni in cui un incidente automobilistico mortale era inevitabile. Hanno chiesto a circa 40 milioni di persone provenienti da oltre 200 paesi di scegliere tra vari esiti di incidenti, come uccidere i pedoni piuttosto che i passeggeri dell'auto.

I risultati hanno rivelato tre cluster culturali in cui c'erano differenze significative nelle preferenze etiche che le persone avevano. Per esempio, nel cluster meridionale (che comprendeva gran parte dell'America Latina e alcune ex colonie francesi), c'era una forte preferenza per le donne rispettose degli uomini. Il cluster orientale (che comprendeva molti paesi islamici oltre alla Cina, Giappone e Corea) avevano una preferenza minore per risparmiare i giovani rispetto agli anziani.

I ricercatori hanno concluso dicendo che queste informazioni dovrebbero influenzare gli sviluppatori di auto a guida autonoma. Ma è davvero così? Mentre questo articolo evidenzia un'interessante scoperta sulle variazioni globali nelle preferenze morali, evidenzia anche un persistente malinteso sull'IA, e cosa può effettivamente fare. Data l'attuale tecnologia AI utilizzata nelle auto a guida autonoma, l'idea che un veicolo possa prendere una decisione morale è in realtà impossibile.

La fantasia della "macchina morale"

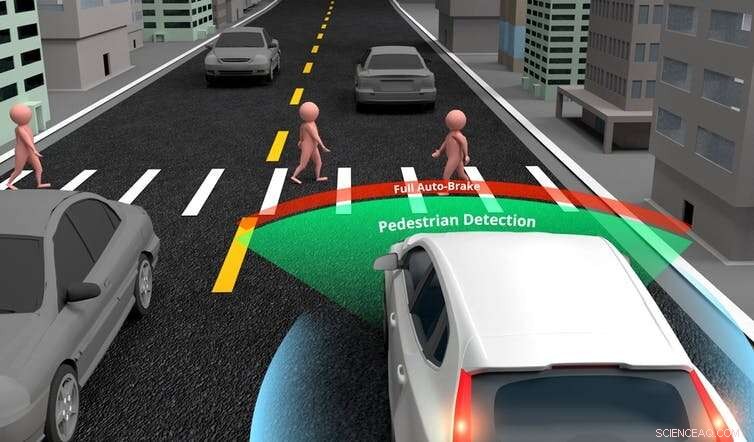

Le auto a guida autonoma sono addestrate a prendere decisioni su dove sterzare o quando frenare, utilizzando un'IA specifica (o debole) (intelligenza artificiale focalizzata sul completamento di un compito ristretto). Sono progettati con una gamma di sensori, telecamere e laser per la misurazione della distanza (lidar), che forniscono informazioni a un computer centrale. Il computer utilizza quindi l'intelligenza artificiale per analizzare questi input e prendere una decisione.

Sebbene la tecnologia sia attualmente relativamente semplice, le auto alla fine supereranno le prestazioni degli umani in questi compiti di guida di base. Però, non è realistico pensare che le auto a guida autonoma debbano anche essere in grado di prendere una decisione etica che anche il più morale degli esseri umani non avrebbe il tempo di prendere in caso di incidente. Un'auto dovrebbe essere programmata con l'IA generale se ci si aspetta che faccia questo.

L'intelligenza artificiale specifica consente alle auto a guida autonoma di esprimere giudizi di base sugli oggetti nei dintorni. Credito:Akarat Phasura/Shutterstock

L'IA generale è l'equivalente di ciò che ci rende umani. È la capacità di conversare, godersi la musica, trovare cose divertenti o esprimere giudizi morali. La produzione di IA generale è attualmente impossibile a causa della complessità del pensiero e delle emozioni umane. Se abbiamo bisogno di veicoli autonomi morali non ci arriveremo per diversi decenni, se mai.

Un altro problema con la nuova ricerca era che molte delle situazioni che ai partecipanti è stato chiesto di giudicare non erano realistiche. In uno scenario che fa eco al famoso "problema del carrello", ai partecipanti è stato chiesto chi avrebbe ucciso l'auto se i suoi freni si fossero rotti:i suoi tre passeggeri (un uomo adulto, una donna adulta e un ragazzo) o tre pedoni anziani (due uomini e una donna).

Le persone possono considerare attentamente questo tipo di problemi quando rispondono a un questionario. Ma nella maggior parte degli incidenti della vita reale, un pilota non avrebbe il tempo di esprimere tali giudizi nella frazione di secondo prima che accada. Ciò significa che il confronto non è valido. E data l'attuale tecnologia AI delle auto a guida autonoma, anche questi veicoli non saranno in grado di dare questi giudizi.

Le attuali auto a guida autonoma hanno sofisticate capacità di rilevamento e possono distinguere i pedoni da altri oggetti, come lampioni o segnali stradali. Però, gli autori della ricerca suggeriscono che le auto a guida autonoma possono, sarà e forse dovrebbe essere in grado di fare distinzioni più avanzate. Per esempio, potrebbero riconoscere le persone ritenute più desiderabili per la società, come medici o atleti, e scegli di salvarli in uno scenario di arresto anomalo.

La realtà è che progettare auto per esprimere giudizi così avanzati implicherebbe la produzione di IA generale, cosa attualmente impossibile. C'è anche la questione se questo sia anche desiderabile. Se è mai possibile programmare un'auto per decidere quale vita deve essere salvata, non è qualcosa che credo dovremmo permettere. Non dovremmo permettere che le preferenze identificate nella ricerca, per quanto grande sia la dimensione del campione, determinare il valore di una vita.

Nella loro forma più elementare, le auto a guida autonoma sono progettate per evitare incidenti se possono, e ridurre al minimo la velocità all'impatto se non possono. Sebbene, come gli umani, non sono in grado di prendere una decisione morale prima di un incidente inevitabile. Ma le auto a guida autonoma saranno più sicure dei conducenti umani, come sono più attenti, può reagire più rapidamente e utilizzerà al massimo le capacità del sistema di frenatura in caso di incidente.

Attualmente, la più grande sfida etica che i progettisti di auto a guida autonoma devono affrontare è determinare quando ci sono prove sufficienti di comportamento sicuro da simulazioni e test su strada controllati per introdurre le auto a guida autonoma sulla strada. Ma questo non significa che siano "morali", o sarà presto. Dire questo significa confondere l'IA specifica di svolgere compiti di guida con l'IA generale, che probabilmente non esisterà nella nostra vita.

In definitiva, le auto a guida autonoma saranno più sicure degli umani. Raggiungeranno questo obiettivo attraverso la progettazione ed evitando incidenti ove possibile, e ridurre i danni dove no. Però, le auto non saranno in grado di prendere decisioni morali che nemmeno noi potremmo. Questa nozione rimane una fantasia inverosimile, e non uno per cui dovremmo sperare. Anziché, concentriamoci sulla sicurezza:qualcosa in cui potremo avere una fiducia giustificata.

Questo articolo è stato ripubblicato da The Conversation con una licenza Creative Commons. Leggi l'articolo originale.