Il laboratorio dei ricercatori, come visto dal sensore di visione dinamica. Credito:Perception and Robotics Group, Università del Maryland.

José Altuve degli Houston Astros sale al piatto con un punteggio di 3-2, studia il lanciatore e la situazione, ottiene il via libera dalla terza base, segue il rilascio della palla, oscilla... e ottiene un singolo nel mezzo. Solo un altro viaggio al piatto per il tre volte campione in battuta dell'American League.

Un robot potrebbe essere colpito nella stessa situazione? Non probabile.

Altuve ha affinato riflessi naturali, Anni di esperienza, conoscenza delle tendenze del lanciatore, e una comprensione delle traiettorie dei vari tiri. quello che vede, sente, e sente che si combina perfettamente con il suo cervello e la memoria muscolare per cronometrare l'oscillazione che produce il colpo. Il robot, d'altra parte, ha bisogno di utilizzare un sistema di collegamento per coordinare lentamente i dati dai suoi sensori con le sue capacità motorie. E non ricorda niente. Batti tre!

Ma potrebbe esserci speranza per il robot. Un articolo dei ricercatori dell'Università del Maryland appena pubblicato sulla rivista Robotica scientifica introduce un nuovo modo di combinare percezione e comandi motori utilizzando la cosiddetta teoria del calcolo iperdimensionale, che potrebbe fondamentalmente alterare e migliorare il compito di base dell'intelligenza artificiale (AI) della rappresentazione sensomotoria:come agenti come i robot traducono ciò che sentono in ciò che fanno.

"Apprendimento del controllo sensomotorio con i sensori neuromorfici:verso la percezione attiva iperdimensionale" è stato scritto da Ph.D. studenti Anton Mitrokhin e Peter Sutor, Jr.; Cornelia Fermuller, un ricercatore associato con l'Università del Maryland Institute for Advanced Computer Studies; e il professore di informatica Yiannis Aloimonos. Mitrokhin e Sutor sono consigliati da Aloimonos.

L'integrazione è la sfida più importante per il settore della robotica. I sensori di un robot e gli attuatori che lo muovono sono sistemi separati, collegati tra loro da un meccanismo di apprendimento centrale che deduce un'azione necessaria dati i dati del sensore, o vice versa.

L'ingombrante sistema di intelligenza artificiale in tre parti, ciascuna parte che parla la propria lingua, è un modo lento per convincere i robot a svolgere compiti sensomotori. Il prossimo passo nella robotica sarà quello di integrare le percezioni di un robot con le sue capacità motorie. Questa fusione, noto come "percezione attiva, " fornirebbe un modo più efficiente e veloce per il robot di completare le attività.

Nella nuova teoria del calcolo degli autori, il sistema operativo di un robot sarebbe basato su vettori binari iperdimensionali (HBV), che esistono in uno spazio sparso ed estremamente alto dimensionale. Gli HBV possono rappresentare cose discrete disparate, ad esempio, una sola immagine, un concetto, un suono o un'istruzione; sequenze fatte di cose discrete; e raggruppamenti di cose e sequenze discrete. Possono spiegare tutti questi tipi di informazioni in modo costruito in modo significativo, legando ogni modalità insieme in lunghi vettori di 1 e 0 di uguale dimensione. In questo sistema, possibilità di azione, input sensoriali e altre informazioni occupano lo stesso spazio, sono nella stessa lingua, e sono fusi, creando una sorta di memoria per il robot.

Il Robotica scientifica carta segna la prima volta che percezione e azione sono state integrate.

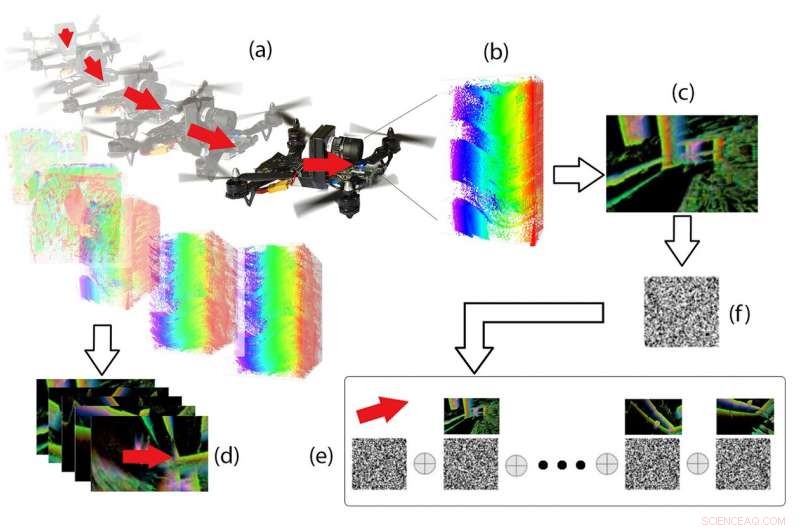

Pipeline iperdimensionale. Dai dati dell'evento (b) registrati sul DVS durante il volo del drone (a), vengono calcolate le "immagini degli eventi" (c) e i vettori di movimento 3D (d), ed entrambi sono codificati come vettori binari e combinati in memoria tramite speciali operazioni vettoriali (e). Data una nuova immagine evento (f), il movimento 3D associato può essere richiamato dalla memoria. Credito:Perception and Robotics Group, Università del Maryland.

Un framework iperdimensionale può trasformare qualsiasi sequenza di "istanti" in nuovi HBV, e raggruppare gli HBV esistenti, tutto nella stessa lunghezza del vettore. Questo è un modo naturale per creare "ricordi" semanticamente significativi e informati. La codifica di sempre più informazioni porta a sua volta a vettori di "storia" e alla capacità di ricordare. I segnali diventano vettori, l'indicizzazione si traduce in memoria, e l'apprendimento avviene attraverso il clustering.

I ricordi del robot di ciò che ha percepito e fatto in passato potrebbero portarlo ad aspettarsi una percezione futura e influenzare le sue azioni future. Questa percezione attiva consentirebbe al robot di diventare più autonomo e più in grado di completare le attività.

"Un percettore attivo sa perché desidera percepire, poi sceglie cosa percepire, e determina come, quando e dove ottenere la percezione, " dice Aloimonos. "Seleziona e si fissa sulle scene, momenti nel tempo, ed episodi. Quindi allinea i suoi meccanismi, sensori, e altri componenti per agire su ciò che vuole vedere, e seleziona i punti di vista da cui catturare al meglio ciò che intende."

"La nostra struttura iperdimensionale può affrontare ciascuno di questi obiettivi".

Le applicazioni della ricerca del Maryland potrebbero estendersi ben oltre la robotica. L'obiettivo finale è essere in grado di fare l'IA stessa in un modo fondamentalmente diverso:dai concetti ai segnali al linguaggio. Il calcolo iperdimensionale potrebbe fornire un modello alternativo più veloce ed efficiente alla rete neurale iterativa e ai metodi di intelligenza artificiale di deep learning attualmente utilizzati nelle applicazioni informatiche come il data mining, riconoscimento visivo e traduzione di immagini in testo.

"I metodi di intelligenza artificiale basati sulla rete neurale sono grandi e lenti, perché non sono in grado di ricordare, " dice Mitrokhin. "Il nostro metodo di teoria iperdimensionale può creare ricordi, che richiederà molto meno calcolo, e dovrebbe rendere tali compiti molto più veloci ed efficienti."

Un migliore rilevamento del movimento è uno dei miglioramenti più importanti necessari per integrare il rilevamento di un robot con le sue azioni. L'utilizzo di un sensore di visione dinamico (DVS) invece delle telecamere convenzionali per questo compito è stato un componente chiave per testare la teoria del calcolo iperdimensionale.

Le fotocamere digitali e le tecniche di visione artificiale catturano scene basate su pixel e intensità in fotogrammi che esistono solo "nel momento". Non rappresentano bene il movimento perché il movimento è un'entità continua.

Un DVS funziona in modo diverso. Non "scatta foto" nel senso comune, ma mostra una diversa costruzione della realtà che si adatta agli scopi dei robot che devono affrontare il movimento. Cattura l'idea di vedere il movimento, in particolare i bordi degli oggetti mentre si muovono. Conosciuto anche come "retina siliconica, " questo sensore ispirato alla visione dei mammiferi registra in modo asincrono i cambiamenti di illuminazione che si verificano in ogni pixel DVS. Il sensore si adatta a un'ampia gamma di condizioni di illuminazione, dal buio al chiaro, e può risolvere movimenti molto veloci a bassa latenza:proprietà ideali per applicazioni in tempo reale nella robotica, come la navigazione autonoma. I dati che accumula sono molto più adatti all'ambiente integrato della teoria del calcolo iperdimensionale.

Un DVS registra un flusso continuo di eventi, dove viene generato un evento quando un singolo pixel rileva una certa variazione predefinita nel logaritmo dell'intensità della luce. Ciò è ottenuto da circuiti analogici integrati su ciascun pixel, e ogni evento viene segnalato con la sua posizione in pixel e il timestamp di precisione al microsecondo.

"I dati di questo sensore, le nuvole dell'evento, sono molto più scarne delle sequenze di immagini, "dice Cornelia Fermüller, uno degli autori dell'articolo Science Robotics. "Per di più, le nuvole di eventi contengono le informazioni essenziali per codificare lo spazio e il movimento, concettualmente i contorni della scena e il loro movimento."

Le sezioni delle nuvole di eventi sono codificate come vettori binari. Questo rende il DVS un buon strumento per implementare la teoria del calcolo iperdimensionale per fondere la percezione con le capacità motorie.

Un DVS vede eventi sparsi nel tempo, fornendo informazioni dense sui cambiamenti in una scena, e consentendo un accurato, percezione rapida e sparsa degli aspetti dinamici del mondo. È un sensore differenziale asincrono in cui ogni pixel agisce come un circuito completamente indipendente che tiene traccia dei cambiamenti di intensità della luce. Quando rilevare il movimento è davvero il tipo di visione necessaria, il DVS è lo strumento preferito.