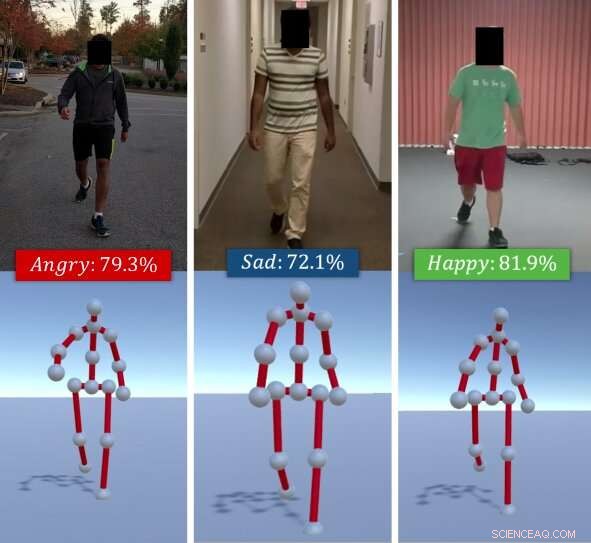

L'algoritmo identifica le emozioni percepite degli individui in base ai loro stili di camminata. Dato un video RGB di un individuo che cammina (in alto), il metodo dei ricercatori estrae la sua andatura come una serie di pose 3D (in basso). Quindi utilizza una combinazione di caratteristiche profonde apprese tramite un LSTM e caratteristiche affettive calcolate utilizzando segnali di postura e movimento e le classifica in emozioni di base (ad es. Felice, triste, eccetera.), utilizzando un classificatore forestale casuale. Credito:Randhavane et al.

Un team di ricercatori dell'Università della Carolina del Nord a Chapel Hill e dell'Università del Maryland a College Park ha recentemente sviluppato un nuovo modello di apprendimento profondo in grado di identificare le emozioni delle persone in base ai loro stili di deambulazione. Il loro approccio, delineato in un documento pre-pubblicato su arXiv, funziona estraendo l'andatura di un individuo da un video RGB di lui/lei camminare, poi analizzandolo e classificandolo come una delle quattro emozioni:felice, triste, arrabbiato o neutrale.

"Le emozioni giocano un ruolo significativo nella nostra vita, definire le nostre esperienze, e plasmare il modo in cui vediamo il mondo e interagiamo con gli altri umani, "Tanmay Randhavane, uno dei ricercatori primari e uno studente laureato all'UNC, ha detto a TechXplore. "Percepire le emozioni delle altre persone ci aiuta a capire il loro comportamento e a decidere le nostre azioni nei loro confronti. Ad esempio, le persone comunicano in modo molto diverso con qualcuno che percepiscono come arrabbiato e ostile rispetto a quello che fanno con qualcuno che percepiscono come calmo e contento".

La maggior parte degli strumenti di riconoscimento e identificazione delle emozioni esistenti funziona analizzando le espressioni facciali o le registrazioni vocali. Però, studi precedenti suggeriscono che il linguaggio del corpo (ad es. postura, movimenti, ecc.) può anche dire molto su come si sente qualcuno. Ispirato da queste osservazioni, i ricercatori hanno deciso di sviluppare uno strumento in grado di identificare automaticamente l'emozione percepita degli individui in base al loro stile di camminata.

"Il vantaggio principale del nostro approccio al riconoscimento delle emozioni percepite è che combina due diverse tecniche, " Randhavane ha detto. "Oltre a utilizzare il deep learning, il nostro approccio sfrutta anche i risultati degli studi psicologici. Una combinazione di entrambe queste tecniche ci dà un vantaggio rispetto agli altri metodi".

L'approccio estrae prima l'andatura a piedi di una persona da un video RGB di loro camminare, rappresentandolo come una serie di pose 3-D. Successivamente, i ricercatori hanno utilizzato una rete neurale ricorrente di memoria a lungo termine (LSTM) e un classificatore di foresta casuale (RF) per analizzare queste pose e identificare l'emozione più importante provata dalla persona nel video, scegliendo tra la felicità, tristezza, rabbia o neutralità.

L'LSTM è inizialmente addestrato su una serie di caratteristiche profonde, ma questi sono successivamente combinati con le caratteristiche affettive calcolate dalle andature utilizzando segnali di postura e movimento. Tutte queste caratteristiche vengono infine classificate utilizzando il classificatore RF.

Randhavane e i suoi colleghi hanno effettuato una serie di test preliminari su un set di dati contenente video di persone che camminano e hanno scoperto che il loro modello poteva identificare le emozioni percepite degli individui con una precisione dell'80%. Inoltre, il loro approccio ha portato a un miglioramento di circa il 14% rispetto ad altri metodi di riconoscimento delle emozioni percepite che si concentrano sullo stile di camminata delle persone.

"Anche se non facciamo alcuna affermazione sulle reali emozioni che una persona sta vivendo, il nostro approccio può fornire una stima dell'emozione percepita di quello stile di camminata, "Aniket Bera, un professore di ricerca nel dipartimento di informatica, supervisione della ricerca, ha detto a TechXplore. "Ci sono molte applicazioni per questa ricerca, che vanno da una migliore percezione umana per robot e veicoli autonomi a una migliore sorveglianza fino alla creazione di esperienze più coinvolgenti nella realtà aumentata e virtuale".

Insieme a Tanmay Randhavane e Aniket Bera, il team di ricerca dietro questo studio include Dinesh Manocha e Uttaran Bhattacharya presso l'Università del Maryland a College Park, così come Kurt Gray e Kyra Kapsaskis del dipartimento di psicologia dell'Università della Carolina del Nord a Chapel Hill.

Per addestrare il loro modello di deep learning, i ricercatori hanno anche compilato un nuovo set di dati chiamato Emotion Walk (EWalk), che contiene video di individui che camminano in ambienti interni ed esterni etichettati con le emozioni percepite. Nel futuro, questo set di dati potrebbe essere utilizzato da altri team per sviluppare e addestrare nuovi strumenti di riconoscimento delle emozioni progettati per analizzare il movimento, postura, e/o andatura.

"La nostra ricerca è in una fase molto primitiva, " ha detto Bera. "Vogliamo esplorare diversi aspetti del linguaggio del corpo e guardare più segnali come le espressioni facciali, discorso, schemi vocali, eccetera., e utilizzare un approccio multimodale per combinare tutti questi segnali con le andature. Attualmente, assumiamo che il movimento della camminata sia naturale e non coinvolga alcun accessorio (ad es. valigia, cellulari, eccetera.). Come parte del lavoro futuro, vorremmo raccogliere più dati e addestrare meglio il nostro modello di deep learning. Cercheremo anche di estendere la nostra metodologia per considerare più attività come corsa, gesticolando, eccetera."

Secondo Bera, gli strumenti di riconoscimento delle emozioni percepite potrebbero presto aiutare a sviluppare robot con una navigazione più avanzata, pianificazione, e capacità di interazione. Inoltre, modelli come il loro potrebbero essere utilizzati per rilevare comportamenti anomali o schemi di camminata da video o filmati CCTV, ad esempio identificare le persone a rischio di suicidio e allertare le autorità o gli operatori sanitari. Il loro modello potrebbe essere applicato anche nel settore degli effetti visivi e dell'animazione, dove potrebbe assistere designer e animatori nella creazione di personaggi virtuali che esprimano efficacemente particolari emozioni.

© 2019 Scienza X Rete