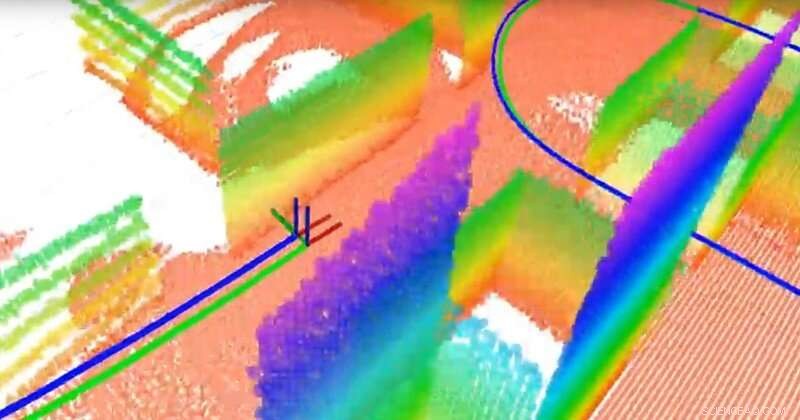

Il team ha costruito una mappa tridimensionale basata sul piano utilizzando un LiDAR 3-D e un sensore inerziale. LiDAR è come il radar ma utilizza la luce invece delle onde radio. I punti con colori diversi sono i diversi piani (che fungono da punti di riferimento per la navigazione), la linea verde è la vera traiettoria e la linea blu è la traiettoria stimata calcolata dall'algoritmo di localizzazione e mappatura simultanea (SLAM) del team. Credito:Università del Delaware

Scienziati di tutto il mondo stanno correndo per sviluppare veicoli a guida autonoma, ma alcuni componenti essenziali devono ancora essere perfezionati. Uno è la localizzazione:la capacità del veicolo di determinarne la posizione e il movimento. Un altro è la mappatura:la capacità dei veicoli di modellare l'ambiente circostante in modo da poter trasportare in sicurezza i passeggeri nel posto giusto.

La domanda è:come dare un senso di direzione a un veicolo? Mentre i dispositivi satellitari di posizionamento globale (GPS) possono aiutare, non sono disponibili o affidabili in tutti i contesti. Anziché, molti esperti stanno studiando la localizzazione e la mappatura simultanee, o SLAM, un problema notoriamente difficile nel campo della robotica. Nuovi algoritmi sviluppati da Guoquan (Paul) Huang, un assistente professore di ingegneria meccanica, ingegneria elettrica e informatica, e scienze informatiche e dell'informazione presso l'Università del Delaware, stanno avvicinando la risposta alla vista.

Huang utilizza sistemi di navigazione visuo-inerziali che combinano sensori inerziali, che contengono giroscopi per determinare l'orientamento e accelerometri per determinare l'accelerazione, insieme alle telecamere. Utilizzando i dati di questi relativamente poco costosi, componenti ampiamente disponibili, Huang misura e calcola il movimento e la localizzazione.

Per esempio, quando il suo team ha collegato il proprio sistema a un laptop e lo ha portato in giro per lo Spencer Laboratory di UD, sede del Dipartimento di Ingegneria Meccanica, hanno generato dati sufficienti per mappare l'edificio mentre seguivano il movimento del laptop stesso. In un veicolo autonomo, sensori e telecamere simili sarebbero collegati a un robot nel veicolo.

La capacità di un veicolo autonomo di tracciare il proprio movimento e il movimento degli oggetti intorno è fondamentale. "Dobbiamo localizzare il veicolo prima di poterlo controllare automaticamente, " ha detto Huang. "Il veicolo ha bisogno di conoscere la sua posizione per poter continuare."

Poi c'è il problema della sicurezza. "In uno scenario urbano, Per esempio, ci sono pedoni e altri veicoli, quindi idealmente il veicolo dovrebbe essere in grado di seguire il proprio movimento così come il movimento degli oggetti in movimento nei suoi dintorni, " disse Huang.

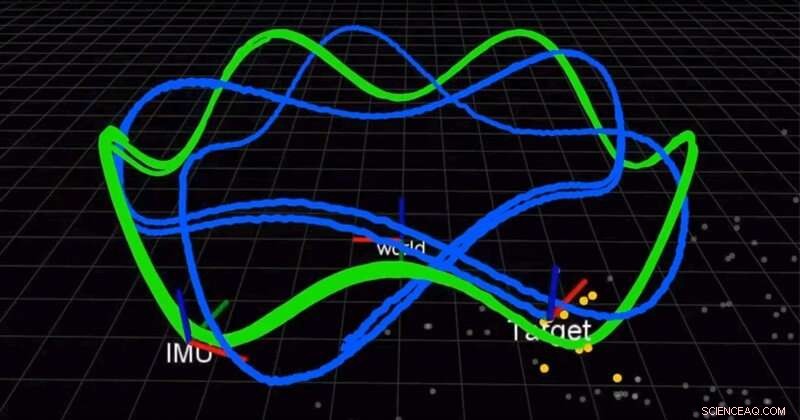

Il team utilizza una telecamera e un'unità di misurazione inerziale (IMU) per localizzare contemporaneamente un robot e tracciare un bersaglio in movimento. La linea verde è la traiettoria del robot e la linea blu è la traiettoria del bersaglio. Credito:Università del Delaware

In un articolo pubblicato all'inizio di quest'anno nel Rivista internazionale di ricerca sulla robotica (IJRR), Huang e il suo team hanno trovato una soluzione migliore, soluzione più accurata per combinare le misure inerziali. Fino ad ora, gli scienziati hanno utilizzato l'integrazione discreta, una tecnica di calcolo che approssima l'area sotto una curva, approssimare la soluzione. Anziché, Il gruppo di Huang ha trovato una soluzione e ha dimostrato che era migliore dei metodi esistenti. Anche meglio, stanno condividendo la loro soluzione.

"Apriamo il nostro codice. È su GitHub, " ha detto Huang. "Molte persone hanno usato il nostro codice per i loro sistemi." In un altro recente documento IJRR, Huang e il suo team hanno riformulato il problema SLAM come una formula che calcola piccoli incrementi di movimento da parte dei robot dotati di sensori visivi e inerziali. Molti di questi video di ricerca possono essere trovati sul canale YouTube Lab di Huang.

Queste scoperte potrebbero avere applicazioni oltre i veicoli autonomi, dalle auto ai droni aerei alle navi sottomarine e altro ancora. Gli algoritmi di Huang potrebbero essere utilizzati anche per sviluppare applicazioni di realtà aumentata e realtà virtuale per dispositivi mobili come smartphone, che hanno già a bordo telecamere e sensori inerziali.

"Questi sensori sono molto comuni, quindi la maggior parte dei dispositivi mobili, smartphone, anche i droni e i veicoli hanno questi sensori, " ha detto Huang. "Cerchiamo di sfruttare i sensori economici esistenti e fornire una soluzione di localizzazione, una soluzione di rilevamento del movimento."

Nel 2018 e di nuovo nel 2019, Huang ha ricevuto un Google Daydream (AR/VR) Faculty Research Award per supportare questo lavoro.

"La gente vede che i robot saranno la prossima grande cosa nella vita reale, ecco perché l'industria guida molto questo campo di ricerca, " disse Huang.