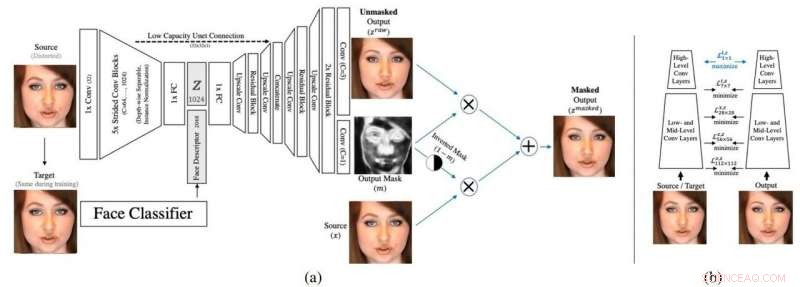

(a) L'architettura della rete. Per il condizionamento, viene utilizzata una rete di riconoscimento facciale pre-addestrata. (b) Un'illustrazione della perdita percettiva multi-immagine utilizzata, che impiega due repliche della stessa rete di riconoscimento facciale. Credito:de-identificazione del volto dal vivo in video, Oran Gafni et al.

Facebook ha scoperto la de-identificazione delle persone nei video. Aspettare, Facebook? Le piattaforme social non vengono spesso criticate per i diritti alla privacy? Non questa volta, almeno non oltre nelle sale di Facebook AI Research.

Orano Gafni, un membro del team che ha lavorato alla protezione dei volti dai sistemi di riconoscimento, ha pubblicato un video, "Esempi di video di de-identificazione" il 15 ottobre. Gafni, un ingegnere di ricerca in Facebook AI Research, ha conseguito una laurea in ingegneria elettrica presso l'Università di Tel-Aviv, sotto la supervisione del Prof. Lior Wolf. La tesi di Gafni si è concentrata sull'editing semantico del volto in video, utilizzando autoencoder avversari profondi.

Il loro articolo che discute il loro lavoro è intitolato "Live Face De-Identification in Video". Gli autori sono Gafni e Lior Wolf, con affiliazioni dichiarate di Facebook AI Research e Tel-Aviv University, e Yaniv Tagman, Ricerca sull'intelligenza artificiale di Facebook.

Khari Johnson in VentureBeat capito perché la ricerca è importante. "Startup come D-ID e una serie di lavori precedenti hanno realizzato la tecnologia di anonimizzazione per le immagini fisse, ma questo è il primo che funziona in video."

Il know-how di Facebook è nel regno della ricerca. Nello specifico, questa è Facebook AI Research, e il gruppo non ha piani, un portavoce ha detto VentureBeat , "applicare la tecnologia a qualsiasi parte della famiglia di app di Facebook in questo momento".

Facebook, anche se, potrebbero trarre vantaggio dai tentativi di difendere l'anonimato.

Johnson ha notato la recente controversia sulle applicazioni della tecnologia di riconoscimento facciale. Facebook affronta una minaccia da 35 miliardi di dollari di un'azione legale collettiva, come riportato da siti di notizie tra cui TechCrunch .

Come funziona:l'intelligenza artificiale riguarda la modifica automatica dei video. Il metodo mappa una versione leggermente distorta sul viso di una persona in modo tale che diventa difficile per la tecnologia di riconoscimento facciale identificare una persona.

Johnson ha affermato che il loro metodo "accoppia un autoencoder contraddittorio con una rete di classificatori".

Johnson ha continuato descrivendo chiaramente cosa sta succedendo:"L'intelligenza artificiale utilizza un'architettura di codifica-decodificatore per generare sia una maschera che un'immagine. Durante l'allenamento, il volto della persona viene distorto e poi immesso nella rete. Quindi il sistema genera immagini distorte e non distorte del volto di una persona per l'output che può essere incorporato nel video".

Quanto funziona? I ricercatori hanno cercato di ingannare le reti di riconoscimento facciale e sono emersi fiduciosi di aver trovato una tecnica significativa. "Il nostro contributo è l'unico adatto al video, compreso il video in diretta, e presenta una qualità che supera di gran lunga i metodi della letteratura. L'approccio è allo stesso tempo elegante e marcatamente nuovo, impiegando un descrittore di volti esistente concatenato allo spazio di incorporamento, una maschera appresa per mischiare, un nuovo tipo di perdita percettiva per ottenere l'effetto desiderato, tra pochi altri contributi."

Guarda le cifre sul giornale, che sono esempi dei cambiamenti di identità del loro metodo. Gli autori hanno sottolineato che solo una minima modifica dell'immagine è importante affinché il metodo sia compatibile con il video. Hanno detto che nel loro lavoro, il cambiamento viene misurato utilizzando funzionalità di basso e medio livello e non utilizzando norme sui pixel stessi.

Erano a conoscenza di ricerche che avevano mostrato che le perturbazioni dell'immagine causate da esempi contraddittori distorcono le caratteristiche di medio livello "che costringiamo a rimanere invariate".

In un'intervista a VentureBeat , Wolf ha affermato che "l'autoencoder è tale che cerca di rendere la vita più difficile alla rete di riconoscimento facciale, ed è in realtà una tecnica generale che può essere utilizzata anche se si desidera generare un modo per mascherare quello di qualcuno, dire, voce o comportamento online o qualsiasi altro tipo di informazione identificabile."

La Conferenza Internazionale sulla Computer Vision (ICCV) a Seoul, Corea del Sud, è un luogo in cui i ricercatori di Facebook sono stati elencati per unirsi agli esperti di visione artificiale di tutto il mondo per discutere degli ultimi progressi. Il programma di Seoul è stato segnalato per avere la presentazione della squadra alla spina, "De-identificazione dei volti in tempo reale in video".

L'abstract del loro articolo recita:"Proponiamo un metodo per la de-identificazione del volto che consente la modifica video completamente automatica a frame rate elevati. L'obiettivo è quello di de-correlare al massimo l'identità pur avendo la percezione (posa, illuminazione, ed espressione) fisso. Raggiungiamo questo obiettivo grazie a una nuova architettura di rete di codifica-decodificatore feed-forward che è condizionata dalla rappresentazione di alto livello dell'immagine del viso di una persona. La rete è globale, nel senso che non ha bisogno di essere riqualificato per un dato video o per una data identità, e crea sequenze di immagini dall'aspetto naturale con poca distorsione nel tempo."

Tyler Lee in Ubergizmo riconosciuto all'occhio umano qualsiasi differenza tra le foto prima e dopo potrebbe essere sconcertante, ma i cambiamenti sono stati sufficienti per confondere il sistema. Lee ha detto "sembra una sorta di deepfake inverso in cui distorce leggermente il viso della persona al punto da confondere i sistemi di riconoscimento facciale, ma allo stesso tempo mantieni abbastanza dell'originale in modo che tu, come un essere umano, saprà sicuramente chi è che stai vedendo."

© 2019 Scienza X Rete