Brendan Bena presenta il suo lavoro a una conferenza. Credito:UC Colorado Springs.

Negli ultimi decenni, i ricercatori hanno sviluppato strumenti di intelligenza artificiale (AI) sempre più avanzati e tecniche computazionali che possono essere applicate in una varietà di contesti. Tra questi, le tecniche che possono generare il linguaggio scritto o parlato hanno attirato una notevole attenzione, in particolare con l'introduzione di nuovi assistenti vocali, robot e nuovi dispositivi interattivi.

I ricercatori dell'Università del Colorado (UC)- Colorado Springs e la Drury University hanno recentemente sviluppato un sistema di generazione del linguaggio unico in grado di produrre versi poetici creativi. Il loro sistema, presentato in un articolo pre-pubblicato su arXiv, è un adattamento fine di GPT-2, un modello linguistico pre-addestrato sviluppato da OpenAI.

Jugal Kalita, il professore alla UC Colorado Springs che supervisiona il recente studio, ha condotto ricerche sulla generazione del linguaggio naturale negli ultimi 30 anni, a partire dai suoi giorni di laurea presso l'Università della Pennsylvania. Il suo primo articolo sulla generazione del linguaggio naturale, pubblicato nel 1988, aveva lo scopo di produrre paragrafi di testo che potrebbero apparire in un tipico diario, seguendo una serie di regole di base. Più recentemente, ispirato dai progressi nelle reti neurali artificiali per l'elaborazione del linguaggio naturale (PNL), Il Prof. Kalita e i suoi studenti hanno iniziato a sviluppare tecniche di deep learning per la generazione di brevi articoli, dialoghi e scrittura creativa.

"L'idea di approfondire il tema della generazione automatica della poesia è nata all'inizio dell'estate del 2019, quando Brendan Bena, uno stagista estivo di ricerca presso l'Università del Colorado, Colorado Springs, dalla Drury University del Missouri, ha mostrato interesse nella generazione automatica dei testi delle canzoni, "Il Prof. Kalita ha detto a TechXplore. "Inizialmente voleva cercare di creare un sistema che tentasse di imitare le emozioni suscitate attraverso i testi delle canzoni".

Poiché la maggior parte dei testi delle canzoni è protetta da copyright, trovare grandi set di dati per addestrare modelli di deep learning sulla generazione di testi può essere molto impegnativo. Bena e il Prof. Kalita hanno quindi deciso di sviluppare invece uno strumento di deep learning per la generazione di poesie. Tuttavia, invece di concentrarsi su caratteristiche come la struttura o il ritmo della poesia, come la maggior parte degli studi precedenti sulla generazione di poesie, ne hanno esplorato gli aspetti più emotivi e creativi.

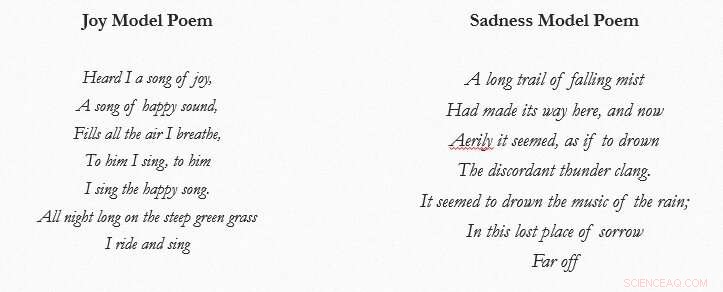

Esempi di poesia che evoca emozioni prodotte dal sistema di generazione del linguaggio dei ricercatori. Credito:Bena &Kalita.

"Dopo aver realizzato che c'era una porzione molto più ampia di ricerca, così come i dati, nel campo della generazione della poesia, abbiamo spostato la nostra attenzione su questo particolare argomento, " Bena ha detto a TechXplore. "Il lavoro è stato in gran parte basato sul compito generale di generazione del testo che è venuto con molte ricerche precedenti. Però, a differenza degli sforzi precedenti, volevamo concentrarci di più sul contenuto, emozione e creatività del testo, in contrasto con la struttura o il ritmo trovato nei precedenti studi sulla generazione della poesia."

Per sviluppare il loro sistema di generazione della poesia, Bena e il Prof. Kalita hanno prima raccolto un ampio corpus di testo dai database del Progetto Gutenberg e UC-Santa Cruz Dreambank. Hanno navigato nel database di Gutenberg alla ricerca di parole incluse in EmoLex, un set di dati sul lessico delle emozioni sviluppato dal National Research Council of Canada.

I ricercatori hanno quindi diviso il set di dati risultante in diverse "categorie di emozioni, " guardando il numero di parole EmoLex contenute in ogni estratto, e ha usato questi dati per addestrare una rete neurale profonda. Il modello che hanno addestrato è un adattamento di GPT-2, un'architettura che impara a generare nuovi frammenti di testo modellando lo stile del linguaggio utilizzato nei dati su cui viene addestrato.

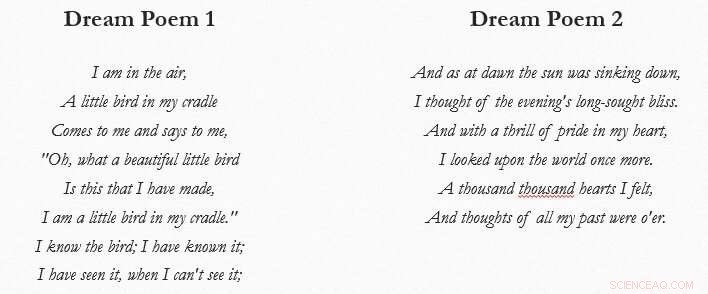

"Abbiamo anche alimentato la nostra rete neurale artificiale con una combinazione di dati onirici e poesia per creare quella che è nota come 'poesia onirica, '" ha spiegato Bena. "Alla fine, avevamo cinque modelli emotivi separati per le emozioni della gioia, tristezza, fiducia, rabbia e attesa, ma avevamo anche un modello di poesia onirica. Questo sistema, come detto in precedenza, si concentra meno sulla struttura che si trova in molti lavori di generazione della poesia e più su uno stile poetico a versi liberi che cerca di imitare e riprodurre la finezza e la creatività dei veri poeti."

I ricercatori hanno chiesto agli utenti umani di valutare le poesie create dal loro sistema, utilizzando anche lo strumento Coh-Metrix per valutare la qualità dei versi che ha generato. Hanno scoperto che ha prodotto poesie che hanno effettivamente suscitato tristezza e gioia l'87,5% e l'85% delle volte, rispettivamente. Inoltre, quando addestrato sia sui dati dei sogni che sulla poesia, il loro sistema ha generato versi poetici unici "da sogno" che hanno catturato elementi di quella che è conosciuta come "poesia onirica" con un punteggio di 3,2 sulla scala Likert.

Esempi di poesia onirica prodotta dal sistema di generazione del linguaggio dei ricercatori. Credito:Bena &Kalita.

"I nostri risultati suggeriscono che il testo può, infatti, essere generato in modo che susciti emozione nei lettori e che possa assomigliare ai tipi di creatività che gli artisti cercano di iniettare nel loro lavoro, " ha detto Bena. "Riteniamo che la nostra ricerca sia un nuovo lavoro nel campo della generazione di poesia creativa e speriamo che il nostro studio apra le porte a futuri lavori in questo settore".

Bena e il Prof. Kalita sono tra i primi a dimostrare i primi barlumi di creatività meccanica nella generazione della poesia. Nei loro studi successivi, i ricercatori intendono migliorare la qualità delle poesie composte dal loro sistema, applicando anche il loro approccio alla creazione di poesia in altre lingue.

"Se curiamo un po' di più i dati di allenamento, crediamo che un'architettura di rete neurale possa catturare meglio le emozioni e gli aspetti onirici della poesia che cerchiamo di creare, " disse Bena. "In effetti, mentre il dizionario EmoLex è un set di dati molto utile, il suo vocabolario non tiene conto di tutto l'inglese vecchio stile che si trova in alcune poesie di Gutenberg."

Nel futuro, i ricercatori sperano di replicare il loro esperimento concentrandosi su lessici a livello di frase o segmento, in quanto ciò potrebbe consentire loro di catturare le dipendenze nel testo basato sulle emozioni in modo più efficace. Il loro studio potrebbe anche essere ripetuto utilizzando un'architettura basata su reti neurali più sofisticate, che possono migliorare la qualità della poesia prodotta sia in termini di grammatica che di struttura della frase.

Poiché Bena e il prof. Kalita hanno già usato il loro sistema per produrre versi di poesia onirica, potrebbero eventualmente applicarlo anche ad altri stili creativi, come la poesia cancellatrice. La poesia di cancellazione è prodotta prendendo parole specifiche o casuali da un testo esistente e quindi usandole per formare nuovi versi.

"Finalmente, stiamo anche lavorando alla generazione di poesie in varie lingue utilizzando il transfer learning, " Ha detto il prof. Kalita. "Per esempio, Shaun Tucker, uno studente di Master presso UC-Colorado Springs ha generato poesie in diverse lingue indoeuropee utilizzando il modello GPT-2 pre-addestrato di OpenAI. Finora, abbiamo generato poesie in inglese, Spagnolo, Ucraino, Hindi, bengalese e assamese e hanno scoperto che il modello generativo di deep learning GPT-2, che è stato pre-addestrato con un ampio corpo di testo inglese, può essere addestrato con prosa e poesie in tutte queste lingue per generare poesia."

© 2020 Scienza X Rete