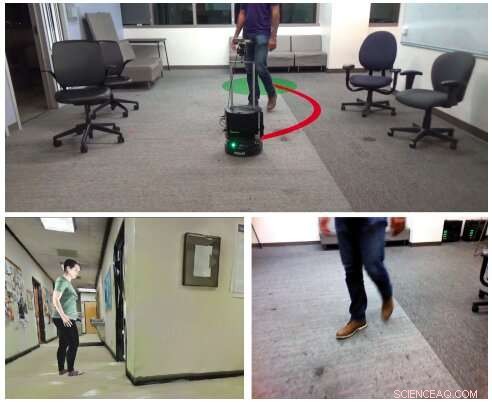

(In alto) Uno scenario di navigazione visiva autonomo considerato dai ricercatori, in un luogo sconosciuto, ambiente interno con l'uomo, utilizzando immagini RGB monoculare (in basso a destra). Per insegnare alle macchine come navigare in ambienti interni contenenti esseri umani, i ricercatori hanno creato HumANAv, un set di dati che consente il rendering fotorealistico in ambienti simulati (ad esempio in basso a sinistra). Credito:Tolani et al.

Al fine di affrontare i compiti che sono progettati per completare, i robot mobili dovrebbero essere in grado di navigare in modo efficiente negli ambienti del mondo reale, evitando persone o altri ostacoli nell'ambiente circostante. Sebbene gli oggetti statici siano in genere abbastanza facili da rilevare e aggirare per i robot, evitare gli umani può essere più impegnativo, in quanto implica prevedere i loro movimenti futuri e pianificare di conseguenza.

Ricercatori dell'Università della California, Berkeley, hanno recentemente sviluppato una nuova struttura che potrebbe migliorare la navigazione robotica tra gli esseri umani in ambienti interni come uffici, case o musei. Il loro modello, presentato in un articolo pre-pubblicato su arXiv, è stato addestrato su un set di dati appena compilato di immagini fotorealistiche chiamato HumANAv.

"Proponiamo un nuovo quadro per la navigazione intorno agli esseri umani che combina la percezione basata sull'apprendimento con il controllo ottimale basato sul modello, " hanno scritto i ricercatori nel loro articolo.

Il nuovo quadro sviluppato da questi ricercatori, soprannominato LB-WayPtNav-DH, ha tre componenti chiave:una percezione, una pianificazione, e un modulo di controllo. Il modulo di percezione si basa su una rete neurale convoluzionale (CNN) che è stata addestrata per mappare l'input visivo del robot in un waypoint (cioè, lo stato desiderato successivo) utilizzando l'apprendimento supervisionato.

Il waypoint mappato dalla CNN viene quindi inviato ai moduli di pianificazione e controllo del framework. Combinato, questi due moduli assicurano che il robot si sposti in sicurezza nella posizione di destinazione, evitando gli ostacoli e gli esseri umani nei suoi dintorni.

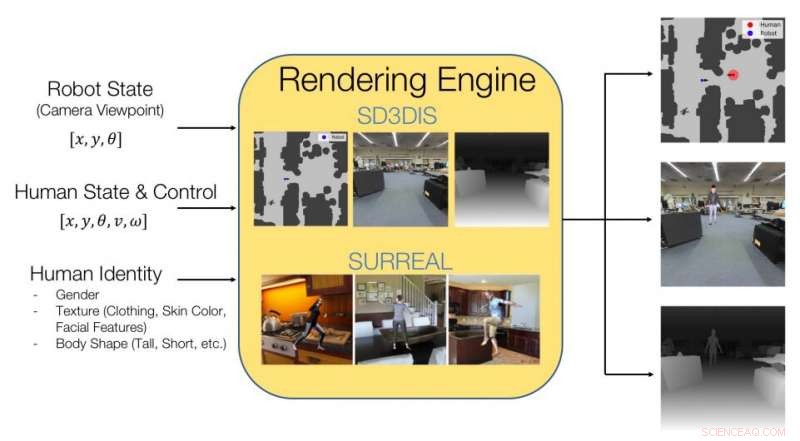

Immagine che spiega cosa contiene il set di dati HumANAv e come raggiunge il rendering fotorealistico di ambienti interni contenenti esseri umani. Credito:Tolani et al.

I ricercatori hanno addestrato la loro CNN sulle immagini incluse in un set di dati che hanno compilato, soprannominato HumANAv. HumANAv contiene fotorealistici, immagini renderizzate di ambienti di costruzione simulati in cui gli esseri umani si muovono, adattato da un altro set di dati chiamato SURREAL. Queste immagini ritraggono 6000 che camminano, maglie umane strutturate, organizzato per forma del corpo, genere e velocità.

"Il quadro proposto impara ad anticipare e reagire al movimento delle persone basandosi solo su un'immagine RGB monoculare, senza prevedere esplicitamente il futuro movimento umano, " hanno scritto i ricercatori nel loro articolo.

I ricercatori hanno valutato LB-WayPtNav-DH in una serie di esperimenti, sia nelle simulazioni che nel mondo reale. Negli esperimenti del mondo reale, l'hanno applicato a Turtlebot 2, un robot mobile a basso costo con software open source. I ricercatori riferiscono che la struttura di navigazione del robot si generalizza bene agli edifici invisibili, aggirare efficacemente gli esseri umani sia in ambienti simulati che reali.

"I nostri esperimenti dimostrano che la combinazione di controllo e apprendimento basati su modelli porta a comportamenti di navigazione migliori e più efficienti in termini di dati rispetto a un approccio basato esclusivamente sull'apprendimento, " hanno scritto i ricercatori nel loro articolo.

Il nuovo quadro potrebbe in definitiva essere applicato a una varietà di robot mobili, migliorando la loro navigazione in ambienti interni. Finora, il loro approccio ha dimostrato di funzionare notevolmente bene, trasferire le politiche sviluppate nella simulazione ad ambienti del mondo reale.

Nei loro studi futuri, i ricercatori hanno in programma di addestrare la loro struttura su immagini di ambienti più complessi o affollati. Inoltre, vorrebbero ampliare il set di dati di formazione che hanno compilato, compreso un insieme di immagini più diversificato.

© 2020 Scienza X Rete