(Da sinistra a destra) Kevin Yager, Masafumi Fukuto, e Ruipeng Li hanno preparato la linea di luce Complex Materials Scattering (CMS) presso NSLS-II per una misurazione utilizzando il nuovo algoritmo decisionale, che è stato sviluppato da Marcus Noack (non nella foto). Credito:Brookhaven National Laboratory

Un team di scienziati del Brookhaven National Laboratory del Dipartimento dell'Energia degli Stati Uniti e del Lawrence Berkeley National Laboratory ha progettato, creato, e testato con successo un nuovo algoritmo per prendere decisioni di misurazione scientifica più intelligenti. L'algoritmo, una forma di intelligenza artificiale (AI), può prendere decisioni autonome per definire ed eseguire il passaggio successivo di un esperimento. Il team ha descritto le capacità e la flessibilità del loro nuovo strumento di misurazione in un documento pubblicato il 14 agosto, 2019 in Rapporti scientifici .

Da Galileo e Newton alla recente scoperta delle onde gravitazionali, l'esecuzione di esperimenti scientifici per comprendere il mondo che ci circonda è stata la forza trainante del nostro progresso tecnologico per centinaia di anni. Migliorare il modo in cui i ricercatori eseguono i loro esperimenti può avere un enorme impatto sulla rapidità con cui tali esperimenti producono risultati applicabili per le nuove tecnologie.

Negli ultimi decenni, i ricercatori hanno accelerato i loro esperimenti attraverso l'automazione e un assortimento sempre crescente di strumenti di misurazione rapida. Però, alcune delle sfide scientifiche più interessanti e importanti, come la creazione di materiali per batterie migliorati per l'immagazzinamento dell'energia o nuovi materiali quantistici per nuovi tipi di computer, richiedono ancora esperimenti molto impegnativi e dispendiosi in termini di tempo.

Creando un nuovo algoritmo decisionale come parte di una configurazione sperimentale completamente automatizzata, il team interdisciplinare di due strutture per gli utenti del DOE Office of Science di Brookhaven:il Center for Functional Nanomaterials (CFN) e la National Synchrotron Light Source II (NSLS-II) e il Center for Advanced Mathematics for Energy Research Applications (CAMERA) del Berkeley Lab offrono la possibilità di studiare queste sfide in modo più efficiente.

La sfida della complessità

L'obiettivo di molti esperimenti è quello di acquisire conoscenze sul materiale studiato, e gli scienziati hanno un modo ben collaudato per farlo:prendono un campione del materiale e misurano come reagisce ai cambiamenti nel suo ambiente.

Un approccio standard per gli scienziati presso strutture utente come NSLS-II e CFN consiste nell'esaminare manualmente le misurazioni di un determinato esperimento per determinare l'area successiva in cui potrebbero voler eseguire un esperimento. Ma l'accesso agli strumenti di caratterizzazione dei materiali di fascia alta di queste strutture è limitato, quindi il tempo di misurazione è prezioso. Un team di ricerca potrebbe avere solo pochi giorni per misurare i propri materiali, quindi hanno bisogno di ottenere il massimo da ogni misurazione.

"La chiave per ottenere un numero minimo di misurazioni e la massima qualità del modello risultante è andare dove le incertezze sono grandi, " disse Marcus Noack, uno studioso post-dottorato presso CAMERA e autore principale dello studio. "L'esecuzione di misurazioni lì ridurrà in modo più efficace l'incertezza complessiva del modello".

Come Kevin Yager, un coautore e scienziato CFN, sottolineato, "L'obiettivo finale non è solo quello di prendere i dati più velocemente, ma anche di migliorare la qualità dei dati che raccogliamo. Penso che gli sperimentali passino dalla microgestione del loro esperimento alla gestione a un livello più alto. Invece di dover decidere dove misurare dopo sul campione, gli scienziati possono invece pensare al quadro generale, che è in definitiva ciò che noi scienziati stiamo cercando di fare".

"Questo nuovo approccio è un esempio applicato di intelligenza artificiale, " ha detto il co-autore Masafumi Fukuto, uno scienziato presso NSLS-II. "L'algoritmo decisionale sta sostituendo l'intuizione dello sperimentatore umano e può scansionare i dati e prendere decisioni intelligenti su come dovrebbe procedere l'esperimento".

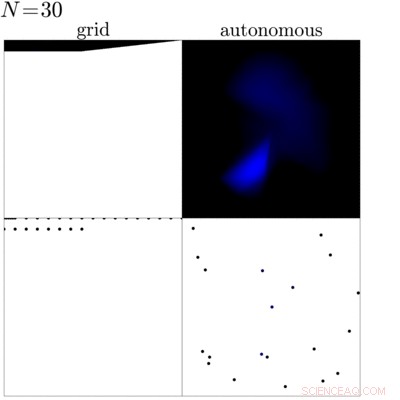

Questa animazione mostra un confronto tra una misurazione tradizionale della griglia (a sinistra) di un campione con una misurazione guidata dall'algoritmo decisionale di nuova concezione (a destra). Questo confronto mostra che l'algoritmo può identificare i bordi e la parte interna del campione e focalizza la misurazione in queste regioni per acquisire maggiori conoscenze sul campione. Credito:Brookhaven National Laboratory

Più informazioni per meno?

In pratica, prima di iniziare un esperimento, gli scienziati definiscono una serie di obiettivi che vogliono ottenere dalla misurazione. Con questi obiettivi fissati, l'algoritmo esamina i dati misurati in precedenza mentre l'esperimento è in corso per determinare la misurazione successiva. Alla ricerca della migliore misurazione successiva, l'algoritmo crea un modello surrogato dei dati, che è un'ipotesi plausibile su come si comporterà il materiale nei prossimi passaggi possibili, e calcola l'incertezza, in pratica quanto è sicuro della sua ipotesi, per ogni possibile passaggio successivo. Basato su questo, quindi seleziona l'opzione più incerta per la misurazione successiva. Il trucco qui è scegliere il passaggio più incerto da misurare dopo, l'algoritmo massimizza la quantità di conoscenza acquisita effettuando tale misurazione. L'algoritmo non solo massimizza il guadagno di informazioni durante la misurazione, definisce anche quando terminare l'esperimento individuando il momento in cui eventuali misurazioni aggiuntive non porterebbero a maggiori conoscenze.

"L'idea di base è dato un sacco di esperimenti, come puoi scegliere automaticamente il prossimo migliore?" disse James Sethian, direttore di CAMERA e coautore dello studio. "Marcus ha costruito un mondo che costruisce un modello surrogato approssimativo sulla base dei tuoi esperimenti precedenti e suggerisce l'esperimento migliore o più appropriato da provare dopo".

Come siamo arrivati qui?

Per realizzare esperimenti autonomi, il team ha dovuto affrontare tre pezzi importanti:l'automazione della raccolta dati, analisi in tempo reale, e, Certo, l'algoritmo decisionale.

"Questa è una parte entusiasmante di questa collaborazione, " ha detto Fukuto. "Tutti abbiamo fornito un pezzo essenziale per questo:il team CAMERA ha lavorato sull'algoritmo decisionale, Kevin di CFN ha sviluppato l'analisi dei dati in tempo reale, e noi di NSLS-II abbiamo fornito l'automazione per le misurazioni."

Il team ha prima implementato il proprio algoritmo decisionale presso la linea di luce Complex Materials Scattering (CMS) presso NSLS-II, cui CFN e NSLS-II operano in partnership. Questo strumento offre raggi X ultraluminosi per studiare la nanostruttura di vari materiali. In qualità di scienziato principale della linea di luce di questo strumento, Fukuto aveva già progettato la linea di luce pensando all'automazione. La linea di luce offre un robot per lo scambio di campioni, movimento automatico del campione in varie direzioni, e molti altri strumenti utili per garantire misurazioni veloci. Insieme all'analisi dei dati in tempo reale di Yager, la linea di luce era, in base alla progettazione, la soluzione perfetta per il primo esperimento "intelligente".

Il primo esperimento "intelligente"

Il primo esperimento completamente autonomo eseguito dal team è stato quello di mappare il perimetro di una gocciolina in cui le nanoparticelle si segregano utilizzando una tecnica chiamata diffusione di raggi X a piccolo angolo alla linea di luce del CMS. Durante la diffusione di raggi X a piccolo angolo, gli scienziati brillano raggi X luminosi sul campione e, a seconda della struttura da atomica a nanoscala del campione, i raggi X rimbalzano in direzioni diverse. Gli scienziati utilizzano quindi un grande rivelatore per catturare i raggi X diffusi e calcolare le proprietà del campione nel punto illuminato. In questo primo esperimento, gli scienziati hanno confrontato l'approccio standard di misurazione del campione con le misurazioni effettuate quando il nuovo algoritmo decisionale era al comando. L'algoritmo è stato in grado di identificare l'area della goccia e si è concentrato sui suoi bordi e parti interne invece che sullo sfondo.

"Dopo il nostro successo iniziale, volevamo applicare di più l'algoritmo, quindi abbiamo contattato alcuni utenti e proposto di testare il nostro nuovo algoritmo sui loro problemi scientifici, " disse Yager. "Hanno detto di sì, e da allora abbiamo misurato vari campioni. Uno dei più interessanti è stato uno studio su un campione fabbricato per contenere uno spettro di diversi tipi di materiale. Quindi, invece di creare e misurare un numero enorme di campioni e magari perdere una combinazione interessante, l'utente ha realizzato un unico campione che includeva tutte le possibili combinazioni. Il nostro algoritmo è stato quindi in grado di esplorare questa enorme diversità di combinazioni in modo efficiente, " Egli ha detto.

Qual è il prossimo?

Dopo i primi esperimenti di successo, gli scienziati intendono migliorare ulteriormente l'algoritmo e quindi il suo valore per la comunità scientifica. Una delle loro idee è rendere l'algoritmo "consapevole della fisica", sfruttando tutto ciò che è già noto sul materiale oggetto di studio, in modo che il metodo possa essere ancora più efficace. Un altro sviluppo in corso è quello di utilizzare l'algoritmo durante la sintesi e l'elaborazione di nuovi materiali, ad esempio per comprendere e ottimizzare i processi relativi alla produzione avanzata poiché questi materiali sono incorporati nei dispositivi del mondo reale. Il team sta anche pensando a un quadro più ampio e vuole trasferire il metodo autonomo ad altre configurazioni sperimentali.

"Penso che gli utenti vedano le linee di luce di NSLS-II o i microscopi di CFN come potenti strumenti di caratterizzazione. Stiamo cercando di trasformare queste capacità in una potente struttura di scoperta dei materiali, " disse Fukuto.