Credito:Università di Glasgow

Un metodo di imaging radicalmente nuovo che sfrutta l'intelligenza artificiale per trasformare il tempo in visioni dello spazio 3D potrebbe aiutare le automobili, i dispositivi mobili e i monitor sanitari sviluppano una consapevolezza a 360 gradi.

Le foto e i video vengono solitamente prodotti catturando i fotoni, gli elementi costitutivi della luce, con sensori digitali. Ad esempio, le fotocamere digitali sono costituite da milioni di pixel che formano immagini rilevando l'intensità e il colore della luce in ogni punto dello spazio. Le immagini 3D possono quindi essere generate posizionando due o più fotocamere attorno al soggetto per fotografarlo da più angolazioni, oppure utilizzando flussi di fotoni per scansionare la scena e ricostruirla in tre dimensioni. In entrambi i casi, un'immagine si costruisce solo raccogliendo informazioni spaziali sulla scena.

In un nuovo articolo pubblicato oggi sulla rivista ottica , ricercatori con sede nel Regno Unito, L'Italia e i Paesi Bassi descrivono un modo completamente nuovo di realizzare immagini animate in 3D:catturando informazioni temporali sui fotoni invece delle loro coordinate spaziali.

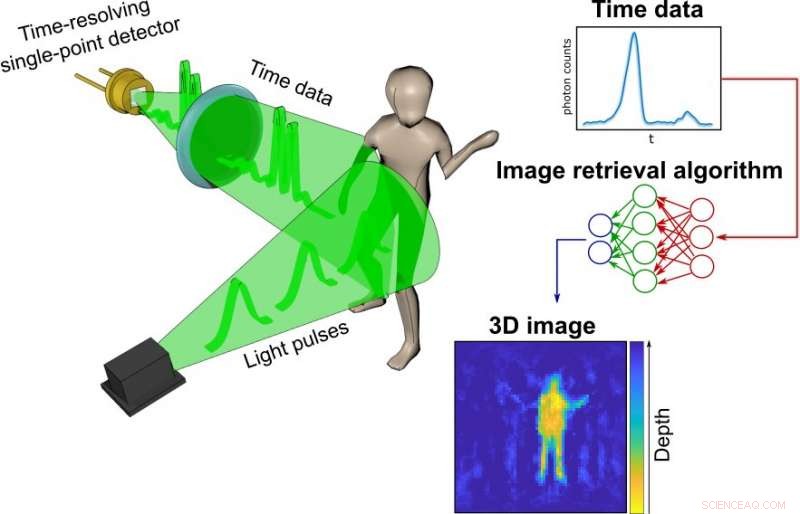

Il loro processo inizia con un semplice, rivelatore a punto singolo economico sintonizzato per agire come una sorta di cronometro per i fotoni. A differenza delle fotocamere, misurare la distribuzione spaziale del colore e dell'intensità, il rilevatore registra solo quanto tempo impiegano i fotoni prodotti da un impulso di luce laser di una frazione di secondo a rimbalzare su ogni oggetto in una determinata scena e raggiungere il sensore. Più un oggetto è lontano, più tempo impiegherà ciascun fotone riflesso per raggiungere il sensore.

Le informazioni sui tempi di ciascun fotone riflesso nella scena, ciò che i ricercatori chiamano dati temporali, sono raccolte in un grafico molto semplice.

Questi grafici vengono quindi trasformati in un'immagine 3D con l'aiuto di un sofisticato algoritmo di rete neurale. I ricercatori hanno addestrato l'algoritmo mostrandogli migliaia di foto convenzionali del team che si muoveva e trasportava oggetti in giro per il laboratorio, insieme ai dati temporali acquisiti contemporaneamente dal rilevatore a punto singolo.

Infine, la rete aveva imparato abbastanza su come i dati temporali corrispondessero alle foto da essere in grado di creare immagini altamente accurate dai soli dati temporali. Negli esperimenti di dimostrazione del principio, il team è riuscito a costruire immagini in movimento a circa 10 fotogrammi al secondo dai dati temporali, sebbene l'hardware e l'algoritmo utilizzati abbiano il potenziale per produrre migliaia di immagini al secondo.

Dott. Alex Turpin, Lord Kelvin Adam Smith Fellow in Data Science presso la School of Computing Science dell'Università di Glasgow, ha guidato il gruppo di ricerca dell'Ateneo insieme al Prof. Daniele Faccio, con il supporto dei colleghi del Politecnico di Milano e della Delft University of Technology.

Il Dr. Turpin ha dichiarato:"Le fotocamere dei nostri telefoni cellulari formano un'immagine utilizzando milioni di pixel. Creare immagini con un solo pixel è impossibile se consideriamo solo le informazioni spaziali, poiché un rilevatore a punto singolo non ne ha. Però, un tale rilevatore può comunque fornire preziose informazioni sul tempo. Quello che siamo riusciti a fare è trovare un nuovo modo per trasformare i dati unidimensionali, una semplice misurazione del tempo, in un'immagine in movimento che rappresenta le tre dimensioni dello spazio in una data scena. Il modo più importante che differisce dalla creazione di immagini convenzionale è che il nostro approccio è in grado di separare completamente la luce dal processo. Anche se gran parte dell'articolo discute di come abbiamo usato la luce laser pulsata per raccogliere i dati temporali dalle nostre scene, dimostra anche come siamo riusciti a utilizzare le onde radar per lo stesso scopo. Siamo fiduciosi che il metodo possa essere adattato a qualsiasi sistema in grado di sondare una scena con impulsi brevi e misurare con precisione l'eco di ritorno. Questo è davvero solo l'inizio di un modo completamente nuovo di visualizzare il mondo usando il tempo invece della luce".

Attualmente, la capacità della rete neurale di creare immagini è limitata a ciò che è stata addestrata a rilevare dai dati temporali delle scene create dai ricercatori. Però, con ulteriore formazione e anche utilizzando algoritmi più avanzati, potrebbe imparare a visualizzare una vasta gamma di scene, ampliando le sue potenziali applicazioni in situazioni del mondo reale.

Il Dr. Turpin ha aggiunto:"I rilevatori a punto singolo che raccolgono i dati temporali sono piccoli, leggero ed economico, il che significa che potrebbero essere facilmente aggiunti a sistemi esistenti come le telecamere nei veicoli autonomi per aumentare la precisione e la velocità del loro percorso. In alternativa, potrebbero aumentare i sensori esistenti nei dispositivi mobili come Google Pixel 4, che dispone già di un semplice sistema di riconoscimento dei gesti basato sulla tecnologia radar. Le generazioni future della nostra tecnologia potrebbero persino essere utilizzate per monitorare l'ascesa e la caduta del torace di un paziente in ospedale per avvisare il personale dei cambiamenti nella sua respirazione, o per tenere traccia dei loro movimenti per garantire la loro sicurezza in modo conforme ai dati. Siamo molto entusiasti del potenziale del sistema che abbiamo sviluppato, e non vediamo l'ora di continuare a esplorarne il potenziale. Il nostro prossimo passo è lavorare su un sistema autonomo, portatile system-in-a-box e siamo ansiosi di iniziare a esaminare le nostre opzioni per approfondire la nostra ricerca con il contributo di partner commerciali."

La carta della squadra, intitolato "Immagini spaziali da dati temporali, " è pubblicato in ottica .