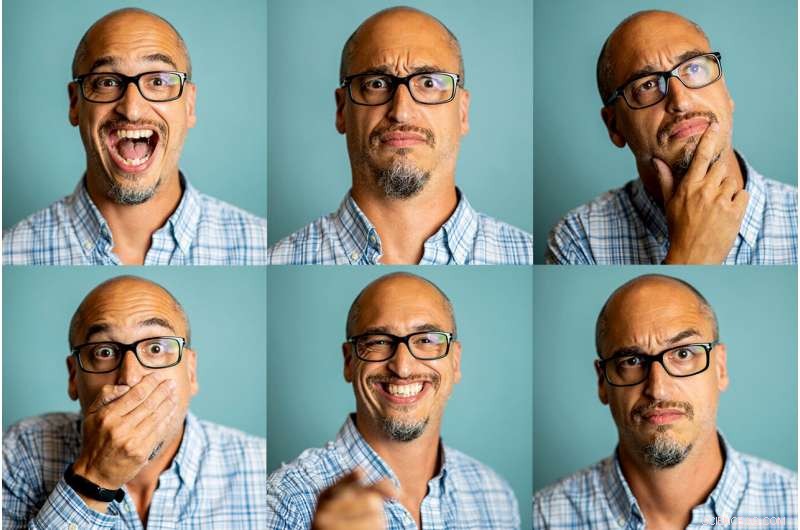

Una nuova ricerca dei neuroscienziati del nordest Lisa Feldman Barrett mostra che l'interpretazione dell'espressione facciale di una persona non può essere eseguita nel vuoto; Dipende dal contesto. Credito:Matthew Modoono/Northeastern University

Se vedessi una persona con la fronte corrugata, bocca abbassata, e gli occhi socchiusi, diresti che sono arrabbiati? E se scoprissi che hanno dimenticato gli occhiali da lettura e stavano decifrando il menu di un ristorante?

L'interpretazione dei movimenti facciali di una persona non può essere eseguita nel vuoto; dipende dal contesto, qualcosa che la neuroscienziata del nordest Lisa Feldman Barrett mostra in un nuovo studio rivoluzionario pubblicato giovedì sulla rivista scientifica Comunicazioni sulla natura .

Barretta, un illustre professore universitario di psicologia alla Northeastern, e colleghi di diverse altre istituzioni in tutto il mondo hanno utilizzato fotografie di attori professionisti che ritraggono scenari riccamente costruiti per dimostrare che le persone non solo usano movimenti facciali diversi per comunicare istanze diverse della stessa categoria di emozioni (qualcuno potrebbe accigliarsi, cipiglio, o anche ridere quando rappresentano la rabbia), impiegano anche configurazioni facciali simili per comunicare una serie di istanze da diverse categorie di emozioni (un cipiglio può talvolta esprimere concentrazione, per esempio) - risultati che hanno serie implicazioni per la tecnologia di riconoscimento delle emozioni che pretende di "leggere" le emozioni in faccia.

"L'implicazione di questo studio è che c'è molta più variabilità nel modo in cui le persone esprimono diverse istanze di una determinata categoria di emozioni. E una configurazione facciale può esprimere istanze di rabbia, felicità, o altre categorie di emozioni, a seconda del contesto, "dice Barretta.

Le persone potrebbero allargare gli occhi perché sono arrabbiate o perché sono sorprese, e il cervello umano dipende dal contesto per risolvere questo enigma.

Precedenti studi scientifici sulle espressioni delle emozioni si sono affidati a persone normali o attori dilettanti per ritrarre una singola istanza di ogni categoria di emozioni in un contesto impoverito:"Tuo cugino è appena morto e ti senti molto triste. Quale espressione faresti?"

Tali interpretazioni spingono le persone ad appoggiarsi su espressioni stereotipate di emozione (aggrottando la fronte nella tristezza), piuttosto che espressioni che riflettono una vita emotiva più ricca, pieno di sfumature e variazioni situate, dice Barret.

Quindi per il loro studio, Barrett e i suoi coautori hanno usato fotografie di attori professionisti, persone con "esperienza in materia di emozioni" perché i loro stessi mezzi di sussistenza dipendono "dalla loro rappresentazione autentica delle esperienze emotive nei film, televisione, e teatro, "in un modo che trasmetta informazioni credibili, scrivono i ricercatori.

Agli attori è stata data una dettagliata scenario che evoca emozioni da recitare, e poi fotografata da Howard Schatz (che ha anche creato gli scenari) per due volumi pubblicati:In Character:Actors Acting, e Caught in the Act:attori che recitano.

Un esempio dai libri di Schatz:"È un tipo motociclista che esce da un bar per motociclisti proprio come un ragazzo in una Porsche torna sulla sua scintillante Harley, "Secondo il documento dei ricercatori.

"L'importante è che a questi attori famosi sia stato dato uno scenario senza parole emotive, "Barret dice, che elimina la connessione immediata che si potrebbe stabilire tra, Per esempio, la parola "triste" e l'espressione facciale "cipiglio".

I ricercatori hanno utilizzato 604 delle 731 fotografie nei libri di Schatz, eliminando solo quelle in cui le pose facciali degli attori non potevano essere analizzate perché le loro mani coprivano il viso o perché le loro teste erano estremamente inclinate.

Hanno usato quelle foto e quegli scenari per eseguire due studi. Nel primo, i ricercatori hanno chiesto a 839 volontari di giudicare solo i significati emotivi delle descrizioni degli scenari. Ogni volontario ha valutato circa 30 scenari, utilizzando una scala 1-4 per indicare la misura in cui una delle 13 emozioni è stata evocata nella descrizione:divertimento, rabbia, soggezione, disprezzo, disgusto, imbarazzo, paura, felicità, interesse, orgoglio, tristezza, vergogna, e sorpresa.

Hanno usato la valutazione media di ogni scenario per classificarlo in una di quelle 13 categorie di emozioni. I ricercatori hanno anche chiamato tre esperti per codificare le 604 fotografie utilizzando il sistema di codifica dell'azione facciale, che specifica un insieme di unità di azione che rappresentano ciascuna il movimento di uno o più muscoli facciali.

Secondo un'ipotesi di vecchia data, certe categorie di emozioni sono espresse in modo coerente e specifico con determinati insiemi di movimenti facciali. Se così fosse, quindi tutte le descrizioni di scenari classificate come evocanti istanze di una data categoria di emozione dovrebbero corrispondere a fotografie che ritraggono coerentemente un insieme specifico di movimenti facciali.

O, come dice Barrett, "Se le configurazioni facciali in questione, accigliate, sorridente, accigliato, e così via:sono espressioni che si sono evolute per comunicare emozioni specifiche, dovresti vedere attori famosi che posano accigliati quando ritraggono istanze di rabbia e solo rabbia, posa accigliata quando ritrae tristezza, e così via."

I ricercatori hanno eseguito analisi di apprendimento automatico, che ha rivelato che gli attori hanno ritratto istanze delle stesse categorie di emozioni contorcendo i loro volti in una varietà di modi. Anche, pose facciali simili non esprimevano in modo affidabile la stessa categoria emotiva.

Per verificare se i movimenti facciali, solo, trasportare qualsiasi informazione emotiva indipendente dal contesto, i ricercatori hanno chiesto ad altri due gruppi di volontari di giudicare il significato emotivo di ogni posa facciale, se presentato da solo o con il suo scenario corrispondente.

Il primo gruppo, 842 persone, valutato circa 30 volti ciascuno. Il secondo gruppo, 845 persone, valutato circa 30 coppie faccia e scenario. A entrambi i gruppi è stato chiesto di giudicare fino a che punto i loro volti o le coppie volto-scenario appartenessero a ciascuna delle 13 categorie di emozioni.

Se i movimenti facciali trasportano informazioni emotive indipendenti dal contesto, quindi le valutazioni dei soli volti avrebbero dovuto essere molto simili alle valutazioni delle coppie volto-scenario. Se il significato emotivo dei movimenti facciali deriva principalmente dal contesto a cui sono associati, quindi le valutazioni iniziali degli scenari da sole sarebbero più simili alle valutazioni dello scenario facciale.

I ricercatori hanno scoperto che i giudizi delle persone sulle pose facciali da soli non corrispondevano in modo affidabile alle valutazioni dei volti quando venivano visti con lo scenario; inoltre non corrispondevano alla categoria di emozione designata dello scenario. I significati emotivi delle pose del viso provenivano principalmente dagli scenari a cui erano abbinati, cioè., il contesto.

"I risultati attuali si uniscono ad altri riassunti recenti delle prove empiriche per suggerire che si acciglia, sorrisi, e altre configurazioni facciali appartengono a un più ampio, repertorio più variabile dei modi significativi in cui le persone muovono i loro volti per esprimere emozioni, " scrivono i ricercatori.

In altre parole, Barret dice, "la gente deduce il significato del tuo sorriso, e le loro deduzioni sono informate dal contesto. Quando si tratta di esprimere emozioni, un volto non parla da solo."

I risultati dei ricercatori hanno implicazioni per i tipi di sistemi di intelligenza artificiale che alcuni ingegneri affermano di essere in grado di decifrare le emozioni di qualcuno tracciando solo i loro movimenti facciali.

Le aziende stanno già utilizzando sistemi basati sull'intelligenza artificiale per misurare le emozioni dei bambini mentre imparano, esprimere giudizi sui potenziali candidati al lavoro, e indovina le intenzioni nefaste di un passeggero aereo.

"La nostra ricerca contrasta direttamente il tradizionale approccio di intelligenza artificiale emotiva, " Dice Barrett. "Alcune aziende affermano di avere algoritmi in grado di rilevare la rabbia, Per esempio, quando ciò che realmente hanno, in circostanze ottimali, sono algoritmi che possono probabilmente rilevare lo sguardo accigliato, che può o non può essere un'espressione di rabbia. È importante non confondere la descrizione di una configurazione facciale con inferenze sul suo significato emotivo".