Video naturalistici e presentazione in risonanza magnetica. (A) Frame di esempio da video clip mostrati ai partecipanti. (B) Bhubo, un mix di Boxer di 4 anni, che guarda video mentre si sottopone a fMRI da sveglio. Credito:Journal of Visualized Experiments (2022). DOI:10.3791/64442

Gli scienziati hanno decodificato le immagini visive dal cervello di un cane, offrendo una prima occhiata a come la mente canina ricostruisce ciò che vede. Il Journal of Visualized Experiments ha pubblicato la ricerca svolta presso la Emory University.

I risultati suggeriscono che i cani sono più in sintonia con le azioni nel loro ambiente piuttosto che con chi o cosa sta facendo l'azione.

I ricercatori hanno registrato i dati neurali fMRI per due cani svegli e senza restrizioni mentre guardavano i video in tre sessioni di 30 minuti, per un totale di 90 minuti. Hanno quindi utilizzato un algoritmo di apprendimento automatico per analizzare i modelli nei dati neurali.

"Abbiamo dimostrato che possiamo monitorare l'attività nel cervello di un cane mentre sta guardando un video e, almeno in misura limitata, ricostruire ciò che sta guardando", afferma Gregory Berns, professore di psicologia di Emory e corrispondente autore dell'articolo . "Il fatto che siamo in grado di farlo è straordinario."

Il progetto è stato ispirato dai recenti progressi nell'apprendimento automatico e nella fMRI per decodificare gli stimoli visivi dal cervello umano, fornendo nuove informazioni sulla natura della percezione. Oltre agli esseri umani, la tecnica è stata applicata solo a una manciata di altre specie, inclusi alcuni primati.

"Sebbene il nostro lavoro si basi su due soli cani, offre la prova del concetto che questi metodi funzionano sui cani", afferma Erin Phillips, prima autrice dell'articolo, che ha svolto il lavoro come specialista di ricerca nel Canine Cognitive Neuroscience Lab di Berns. "Spero che questo documento aiuti ad aprire la strada ad altri ricercatori per applicare questi metodi sui cani, così come su altre specie, in modo da poter ottenere più dati e maggiori informazioni su come funzionano le menti di diversi animali".

Phillips, originario della Scozia, è arrivato a Emory come Bobby Jones Scholar, un programma di scambio tra Emory e l'Università di St Andrews. Attualmente è una studentessa laureata in ecologia e biologia evolutiva all'Università di Princeton.

Berns e colleghi hanno sperimentato le tecniche di addestramento per far entrare i cani in uno scanner fMRI e rimanere completamente immobili e sfrenati mentre viene misurata la loro attività neurale. Un decennio fa, il suo team ha pubblicato le prime immagini cerebrali fMRI di un cane completamente sveglio e sfrenato. Ciò ha aperto le porte a quello che Berns chiama The Dog Project, una serie di esperimenti che esplorano la mente delle specie domestiche più antiche.

Nel corso degli anni, il suo laboratorio ha pubblicato ricerche su come il cervello canino elabora visione, parole, odori e ricompense come ricevere lodi o cibo.

Nel frattempo, la tecnologia alla base degli algoritmi informatici di apprendimento automatico ha continuato a migliorare. La tecnologia ha consentito agli scienziati di decodificare alcuni modelli di attività del cervello umano. La tecnologia "legge le menti" rilevando all'interno di schemi di dati cerebrali i diversi oggetti o azioni che un individuo sta vedendo mentre guarda un video.

"Ho iniziato a chiedermi:'Possiamo applicare tecniche simili ai cani?'", ricorda Berns.

La prima sfida è stata trovare contenuti video che un cane potesse trovare abbastanza interessanti da guardare per un periodo prolungato. Il team di ricerca di Emory ha apposto un videoregistratore su un gimbal e su un selfie stick che ha permesso loro di riprendere filmati stabili dalla prospettiva di un cane, all'incirca all'altezza della vita rispetto a un essere umano o un po' più in basso.

Hanno usato il dispositivo per creare un video di mezz'ora di scene relative alla vita della maggior parte dei cani. Le attività includevano cani accarezzati dalle persone e ricevere dolcetti dalle persone. Le scene con i cani li hanno anche mostrati annusare, giocare, mangiare o camminare al guinzaglio. Le scene di attività mostravano automobili, biciclette o uno scooter che passavano su una strada; un gatto che cammina in una casa; un cervo che attraversa un sentiero; persone sedute; persone che si abbracciano o si baciano; persone che offrono un osso di gomma o una palla alla telecamera; e le persone che mangiano.

I dati video sono stati segmentati in base a timestamp in vari classificatori, inclusi classificatori basati su oggetti (come cane, auto, essere umano, gatto) e classificatori basati sull'azione (come annusare, giocare o mangiare).

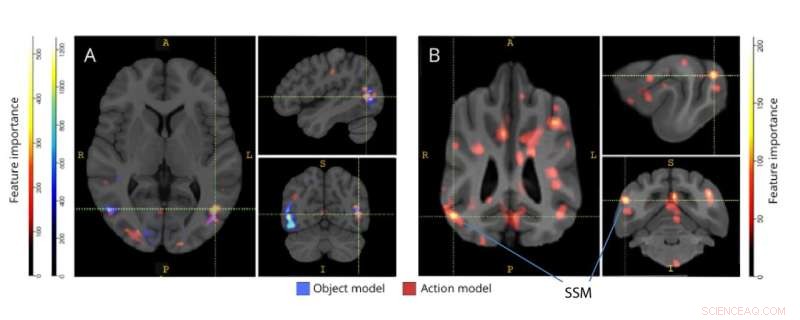

Regioni importanti per la discriminazione di modelli a oggetto a tre classi e a cinque classi di azione. (A) Partecipanti umani e (B) cani. I voxel sono stati classificati in base alla loro importanza delle caratteristiche utilizzando un classificatore forestale casuale, mediato in tutte le iterazioni dei modelli. Il 5% superiore dei voxel (cioè quelli utilizzati per addestrare i modelli) viene presentato qui, aggregato per specie e trasformato in spazio di gruppo per scopi di visualizzazione. Le etichette mostrano le regioni del cervello del cane con punteggi elevati di importanza delle caratteristiche, sulla base di quelle identificate da Johnson et al. Abbreviazione:SSM =il giro soprasilviano. Credito:Journal of Visualized Experiments (2022). DOI:10.3791/64442

Solo due dei cani che erano stati addestrati per esperimenti in una fMRI avevano la concentrazione e il temperamento per rimanere perfettamente immobili e guardare il video di 30 minuti senza interruzioni, comprese tre sessioni per un totale di 90 minuti. Questi due cani "super star" erano Daisy, una razza mista che potrebbe essere in parte Boston terrier, e Bhubo, una razza mista che potrebbe essere in parte boxer.

"Non avevano nemmeno bisogno di leccornie", dice Phillips, che ha monitorato gli animali durante le sessioni di fMRI e ha osservato i loro occhi che seguivano il video. "È stato divertente perché è una scienza seria, e ci sono voluti un sacco di tempo e sforzi, ma si trattava di questi cani che guardavano video di altri cani e umani che si comportavano in modo stupido".

Anche due esseri umani sono stati sottoposti allo stesso esperimento, guardando lo stesso video di 30 minuti in tre sessioni separate, mentre erano sdraiati in una fMRI.

I dati del cervello potrebbero essere mappati sui classificatori video utilizzando timestamp.

Ai dati è stato applicato un algoritmo di apprendimento automatico, una rete neurale nota come Ivis. Una rete neurale è un metodo per eseguire l'apprendimento automatico facendo in modo che un computer analizzi esempi di allenamento. In questo caso, la rete neurale è stata addestrata per classificare il contenuto dei dati cerebrali.

I risultati per i due soggetti umani hanno rilevato che il modello sviluppato utilizzando la rete neurale ha mostrato un'accuratezza del 99% nella mappatura dei dati cerebrali sia sui classificatori basati sugli oggetti che su quelli basati sull'azione.

Nel caso della decodifica del contenuto video dai cani, il modello non funzionava per i classificatori di oggetti. Tuttavia, è stato accurato dal 75% all'88% nel decodificare le classificazioni delle azioni per i cani.

I risultati suggeriscono grandi differenze nel modo in cui funzionano i cervelli di umani e cani.

"Noi esseri umani siamo molto orientati agli oggetti", afferma Berns. "Ci sono 10 volte più sostantivi quanti verbi nella lingua inglese perché abbiamo una particolare ossessione per la denominazione di oggetti. I cani sembrano essere meno interessati a chi o cosa stanno vedendo e più interessati all'azione stessa."

Anche i cani e gli esseri umani hanno grandi differenze nei loro sistemi visivi, osserva Berns. I cani vedono solo nei toni del blu e del giallo, ma hanno una densità leggermente superiore di recettori visivi progettati per rilevare il movimento.

"Ha perfettamente senso che il cervello dei cani sia molto in sintonia con le azioni prima di tutto", dice. "Gli animali devono essere molto interessati alle cose che accadono nel loro ambiente per evitare di essere mangiati o per monitorare gli animali che potrebbero voler cacciare. L'azione e il movimento sono fondamentali."

Per Philips, capire come i diversi animali percepiscono il mondo è importante per la sua attuale ricerca sul campo su come la reintroduzione dei predatori in Mozambico possa avere un impatto sugli ecosistemi. "Storicamente, non c'è stata molta sovrapposizione in informatica ed ecologia", dice. "Ma l'apprendimento automatico è un campo in crescita che sta iniziando a trovare applicazioni più ampie, anche in ecologia."

Altri autori dell'articolo includono Daniel Dilks, professore associato di psicologia di Emory, e Kirsten Gillette, che ha lavorato al progetto come specialista in neuroscienze e biologia comportamentale di Emory. Da allora Gilette si è laureata e ora frequenta un programma post-diploma presso l'Università della Carolina del Nord.

Daisy è di proprietà di Rebecca Beasley e Bhubo è di proprietà di Ashwin Sakhardande. + Esplora ulteriormente