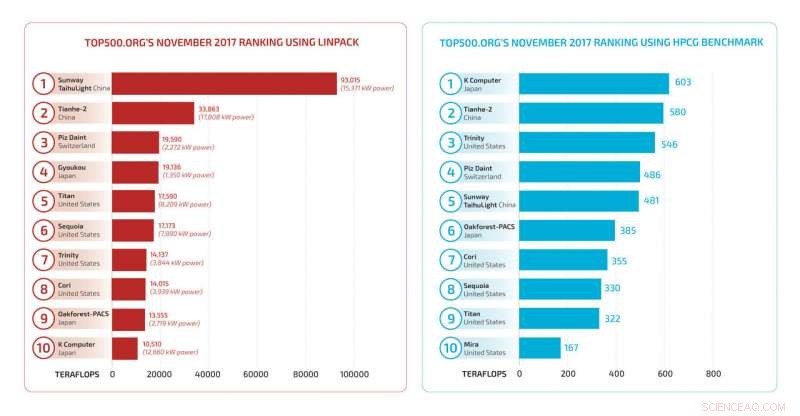

Grafici TOP500 LINPACK e HPCG dei supercomputer più veloci del 2017. L'ordine riorganizzato e la drastica riduzione della velocità stimata per i benchmark HPCG sono il risultato di un metodo diverso di test dei moderni programmi di supercomputer. Credito:Laboratori Nazionali Sandia

Un programma software dei Sandia National Laboratories ora installato come test aggiuntivo per la sfida dei supercomputer TOP500 ampiamente osservata è diventato sempre più importante. Il nome completo del programma:Gradienti coniugati ad alte prestazioni, o HPCG, non arriva alla lingua in modo tremolante, ma si sta diffondendo la voce che questo programma di benchmarking relativamente nuovo sta diventando prezioso quanto il suo venerabile partner, il programma LINPACK ad alte prestazioni, che secondo alcuni è diventato meno che soddisfacente nel misurare molte delle sfide computazionali odierne.

"Il programma LINPACK rappresentava un ampio spettro dei calcoli di base che dovevano essere eseguiti, ma le cose sono cambiate, ", ha affermato il ricercatore di Sandia Mike Heroux, che ha creato e sviluppato il programma HPCG. "Il programma LINPACK esegue algoritmi di elaborazione su strutture dati dense per identificare la velocità massima teorica di un supercomputer. Le applicazioni odierne spesso utilizzano strutture dati sparse, e i calcoli sono più snelli."

Il termine "sparso" significa che una matrice in esame ha per lo più valori zero. "Il mondo è davvero scarso di grandi dimensioni, " ha detto Heroux. "Pensa alle tue connessioni sui social media:potrebbero esserci milioni di persone rappresentate in una matrice, ma la tua fila, le persone che ti influenzano, sono poche. Così, la matrice effettiva è sparsa. Le altre persone sul pianeta ti influenzano ancora? Sì, ma attraverso persone a te vicine."

Allo stesso modo, per un problema scientifico la cui soluzione richiede miliardi di equazioni, la maggior parte dei coefficienti della matrice è zero. Per esempio, quando si misurano i differenziali di pressione in una mesh 3D, la pressione su ciascun nodo dipende direttamente dalle pressioni dei suoi vicini. La pressione in luoghi lontani è rappresentata attraverso i vicini vicini del nodo. "Il costo di memorizzazione di tutti i termini della matrice, come fa il programma LINPACK, diventa proibitivo, e il costo computazionale ancora di più, " disse Heroux. Un computer può essere molto veloce nell'elaborazione con matrici dense, e quindi ottenere un punteggio elevato nel test LINPACK, ma in termini pratici il test HPCG è più realistico.

Per riflettere meglio gli elementi pratici degli attuali programmi applicativi di supercalcolo, Heroux ha sviluppato il metodo iterativo precondizionato di HPCG per risolvere sistemi contenenti miliardi di equazioni lineari e miliardi di incognite. "Iterativo" significa che il programma inizia con un'ipotesi iniziale alla soluzione, e quindi calcola una sequenza di risposte migliorate. Il precondizionamento utilizza altre proprietà del problema per convergere rapidamente a una risposta accettabilmente vicina.

"Per risolvere i problemi di cui abbiamo bisogno per la nostra missione, che potrebbe variare da una simulazione completa di armi a un parco eolico, dobbiamo descrivere i fenomeni fisici ad alta fedeltà, come il differenziale di pressione di una simulazione di flusso di fluido, " ha detto Heroux. "Per una mesh in un dominio 3D, è necessario conoscere in ogni nodo della griglia le relazioni con i valori in tutti gli altri nodi. Un precondizionatore fa convergere più rapidamente il metodo iterativo, quindi un precondizionatore multigrid viene applicato al metodo ad ogni iterazione."

Fornitori di supercomputer come NVIDIA Corp., Fujitsu Ltd., IBM, Intel Corp. e le società cinesi scrivono versioni del programma HPCG ottimali per la loro piattaforma. Sebbene possa sembrare strano che gli studenti modifichino un test per adattarli a loro stessi, è chiaramente auspicabile che i supercomputer di vari design personalizzino il test, purché ogni concorrente tocchi tutte le basi di calcolo concordate.

"Abbiamo controlli nel codice per rilevare ottimizzazioni non consentite dalla politica di benchmark pubblicata, " disse Heroux.

Nella lista HPCG TOP500, il supercomputer Trinity di Sandia e Los Alamos National Laboratory è salito al n. 3, ed è il principale dipartimento del sistema energetico. Trinity è il numero 7 assoluto nella classifica LINPACK. HPCG riflette meglio le scelte progettuali Trinity.

Heroux dice di aver scritto il codice HPCG di base 15 anni fa, originariamente come codice didattico per studenti e colleghi che desideravano apprendere l'anatomia di un'applicazione che utilizza solutori sparsi scalabili. Jack Dongarra e Piotr Luszczek dell'Università del Tennessee sono stati collaboratori essenziali del progetto HPCG. In particolare, Dongarra, la cui visibilità nella comunità dei computer ad alte prestazioni non ha rivali, è stato un forte promotore di HPCG.

"I suoi contributi promozionali sono essenziali, " ha detto Heroux. "La gente rispetta la conoscenza di Jack e ha aiutato immensamente a diffondere la parola. Ma se il programma non fosse solido, la promozione da sola non basterebbe".

Heroux ha investito il suo tempo nello sviluppo dell'HPCG perché aveva un forte desiderio di assicurare meglio la sicurezza e l'efficacia delle scorte statunitensi. La comunità del supercalcolo aveva bisogno di un nuovo punto di riferimento che riflettesse meglio le esigenze della comunità dell'informatica scientifica per la sicurezza nazionale.

"Ho lavorato alla Cray Inc. per 10 anni prima di entrare in Sandia nel '98, " lui dice, "quando ho visto il lavoro algoritmico mi è importato di trasferirmi nei laboratori per l'Accelerated Strategic Computing Initiative (ASCI). Quando gli Stati Uniti hanno deciso di osservare il Trattato di divieto totale dei test nucleari, avevamo bisogno di computer di fascia alta per garantire meglio la sicurezza e l'efficacia delle scorte nucleari. Ho pensato che fosse una cosa nobile, che sarei felice di farne parte, e che la mia esperienza potrebbe essere applicata per sviluppare capacità di simulazione di prossima generazione. L'ASCI è stato il nuovo grande progetto alla fine degli anni '90 se volevo fare qualcosa di significativo nella mia area di ricerca e sviluppo".

Heroux è ora direttore della tecnologia software per l'Exascale Computing Project del Dipartimento dell'Energia. Là, lavora per armonizzare il lavoro informatico dei laboratori nazionali del DOE:Oak Ridge, Argonne, Lawrence Berkeley, Nordovest del Pacifico, Brookhaven e Fermi, insieme ai tre laboratori della National Nuclear Security Administration.

"Oggi, abbiamo l'opportunità di creare uno sforzo integrato tra i laboratori nazionali, " ha detto Heroux. "Ora abbiamo forum giornalieri a livello di progetto, e le persone con cui lavoro più da vicino sono persone di altri laboratori. Poiché il progetto Exascale Computing è integrato, dobbiamo fornire il software alle applicazioni e l'hardware a tutti i laboratori. Il tentativo del Dipartimento dell'Energia di un multi-laboratorio, progetto multiuniversitario fornisce una struttura organizzativa per consentirci di lavorare insieme come un'unità coesa in modo che il software venga fornito per adattarsi alle applicazioni chiave".