Credito:Google

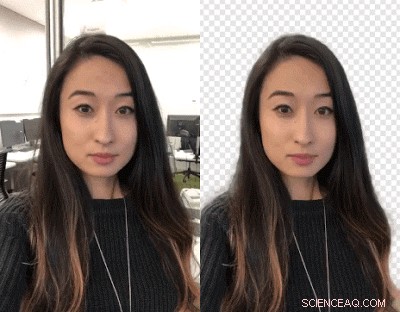

Creatori di video:vuoi scambiare gli sfondi? Buttatevi fuori. I ricercatori di Google hanno lavorato su un modo per consentire di scambiare gli sfondi dei video utilizzando una rete neurale, senza bisogno di uno schermo verde.

È disponibile su YouTube Stories su dispositivi mobili in modo limitato, disse TechCrunch .

Giovanni Anon, Titoli Android , ha affermato che i creatori di YouTube possono cambiare lo sfondo per creare video più coinvolgenti.

Valentin Bazarevsky e Andrei Tkachenka, ingegneri del software, Ricerca Google, fatto l'annuncio, intitolato "Segmentazione video in tempo reale per dispositivi mobili".

I creatori di contenuti video sanno che lo sfondo di una scena può essere separato dallo sfondo trattato come due livelli diversi. La manovra è fatta per raggiungere uno stato d'animo, oppure inserisci un luogo divertente o potenzia l'impatto del messaggio.

L'operazione, hanno detto i due sul sito di Google Research, è "un processo manuale che richiede tempo (ad esempio un artista che esegue il rotoscopio su ogni fotogramma) o richiede un ambiente di studio con uno schermo verde per la rimozione dello sfondo in tempo reale (una tecnica denominata chroma keying)."

Traduzione:Hillary Grigonis in Tendenze digitali disse, "La sostituzione dello sfondo di un video richiede in genere un software desktop avanzato e molto tempo libero, o uno studio a tutti gli effetti con uno schermo verde".

Ora i due hanno annunciato una nuova tecnica, e funzionerà sui telefoni cellulari.

La loro tecnica consentirà ai creatori di sostituire e modificare gli sfondi senza attrezzature specializzate.

Lo chiamavano il nuovo formato video leggero di YouTube, progettato specificamente per i creator di YouTube.

Hanno pubblicato un annuncio del 1 marzo di un "preciso, tempo reale, segmentazione di video per dispositivi mobili sul dispositivo nell'app YouTube integrando questa tecnologia nelle storie."

Come hanno fatto questo? Anon ha detto che "il punto cruciale di tutto è l'apprendimento automatico".

Bazarevsky e Tkachenka hanno affermato di aver sfruttato "l'apprendimento automatico per risolvere un compito di segmentazione semantica utilizzando reti neurali convoluzionali".

Traduzione:"Google sta sviluppando un'alternativa all'intelligenza artificiale che funziona in tempo reale, dalla fotocamera di uno smartphone, " ha scritto Grigoni.

I due ingegneri hanno descritto un'architettura e una procedura di formazione adatta ai telefoni cellulari. Hanno tenuto presente che "Una soluzione mobile dovrebbe essere leggera e funzionare almeno 10-30 volte più velocemente rispetto ai modelli di segmentazione fotografica all'avanguardia esistenti".

Per quanto riguarda un set di dati, hanno "annotato decine di migliaia di immagini". Questi hanno catturato un ampio spettro di pose in primo piano e impostazioni di sfondo.

"Con quel set di dati, il gruppo ha addestrato il programma a separare lo sfondo dal primo piano, " disse Grigoni.

Devin Coldewey in TechCrunch :"La rete ha imparato a cogliere i tratti comuni di un testa e spalle, e una serie di ottimizzazioni ha ridotto la quantità di dati necessari per elaborare per farlo."

Tendenze digitali spiegato come funziona:"Una volta che il software maschera lo sfondo della prima immagine, il programma utilizza la stessa maschera per prevedere lo sfondo nel fotogramma successivo. Quando il fotogramma successivo ha solo piccole modifiche rispetto al primo... il programma effettuerà piccole modifiche alla maschera. Quando il fotogramma successivo è molto diverso dall'ultimo... il software scarterà completamente la previsione della maschera e creerà una nuova maschera."

Un risultato finale del loro lavoro, come detto sul blog di Google Research, è che "la nostra rete funziona in modo straordinariamente veloce sui dispositivi mobili, raggiungimento di oltre 100 FPS su iPhone 7 e 40+ FPS su Pixel 2 con elevata precisione (realizzando il 94,8% IOU sul nostro set di dati di convalida), offrendo una varietà di effetti fluidi e reattivi nelle storie di YouTube."

Qual è il prossimo?

È in versione beta limitata. "Il nostro obiettivo immediato è utilizzare il lancio limitato nelle storie di YouTube per testare la nostra tecnologia su questa prima serie di effetti. Mentre miglioriamo ed espandiamo la nostra tecnologia di segmentazione a più etichette, abbiamo in programma di integrarlo nei più ampi servizi di realtà aumentata di Google."

© 2018 Tech Xplore