Pronto giocatore uno? Credito:Wikimedia

I giochi sono stati a lungo utilizzati come banchi di prova e benchmark per l'intelligenza artificiale, e negli ultimi mesi non sono mancati i risultati. AlphaGo di Google DeepMind e il bot di poker Libratus della Carnegie Mellon University hanno entrambi battuto esperti umani in giochi che sono stati tradizionalmente difficili per l'intelligenza artificiale, circa 20 anni dopo che DeepBlue di IBM ha raggiunto la stessa impresa negli scacchi.

Giochi come questi hanno il fascino di regole chiaramente definite; sono relativamente semplici ed economici per i ricercatori di intelligenza artificiale con cui lavorare, e forniscono una varietà di sfide cognitive a qualsiasi livello di difficoltà desiderato. Inventando algoritmi che li riproducano bene, i ricercatori sperano di ottenere informazioni sui meccanismi necessari per funzionare in modo autonomo.

Con l'arrivo delle ultime tecniche di intelligenza artificiale e machine learning, l'attenzione si sta ora spostando sui giochi per computer visivamente dettagliati, tra cui lo sparatutto 3-D Doom, vari giochi Atari 2-D come Pong e Space Invaders, e il gioco di strategia in tempo reale StarCraft.

Tutto questo è certamente progresso, ma una parte fondamentale del quadro più ampio dell'IA viene trascurata. La ricerca ha dato la priorità ai giochi in cui tutte le azioni che possono essere eseguite sono note in anticipo, che si tratti di spostare un cavaliere o di sparare con un'arma. Al computer vengono date tutte le opzioni fin dall'inizio e l'attenzione si concentra su quanto bene sceglie tra di loro. Il problema è che questo disconnette la ricerca sull'intelligenza artificiale dal compito di rendere i computer veramente autonomi.

bucce di banana

Far sì che i computer determinino quali azioni esistono in un dato contesto presenta sfide concettuali e pratiche che i ricercatori di giochi hanno a malapena tentato di risolvere finora. Il problema "scimmia e banane" è un esempio di un enigma dell'IA di lunga data in cui non sono stati compiuti progressi recenti.

Il problema è stato originariamente posto da John McCarthy, uno dei padri fondatori di AI, nel 1963:c'è una stanza che contiene una sedia, un bastone, una scimmia e un casco di banane appesi a un gancio da soffitto. Il compito è che un computer elabori una sequenza di azioni per consentire alla scimmia di acquisire le banane.

McCarthy ha fatto una distinzione chiave tra due aspetti di questo compito in termini di intelligenza artificiale. Fattibilità fisica:determinare se una particolare sequenza di azioni è realizzabile fisicamente; e fattibilità epistemica o legata alla conoscenza – determinare quali possibili azioni per la scimmia esistono effettivamente.

Determinare ciò che è fisicamente fattibile per la scimmia è molto facile per un computer se gli viene detto in anticipo tutte le possibili azioni - "salire sulla sedia", "bastone dell'onda" e così via. Un semplice programma che istruisce il computer a eseguire tutte le possibili sequenze di azioni una per una, arriverà rapidamente alla soluzione migliore.

Se il computer deve prima determinare quali azioni sono possibili, però, è una sfida molto più difficile. Solleva interrogativi su come rappresentiamo la conoscenza, le condizioni necessarie e sufficienti per conoscere qualcosa, e come sappiamo quando è stata acquisita una conoscenza sufficiente. Nell'evidenziare questi problemi, McCarthy ha dichiarato:"Il nostro obiettivo finale è realizzare programmi che apprendano dalla loro esperienza con la stessa efficacia degli umani".

Fino a quando i computer non saranno in grado di affrontare i problemi senza alcuna descrizione predeterminata delle possibili azioni, questo obiettivo non può essere raggiunto. È un peccato che i ricercatori di intelligenza artificiale lo stiano trascurando:non solo questi problemi sono più difficili e più interessanti, sembrano un prerequisito per compiere ulteriori progressi significativi nel campo.

Appello di testo

Per operare in autonomia in un ambiente complesso, è impossibile descrivere in anticipo il modo migliore per manipolare – o anche caratterizzare – gli oggetti lì. Insegnare ai computer per aggirare queste difficoltà porta immediatamente a profonde domande sull'apprendimento dall'esperienza precedente.

Piuttosto che concentrarsi su giochi come Doom o StarCraft, dove è possibile evitare questo problema, un test più promettente per l'IA moderna potrebbe essere l'umile avventura testuale degli anni '70 e '80.

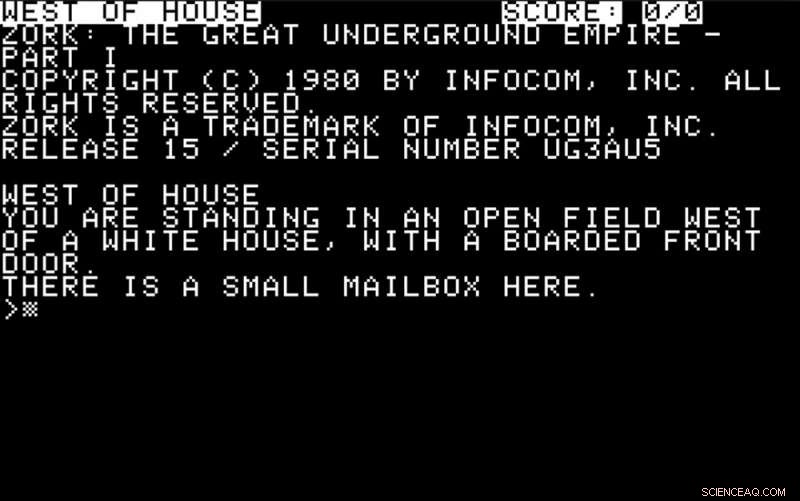

Nei giorni prima che i computer avessero capacità grafiche sofisticate, giochi come Colossal Cave e Zork erano popolari. Ai giocatori è stato detto del loro ambiente tramite messaggi sullo schermo:

Dovevano rispondere con semplici istruzioni, di solito sotto forma di verbo o verbo più un sostantivo - "guardare", "prendi la scatola" e così via. Parte della sfida era capire quali azioni erano possibili e utili e rispondere di conseguenza.

Una buona sfida per l'IA moderna sarebbe quella di assumere il ruolo di un giocatore in un'avventura del genere. Il computer dovrebbe dare un senso alle descrizioni testuali sullo schermo e rispondere ad esse con azioni, utilizzando un meccanismo predittivo per determinare il loro probabile effetto.

Comportamenti più sofisticati da parte del computer implicherebbero l'esplorazione dell'ambiente, definizione degli obiettivi, fare scelte di azione orientate agli obiettivi e risolvere le varie sfide intellettuali tipicamente richieste per progredire.

Come i moderni metodi di intelligenza artificiale del tipo promosso da giganti della tecnologia come IBM, Google, Facebook o Microsoft se la caverebbero in queste avventure testuali è una questione aperta, così come quanta conoscenza umana specialistica richiederebbero per ogni nuovo scenario.

Per misurare i progressi in questo settore, negli ultimi due anni abbiamo organizzato una competizione alla Conferenza IEEE su Computational Intelligence and Games, che quest'anno si svolge a Maastricht nei Paesi Bassi nel mese di agosto. I concorrenti inviano le iscrizioni in anticipo, e possono utilizzare la tecnologia AI di loro scelta per creare programmi in grado di riprodurre questi giochi dando un senso a una descrizione di testo e emettendo in cambio comandi di testo appropriati.

In breve, i ricercatori devono riconsiderare le loro priorità se l'IA vuole continuare a progredire. Se portare alla luce le radici trascurate della disciplina si rivela fruttuoso, la scimmia potrebbe finalmente ottenere le sue banane, dopotutto.

Questo articolo è stato originariamente pubblicato su The Conversation. Leggi l'articolo originale.