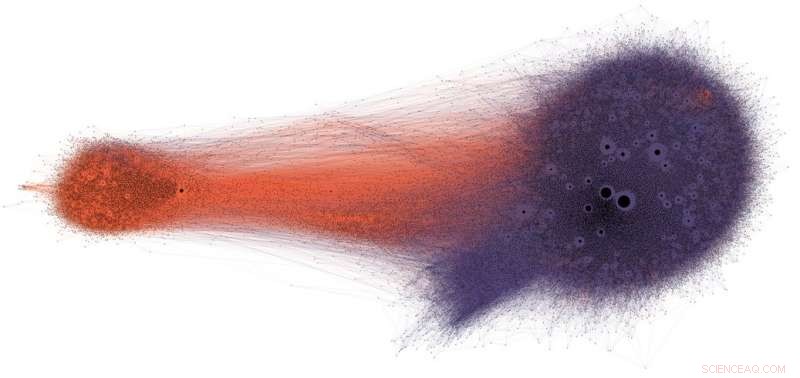

Le persone che condividono potenziali disinformazione su Twitter (in viola) raramente vedono correzioni o verifiche dei fatti (in arancione). Credito:Shao et al., CC BY-ND

I social media sono tra le principali fonti di notizie negli Stati Uniti e in tutto il mondo. Eppure gli utenti sono esposti a contenuti di dubbia accuratezza, comprese le teorie del complotto, clickbait, contenuto iperpartitico, pseudoscienza e persino falsi rapporti di "notizie false".

Non sorprende che venga pubblicata così tanta disinformazione:lo spam e le frodi online sono redditizie per i criminali, e il governo e la propaganda politica producono benefici sia di parte che finanziari. Ma il fatto che i contenuti a bassa credibilità si diffondano così rapidamente e facilmente suggerisce che le persone e gli algoritmi dietro le piattaforme dei social media sono vulnerabili alla manipolazione.

La nostra ricerca ha identificato tre tipi di pregiudizi che rendono l'ecosistema dei social media vulnerabile alla disinformazione sia intenzionale che accidentale. Ecco perché il nostro Osservatorio sui social media presso l'Università dell'Indiana sta costruendo strumenti per aiutare le persone a prendere coscienza di questi pregiudizi e proteggersi dalle influenze esterne progettate per sfruttarli.

Bias nel cervello

I pregiudizi cognitivi hanno origine nel modo in cui il cervello elabora le informazioni che ogni persona incontra ogni giorno. Il cervello può gestire solo una quantità finita di informazioni, e troppi stimoli in entrata possono causare un sovraccarico di informazioni. Questo di per sé ha gravi implicazioni per la qualità delle informazioni sui social media. Abbiamo scoperto che la forte concorrenza per l'attenzione limitata degli utenti significa che alcune idee diventano virali nonostante la loro bassa qualità, anche quando le persone preferiscono condividere contenuti di alta qualità.

Per evitare di essere sopraffatti, il cervello usa una serie di trucchi. Questi metodi sono generalmente efficaci, ma possono anche diventare pregiudizi se applicati nei contesti sbagliati.

Una scorciatoia cognitiva si verifica quando una persona decide se condividere una storia che appare sul proprio feed di social media. Le persone sono molto colpite dalle connotazioni emotive di un titolo, anche se non è un buon indicatore dell'accuratezza di un articolo. Molto più importante è chi ha scritto il pezzo.

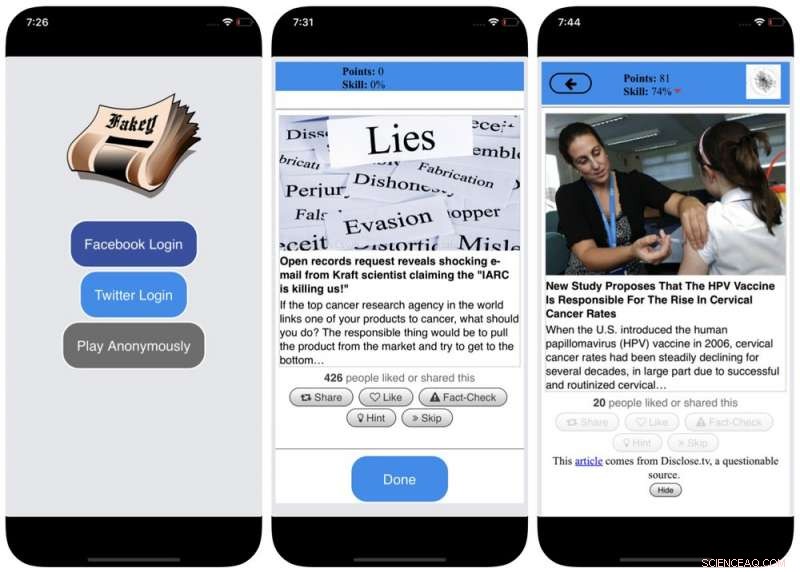

Per contrastare questo pregiudizio, e aiutare le persone a prestare maggiore attenzione alla fonte di un reclamo prima di condividerlo, abbiamo sviluppato Fakey, un gioco di alfabetizzazione alle notizie per dispositivi mobili (gratuito su Android e iOS) che simula un tipico feed di notizie sui social media, con un mix di articoli di notizie da fonti mainstream e a bassa credibilità. I giocatori ottengono più punti condividendo notizie da fonti affidabili e segnalando contenuti sospetti per il controllo dei fatti. Nel processo, imparano a riconoscere i segnali di credibilità della fonte, come affermazioni iperpartigiane e titoli carichi di emozioni.

Bias nella società

Un'altra fonte di pregiudizi viene dalla società. Quando le persone si connettono direttamente con i loro coetanei, i pregiudizi sociali che guidano la loro selezione di amici arrivano a influenzare le informazioni che vedono.

Infatti, nella nostra ricerca abbiamo scoperto che è possibile determinare le inclinazioni politiche di un utente di Twitter semplicemente osservando le preferenze di parte dei suoi amici. La nostra analisi della struttura di queste reti di comunicazione di parte ha rilevato che i social network sono particolarmente efficienti nel diffondere informazioni – accurate o meno – quando sono strettamente legate tra loro e scollegate da altre parti della società.

La tendenza a valutare le informazioni in modo più favorevole se provengono dall'interno dei propri circoli sociali crea "camere di risonanza" che sono mature per la manipolazione, consapevolmente o meno. Questo aiuta a spiegare perché così tante conversazioni online si trasformano in scontri "noi contro loro".

Screenshot del gioco Fakey. Crediti:Mihai Avram e Filippo Menczer

Per studiare come la struttura dei social network online rende gli utenti vulnerabili alla disinformazione, abbiamo costruito Hoaxy, un sistema che traccia e visualizza la diffusione di contenuti da fonti a bassa credibilità, e come compete con il contenuto del fact-checking. La nostra analisi dei dati raccolti da Hoaxy durante le elezioni presidenziali statunitensi del 2016 mostra che gli account Twitter che condividevano disinformazione erano quasi completamente tagliati fuori dalle correzioni apportate dai fact-checker.

Quando abbiamo approfondito gli account che diffondono disinformazione, abbiamo trovato un nucleo molto denso di account che si ritwittavano a vicenda quasi esclusivamente, inclusi diversi bot. Le uniche volte in cui le organizzazioni di controllo dei fatti sono state citate o menzionate dagli utenti nel gruppo disinformato sono state quando hanno messo in dubbio la loro legittimità o hanno affermato il contrario di ciò che hanno scritto.

Bias nella macchina

Il terzo gruppo di pregiudizi deriva direttamente dagli algoritmi utilizzati per determinare ciò che le persone vedono online. Sia le piattaforme di social media che i motori di ricerca li utilizzano. Queste tecnologie di personalizzazione sono progettate per selezionare solo i contenuti più coinvolgenti e pertinenti per ogni singolo utente. Ma così facendo, potrebbe finire per rafforzare i pregiudizi cognitivi e sociali degli utenti, rendendoli così ancora più vulnerabili alla manipolazione.

Ad esempio, gli strumenti pubblicitari dettagliati integrati in molte piattaforme di social media consentono agli attivisti della disinformazione di sfruttare i pregiudizi di conferma adattando i messaggi alle persone che sono già inclini a crederci.

Anche, se un utente fa spesso clic sui link di Facebook da una particolare fonte di notizie, Facebook tenderà a mostrare a quella persona più contenuti di quel sito. Questo cosiddetto effetto "bolla filtro" può isolare le persone da diverse prospettive, rafforzamento del bias di conferma.

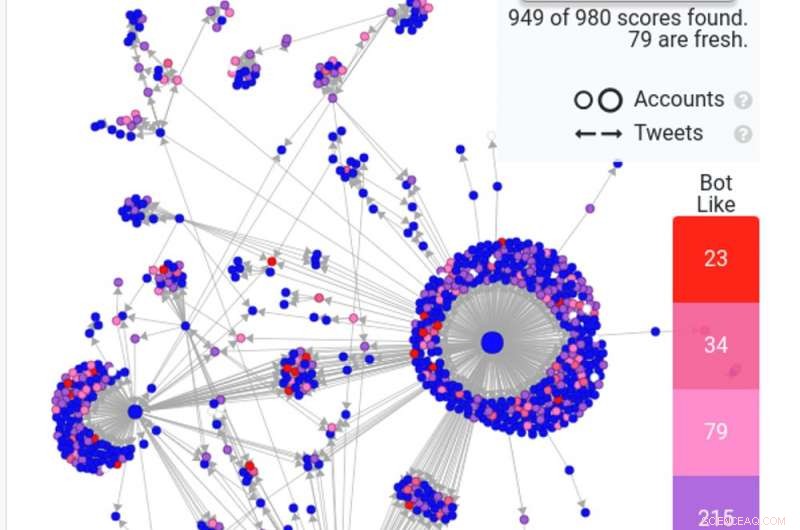

Uno screenshot di una ricerca Hoaxy mostra come i comuni bot - in rosso e rosa scuro - stanno diffondendo una falsa storia su Twitter. Credito:Hoaxy

La nostra ricerca mostra che le piattaforme di social media espongono gli utenti a un insieme di fonti meno diversificato rispetto a siti di social media come Wikipedia. Perché questo è a livello di un'intera piattaforma, non di un singolo utente, chiamiamo questo bias di omogeneità.

Un altro ingrediente importante dei social media sono le informazioni di tendenza sulla piattaforma, in base a ciò che sta ottenendo il maggior numero di clic. Chiamiamo questo bias di popolarità, perché abbiamo scoperto che un algoritmo progettato per promuovere contenuti popolari può influire negativamente sulla qualità complessiva delle informazioni sulla piattaforma. Questo alimenta anche i pregiudizi cognitivi esistenti, rafforzando ciò che sembra essere popolare indipendentemente dalla sua qualità.

Tutti questi pregiudizi algoritmici possono essere manipolati dai social bot, programmi per computer che interagiscono con gli esseri umani attraverso account di social media. La maggior parte dei social bot, come il Big Ben di Twitter, sono innocui. Però, alcuni nascondono la loro vera natura e sono usati per intenti maligni, come aumentare la disinformazione o creare falsamente l'apparenza di un movimento di base, chiamato anche "astroturfing". Abbiamo trovato prove di questo tipo di manipolazione nella corsa alle elezioni di medio termine degli Stati Uniti del 2010.

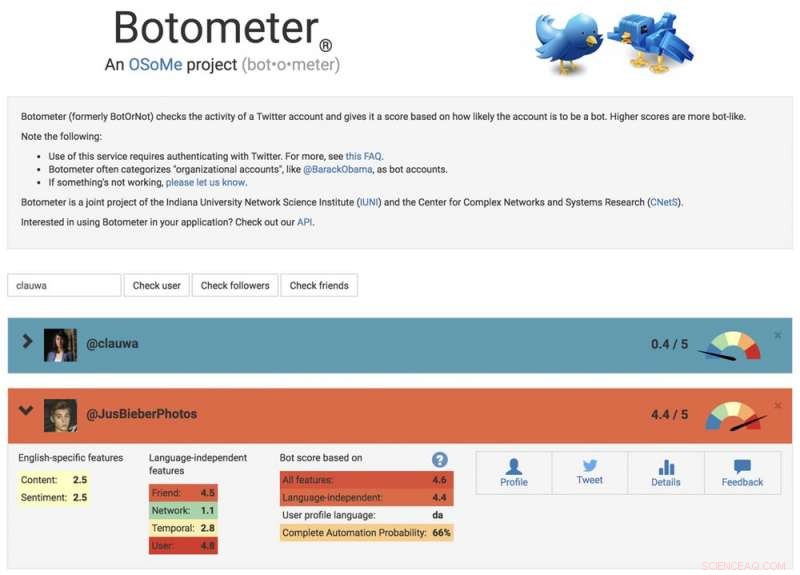

Per studiare queste strategie di manipolazione, abbiamo sviluppato uno strumento per rilevare i social bot chiamato Botometer. Botometer utilizza l'apprendimento automatico per rilevare gli account bot, ispezionando migliaia di diverse funzionalità degli account Twitter, come i tempi dei suoi post, quanto spesso twitta, e gli account che segue e retweet. non è perfetto, ma ha rivelato che ben il 15% degli account Twitter mostra segni di essere dei bot.

Utilizzando Botometer in combinazione con Hoaxy, abbiamo analizzato il nucleo della rete di disinformazione durante la campagna presidenziale degli Stati Uniti del 2016. Abbiamo trovato molti bot che sfruttano sia il cognitivo, pregiudizi di conferma e popolarità delle loro vittime e pregiudizi algoritmici di Twitter.

Questi bot sono in grado di costruire bolle di filtro attorno agli utenti vulnerabili, alimentandoli con false affermazioni e disinformazione. Primo, possono attirare l'attenzione degli utenti umani che supportano un determinato candidato twittando gli hashtag di quel candidato o menzionando e ritwittando la persona. Quindi i bot possono amplificare false affermazioni che diffamano gli avversari ritwittando articoli da fonti a bassa credibilità che corrispondono a determinate parole chiave. Questa attività consente inoltre all'algoritmo di evidenziare per altri utenti le false storie che vengono ampiamente condivise.

Uno screenshot del sito Web di Botometer, mostrando un account umano e un bot. Credito:Botometer

Comprendere le vulnerabilità complesse

Anche se la nostra ricerca, e altri', mostra come gli individui, istituzioni e persino intere società possono essere manipolate sui social media, ci sono ancora molte domande a cui rispondere. È particolarmente importante scoprire come questi diversi pregiudizi interagiscono tra loro, potenzialmente creando vulnerabilità più complesse.

Strumenti come il nostro offrono agli utenti di Internet maggiori informazioni sulla disinformazione, e quindi un certo grado di protezione dai suoi danni. Le soluzioni probabilmente non saranno solo tecnologiche, anche se probabilmente ci saranno alcuni aspetti tecnici in loro. Ma devono tener conto degli aspetti cognitivi e sociali del problema.

Nota dell'editore:questo articolo è stato aggiornato il 10 gennaio, 2019, per rimuovere un collegamento a uno studio che è stato ritirato. Il testo dell'articolo è ancora accurato, e rimane invariato.

Questo articolo è stato originariamente pubblicato su The Conversation. Leggi l'articolo originale.