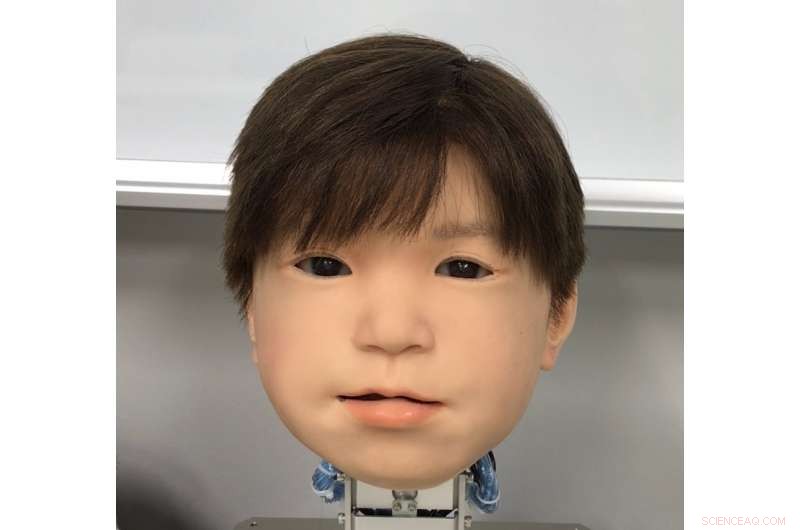

ha appena sviluppato il volto del robot androide bambino Affetto. Il volto di Affetto è stato rivelato per la prima volta in una ricerca pubblicata nel 2011. Credito:Università di Osaka

L'affetto del Giappone per i robot non è un segreto. Ma il sentimento è reciproco negli incredibili androidi del paese? I robotisti sono ora un passo avanti nel dare agli androidi maggiori espressioni facciali con cui comunicare.

Nonostante i progressi, catturare espressioni umanistiche in un volto robotico rimane una sfida sfuggente. Sebbene le loro proprietà di sistema siano state generalmente affrontate, le espressioni facciali degli androidi non sono state esaminate in dettaglio. Ciò è dovuto a fattori quali la vasta gamma e l'asimmetria dei movimenti naturali del viso umano, le restrizioni dei materiali utilizzati nella pelle di Android, e l'intricato ingegneria e matematica che guidano i movimenti dei robot.

Un trio di ricercatori dell'Università di Osaka ha ora trovato un metodo per identificare e valutare quantitativamente i movimenti facciali sulla loro testa di bambino robot androide. chiamato Affetto, il modello di prima generazione è stato riportato in una pubblicazione del 2011. I ricercatori hanno ora sviluppato un sistema per rendere più espressivo l'Affetto di seconda generazione. Le loro scoperte offrono agli androidi un percorso per esprimere una gamma più ampia di emozioni, e alla fine hanno un'interazione più profonda con gli umani.

I ricercatori hanno riportato i loro risultati sulla rivista Frontiere della Robotica e dell'AI .

"Le deformazioni della superficie sono un problema chiave nel controllo dei volti di Android, "Spiega il coautore dello studio Minoru Asada. "I movimenti della loro morbida pelle del viso creano instabilità, e questo è un grosso problema hardware con cui ci confrontiamo. Abbiamo cercato un modo migliore per misurarlo e controllarlo".

I ricercatori hanno studiato 116 diversi punti del viso su Affetto per misurarne il movimento tridimensionale. I punti facciali erano sostenuti dalle cosiddette unità di deformazione. Ogni unità comprende una serie di meccanismi che creano una caratteristica contorsione facciale, come abbassare o alzare parte del labbro o della palpebra. Le misurazioni di questi sono state quindi sottoposte a un modello matematico per quantificare i loro modelli di movimento superficiale.

Mentre i ricercatori hanno incontrato difficoltà nel bilanciare la forza applicata e nella regolazione della pelle sintetica, sono stati in grado di utilizzare il loro sistema per regolare le unità di deformazione per un controllo preciso dei movimenti della superficie facciale di Affetto.

"I volti dei robot Android hanno continuato a essere un problema di scatola nera:sono stati implementati ma sono stati giudicati solo in termini vaghi e generali, ", afferma il primo autore dello studio Hisashi Ishihara. "I nostri risultati precisi ci consentiranno di controllare efficacemente i movimenti facciali di Android per introdurre espressioni più sfumate, come sorridere e accigliarsi."