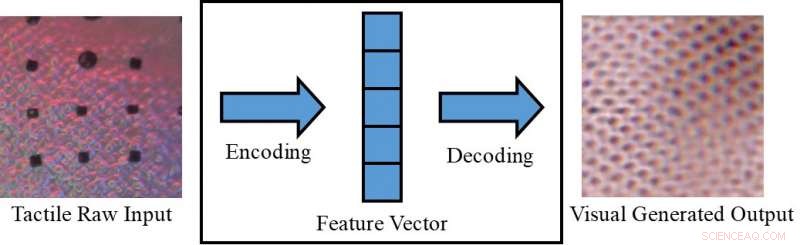

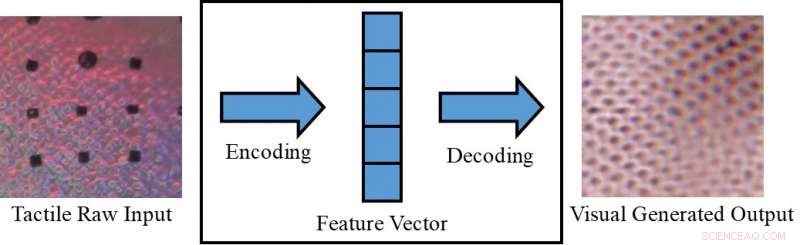

Conversione di un'immagine tattile in un'immagine visiva. Credito:Lee, Bollega &Luo.

Percepire un oggetto solo visivamente (es. su uno schermo) o solo toccandolo, a volte può limitare ciò che siamo in grado di dedurre al riguardo. Esseri umani, però, hanno la capacità innata di integrare stimoli visivi e tattili, sfruttando tutti i dati sensoriali disponibili per completare le loro attività quotidiane.

I ricercatori dell'Università di Liverpool hanno recentemente proposto un nuovo quadro per generare dati sensoriali intermodali, che potrebbe aiutare a replicare informazioni sia visive che tattili in situazioni in cui una delle due non è direttamente accessibile. Il loro quadro potrebbe, ad esempio, consentire alle persone di percepire oggetti su uno schermo (es. capi di abbigliamento su siti di e-commerce) sia visivamente che tattilmente.

"Nella nostra esperienza quotidiana, possiamo creare cognitivamente una visualizzazione di un oggetto basata su una risposta tattile, o una risposta tattile dalla visualizzazione della trama di una superficie, "Dottor Shan Luo, uno dei ricercatori che ha condotto lo studio, ha detto a TechXplore. "Questo fenomeno percettivo, chiamata sinestesia, in cui la stimolazione di un senso provoca una reazione involontaria in uno o più degli altri sensi, può essere impiegato per creare un senso inaccessibile. Ad esempio, quando si afferra un oggetto, la nostra vista sarà ostruita dalla mano, ma verrà generata una risposta al tocco per "vedere" le funzionalità corrispondenti."

Il fenomeno percettivo descritto dal Dr. Luo si verifica tipicamente quando una fonte di percezione non è disponibile (ad es. quando si toccano oggetti all'interno di una borsa senza poterli vedere). In tali situazioni, gli umani potrebbero "toccare per vedere" o "vedere per sentire, " interpretare le caratteristiche relative a un particolare senso in base alle informazioni raccolte usando gli altri sensi. Se replicate nelle macchine, questo meccanismo visivo-tattile potrebbe avere diverse interessanti applicazioni, in particolare nei settori della robotica e dell'e-commerce.

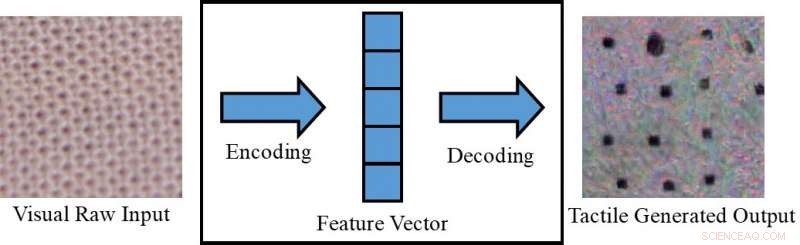

Conversione di un'immagine visiva in un'immagine tattile. Credito:Lee, Bollega &Luo.

Se i robot fossero in grado di integrare la percezione visiva e tattile, potrebbero pianificare le loro strategie di presa e manipolazione in modo più efficace in base alle caratteristiche visive degli oggetti con cui stanno lavorando (ad es. dimensione, eccetera.). In altre parole, i robot percepirebbero le proprietà tattili complessive degli oggetti prima di afferrarli, utilizzando le informazioni visive raccolte dalle telecamere. Mentre si afferra un oggetto al di fuori del campo visivo della telecamera, d'altra parte, userebbero risposte di tipo tattile per compensare la mancanza di informazioni visive disponibili.

Se associato a un dispositivo tattile, che non è ancora stato sviluppato, il framework proposto dal Dr. Luo e dai suoi colleghi potrebbe essere utilizzato anche nell'e-commerce, ad esempio, permettendo ai clienti di sentire il tessuto dei vestiti prima di acquistarli. Con questa applicazione in mente, i ricercatori hanno utilizzato reti contraddittorie generative condizionali per generare immagini pseudo visive utilizzando dati tattili e viceversa (ovvero per generare output tattili utilizzando dati visivi).

"Nei mercati online, i clienti fanno acquisti visualizzando immagini di vestiti o altri oggetti, "Il dottor Luo ha detto. "Tuttavia, non sono in grado di toccare questi oggetti per sentire i loro materiali. Sentire un oggetto è molto importante durante lo shopping, soprattutto quando si acquistano capi delicati, come la biancheria intima. Consentire agli utenti di sentire gli oggetti a casa, utilizzando un dispositivo tattile che deve ancora essere sviluppato, lo schema di generazione di dati sensoriali intermodali proposto nel nostro documento può aiutare i clienti dell'e-commerce a fare scelte più informate".

Il Dr. Luo e i suoi colleghi hanno valutato il loro modello sul set di dati VITAc, che contiene immagini macro e letture tattili (acquisite utilizzando un sensore GelSight) di 100 diversi tipi di tessuto. Hanno scoperto che potrebbe prevedere efficacemente gli output sensoriali per un senso (cioè la vista o il tatto) utilizzando dati rilevanti per l'altro.

Sensore GelSight. Credito:Lee, Bollega &Luo.

"Prendiamo come esempio la percezione della trama:le immagini di input visivo di una trama di stoffa vengono utilizzate per generare una lettura pseudo tattile dello stesso pezzo di stoffa; al contrario, le letture tattili di un tessuto sono impiegate per prevedere un'immagine visiva dello stesso tessuto, " ha spiegato il dottor Luo. "Le trame dei tessuti, cioè., i modelli di distribuzione del filato, appaiono in modo simile in un'immagine visiva e in una lettura della distribuzione della pressione (cioè tattile). Però, questo lavoro può anche essere esteso per ottenere la generazione di dati visivo-tattili cross-modali per la percezione di altre proprietà dell'oggetto, considerando le differenze tra i due domini."

Lo studio condotto dal Dr. Luo e dai suoi colleghi ha ottenuto risultati notevoli nella generazione di modelli tattili e visivi realistici per diversi tessuti in assenza di informazioni tattili o visive, di conseguenza. Usando la loro struttura, i ricercatori hanno "replicato" con successo elementi tattili di tessuti utilizzando dati visivi, e viceversa.

"Per la nostra migliore conoscenza, questo lavoro è il primo tentativo di ottenere la generazione robotica di dati visivo-tattili cross-modali, che può essere esteso anche alla generazione di dati cross-modali per altre modalità, "Il dottor Luo ha detto. "Le implicazioni pratiche del nostro studio sono che possiamo usare altri sensi per creare un senso inaccessibile".

Nel futuro, la struttura proposta dal Dr. Luo e dai suoi colleghi potrebbe essere utilizzata per migliorare le strategie di presa e manipolazione nei robot, nonché per migliorare le esperienze di acquisto online. Il loro metodo potrebbe essere utilizzato anche per espandere i set di dati per compiti di classificazione, generando dati sensoriali altrimenti inaccessibili.

Credito:Lee, Bollega &Luo.

"Nella ricerca futura, cercheremo di applicare il nostro metodo a una serie di compiti diversi, come la classificazione visiva e tattile in un ambiente reale, con oggetti che variano nell'aspetto (es. forma, colore ecc.), " disse il dottor Luo. Inoltre, il metodo di generazione dei dati visivo-tattile proposto sarà utilizzato per facilitare le attività robotiche, come afferrare e manipolare".

Il documento che delinea questo recente studio, pre-pubblicato su arXiv, sarà presentato alla Conferenza Internazionale 2019 sulla Robotica e l'Automazione (ICRA), che si svolgerà a Montreal, Canada, tra il 20 e il 24 maggio. Alla conferenza, Il Dr. Luo terrà anche un workshop relativo all'argomento del suo studio, chiamato "ViTac:Integrare visione e tatto per la percezione multimodale e cross-modale".

© 2019 Science X Network