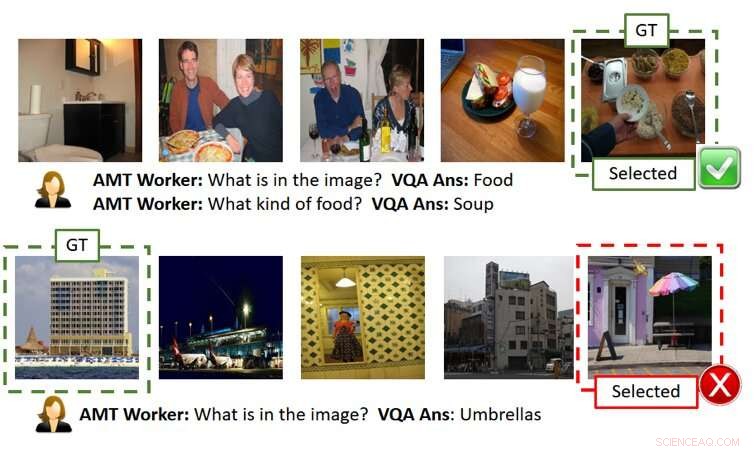

La figura sopra mostra due giochi senza spiegazioni (ogni riga è un esempio di gioco). Come mostrato nella riga superiore, l'utente (cioè AMT Worker da quando abbiamo utilizzato Amazon Mechanical Turk per una valutazione basata su crowd-source su larga scala) è in grado di capire correttamente l'immagine segreta fornendo risposte AI accurate. Però, come mostrato nella riga in basso, l'utente può fallire anche quando le risposte dell'IA sono ragionevoli ma leggermente fuori luogo (cioè, c'è una struttura che sembra un ombrello accanto all'edificio sebbene non sia il fulcro dell'immagine della verità del terreno). GT significa Ground Truth (cioè l'immagine segreta), Selezionata è l'immagine selezionata dall'utente dopo aver posto le domande e aver ottenuto le risposte e/o le spiegazioni. Credito:Ray et al.

Negli ultimi anni, i ricercatori hanno cercato di rendere più trasparente l'intelligenza artificiale (AI) sviluppando algoritmi in grado di spiegare le loro azioni e comportamenti, in quanto ciò potrebbe incoraggiare una maggiore fiducia nelle macchine e migliorare le interazioni uomo-IA. Nonostante i loro sforzi, finora pochissimi studi hanno valutato in modo tangibile l'impatto delle spiegazioni dell'IA sulle prestazioni raggiunte in compiti che implicano la collaborazione uomo-IA.

Per colmare questa lacuna nella letteratura esistente, un team di ricercatori di SRI International ha creato un gioco di indovinelli umano-IA ispirato al popolare gioco 20 Domande (20Q), che può essere utilizzato per valutare l'utilità delle spiegazioni della macchina. La loro carta, recentemente pubblicato su arXiv, è tra i primi ad esplorare gli effetti dello sviluppo di un'IA più "spiegabile".

"L'idea è nata mentre stavamo lavorando a un progetto DARPA, "Arijit Ray, un informatico presso SRI International che ha svolto lo studio, ha detto a TechXolore. "In questo progetto, stiamo sviluppando sistemi di intelligenza artificiale spiegabili, che non solo generano l'output desiderato (ad es. rilevamento di oggetti, risposte alle domande, ecc.) ma anche spiegazioni su come sono arrivati a quell'uscita. Avevamo bisogno di un meccanismo per valutare se le spiegazioni aggiuntive fornite dalle IA fossero utili all'utente per comprendere meglio i sistemi di IA. A tal fine, abbiamo creato un compito collaborativo umano-IA interattivo, Indovina con spiegazione assistita (ExAG), che è un adattamento del famoso gioco 20Q, per dimostrare l'efficacia delle varie tecniche di spiegazione meccanica che stiamo sviluppando."

Il gioco di indovinare le immagini sviluppato da Ray e dai suoi colleghi ricorda da vicino il popolare gioco 20 Domande, che di solito coinvolge due giocatori. Nel 20Q, un giocatore pensa a qualcosa e il secondo giocatore cerca di indovinare di cosa si tratta ponendo 20 domande a risposta chiusa (cioè, domande a cui è possibile rispondere solo con 'sì' o 'no').

In ExAG, l'adattamento del gioco ideato da Ray e dai suoi colleghi, a un utente vengono mostrate cinque immagini, uno dei quali è stato scelto dal sistema di intelligenza artificiale come "immagine segreta". Essenzialmente, l'utente deve capire quale tra le immagini che ha visto è l'immagine segreta, ' ponendo domande in linguaggio naturale al riguardo.

In contrasto con il tradizionale gioco 20Q, in ExAG gli utenti umani possono porre domande sia chiuse che aperte. Ad esempio, potrebbero chiedere 'cosa c'è nell'immagine?, ' 'dove è stata scattata l'immagine?' e così via. Il sistema di intelligenza artificiale risponde alle domande di un utente una alla volta e può opzionalmente spiegare le sue risposte.

Sulla base di queste risposte, l'utente cercherà quindi di indovinare l'immagine che l'IA aveva originariamente selezionato. L'obiettivo generale del gioco è identificare correttamente l'"immagine segreta" ponendo il minor numero di domande possibile.

"Il sistema di intelligenza artificiale fornisce due modalità di spiegazione, visivo e testuale, " ha spiegato Ray. "Per spiegazioni visive, il sistema AI genera mappe di calore evidenziando le regioni che supportano le sue risposte. Per esempio, se un utente chiede cosa c'è nell'immagine, e sembra un cane, l'IA evidenzierà la regione del cane e dirà che questo è ciò che porta alla risposta "è un cane". Per spiegazioni testuali, d'altra parte, il sistema AI fornisce risposte a domande correlate per ciascuna delle immagini. Così, se chiedi cosa sta facendo una persona e la risposta è navigare, ad esempio, risponderà anche a domande correlate come "cosa vedo nell'immagine? Un surfista». 'Dove è stata scattata la foto? Una spiaggia.'

A causa della natura del gioco di indovinare le immagini, la qualità delle risposte e delle spiegazioni fornite dall'IA può influenzare in modo significativo il successo e le prestazioni di un utente umano. Vale la pena notare che l'attuale stato dell'arte nella risposta visiva alle domande è di circa il 65 percento, il che significa che il sistema di intelligenza artificiale genera risposte corrette il 65% delle volte.

Ray e i suoi colleghi hanno osservato che gli utenti in genere riuscivano in ExAG sfruttando le spiegazioni dell'IA, soprattutto quando le risposte stesse erano sbagliate. Per esempio, se l'"immagine segreta" ritrae un cane, ma l'intelligenza artificiale risponde "è un surfista, ' una spiegazione visiva potrebbe aiutare un utente umano a rendersi conto dell'errore dell'IA. Secondo i ricercatori, questo dimostra che il loro gioco è uno strumento adatto per valutare l'utilità delle spiegazioni dell'IA.

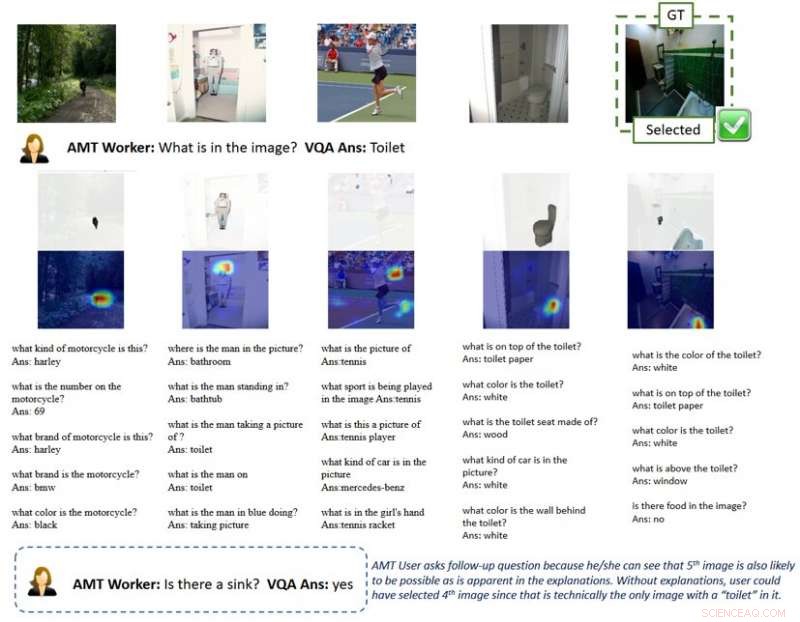

La figura sopra mostra un gameplay con spiegazioni. La spiegazione visiva della mappa di calore evidenzia le regioni nelle immagini che portano alle risposte AI. Con una tale spiegazione, gli utenti capiscono che i sistemi di intelligenza artificiale possono raccogliere oggetti che non sono l'obiettivo principale dell'immagine nella prospettiva umana quando rispondono a una domanda generale come "cosa c'è nell'immagine". Questo suggerisce all'utente di porre domande di follow-up e infine selezionare correttamente l'immagine segreta. GT significa Ground Truth (cioè l'immagine segreta), Selezionata è l'immagine selezionata dall'utente dopo aver posto le domande e aver ottenuto le risposte e/o le spiegazioni. Credito:Ray et al.

"Secondo me, il risultato più interessante del nostro studio è che gli utenti possono utilizzare solo alcune buone spiegazioni per vincere le partite quando le risposte dell'IA sono per lo più sbagliate, "Ha detto Ray. "Al contrario, per i giochi con una precisione di risposta simile ma senza spiegazioni, gli utenti si fidano ciecamente delle risposte generate dall'IA e perdono la partita. Ciò supporta l'importanza anche di alcune buone spiegazioni per un sistema collaborativo uomo-IA, soprattutto quando il sistema di intelligenza artificiale è imperfetto, che è nella maggior parte dei casi in questi giorni."

Per spiegare meglio questa idea, Ray offre l'esempio dei veicoli a guida autonoma. Negli ultimi anni, si è molto discusso sulla loro sicurezza, anche a causa di incidenti avvenuti durante il collaudo dei veicoli. Secondo Ray, spiegazioni efficaci dell'IA potrebbero incoraggiare una maggiore fiducia nella sicurezza dei veicoli a guida autonoma, in quanto consentirebbero ai conducenti umani di identificare in anticipo i problemi e prevenire gli incidenti.

"Ad esempio, supponiamo che il sistema di intelligenza artificiale abbia problemi a rilevare le corsie in modo affidabile, "Ha detto Ray. "Dal momento che la strada è attualmente diritta, senza ulteriori informazioni, l'utente non sarebbe in grado di dire se l'IA sta fallendo. Anche se aveva dei dubbi, probabilmente non farebbe nulla fino all'ultimo momento, quando l'auto deve fare una svolta, non lo fa, e si schianta, che sarebbe troppo tardi. In contrasto, se uno schermo nell'auto mostrasse spiegazioni su come l'IA percepisce l'ambiente, come mappe di calore, l'utente sarebbe in grado di riconoscere il guasto latente dell'IA e prendere il controllo del volante in anticipo."

I ricercatori hanno scoperto che spiegazioni utili hanno influito positivamente sulle prestazioni degli utenti umani nel gioco di indovinare le immagini. I loro risultati suggeriscono che avere almeno una spiegazione "corretta" era significativamente utile, in particolare nei casi in cui le risposte dell'IA alle domande degli utenti erano "rumorose" o mal definite. interessante, i giocatori hanno sviluppato una preferenza per le spiegazioni rispetto alle risposte e spesso hanno valutato le spiegazioni dell'IA come "utili".

"Penso che mentre diverse linee di lavoro hanno cercato di fornire spiegazioni per i risultati o le azioni di un sistema di intelligenza artificiale, il nostro è il primo studio a introdurre un compito di collaborazione uomo-macchina per valutare l'efficacia delle spiegazioni dell'IA; così, ha portato molte informazioni su come le spiegazioni dell'IA potrebbero migliorare le interazioni uomo-robot, "Yi Yao, un dirigente tecnico senior presso SRI International che è stato coinvolto nello studio, ha detto a TechXplore.

Lo studio condotto da Ray e dai suoi colleghi è uno dei primi a fornire prove tangibili dell'utilità delle spiegazioni dell'IA. I ricercatori sperano che la loro ricerca alla fine informerà lo sviluppo di sistemi di intelligenza artificiale che possono agire razionalmente nella società, così connettersi e relazionarsi meglio con gli esseri umani.

Secondo Ray, I sistemi di intelligenza artificiale in grado di spiegare chiaramente il ragionamento e i processi alla base delle loro azioni sarebbero un significativo passo avanti nello sviluppo di macchine intelligenti. Rispondendo efficacemente alle domande e razionalizzando le proprie decisioni, questi sistemi potrebbero favorire un maggiore senso di fiducia nell'IA, così come un rapporto più profondo con esso.

"Molte altre società, gruppi e gruppi di ricerca si sono occupati di AI spiegabile, e ci sono state molte proposte su come estendere i modelli e i sistemi di intelligenza artificiale esistenti per fornire spiegazioni agli utenti, " disse Giedrius Burachas, uno scienziato informatico senior presso SRI International e investigatore principale dietro lo studio DARPA che ha portato allo sviluppo del gioco Indovina quale. "Mentre sono state generate molte idee, prove che queste idee funzionassero mancassero, quindi uno dei lati forti della nostra ricerca è che fornisce prove indiscutibili che certi tipi di spiegazioni sono davvero molto efficaci nel migliorare la collaborazione con i sistemi di intelligenza artificiale, ma anche nel creare fiducia in loro".

Fino ad ora, il lavoro di Ray e dei suoi colleghi si è concentrato principalmente sui compiti di risposta visiva alle domande (VQA), dove gli utenti fanno domande sulle immagini e le risposte dell'intelligenza artificiale. Ora stanno pianificando di continuare la loro ricerca sulle tecniche di spiegazione dell'IA, applicare queste tecniche a un ambito più ampio di attività di intelligenza artificiale.

"Continueremo inoltre a sviluppare protocolli per valutare l'efficacia delle spiegazioni generate dall'intelligenza artificiale con una granularità più fine (ad esempio quale spiegazione è più efficace in quali scenari?) e da diverse prospettive (ad esempio le spiegazioni aiutano gli utenti a costruire il modello mentale?), " ha detto Ray. "Per chiudere il cerchio, useremo le lezioni apprese da queste valutazioni per sviluppare metodi di spiegazione più efficaci. Riteniamo che il Santo Graal dell'IA spiegabile sia ideare spiegazioni che non solo informino gli utenti, ma migliorino anche le prestazioni della macchina migliorando la sua capacità di ragionamento".

Oltre a esplorare gli effetti delle spiegazioni dell'IA sulle prestazioni e sulle percezioni degli utenti umani, perciò, i ricercatori vorrebbero indagare sul loro impatto sui sistemi di intelligenza artificiale stessi. Ritengono che le spiegazioni dell'IA potrebbero anche migliorare intrinsecamente i sistemi di intelligenza artificiale, man mano che acquisirebbero capacità di ragionamento e razionalizzazione.

© 2019 Science X Network