Cinzia Rudino. Credito:Duke University

Poiché le parole d'ordine "apprendimento automatico" continuano a crescere in popolarità, sempre più industrie si rivolgono agli algoritmi informatici per rispondere a domande importanti, compresi i settori ad alto rischio come l'assistenza sanitaria, finanza e giustizia penale. Sebbene questa tendenza possa portare a importanti miglioramenti in questi ambiti, può anche portare a grossi problemi quando l'algoritmo di apprendimento automatico è una cosiddetta "scatola nera".

Una scatola nera è un programma di apprendimento automatico che non spiega come arriva alle sue conclusioni, o perché è troppo complicato da capire per un essere umano o perché i suoi meccanismi interni sono proprietari. In risposta alle preoccupazioni che questi tipi di modelli possano includere meccanismi interni ingiusti, come il razzismo, un'altra tendenza in crescita è quella di creare modelli aggiuntivi per "spiegare" queste scatole nere.

In un nuovo editoriale pubblicato su Intelligenza della macchina della natura , Cinzia Rudino, professore associato di informatica, ingegneria elettrica e informatica, matematica, e scienze statistiche alla Duke University, sostiene che i modelli della scatola nera devono essere abbandonati per le decisioni ad alto rischio. Anche quando vengono creati i cosiddetti modelli esplicativi, lei dice, i decisori dovrebbero optare per modelli interpretabili, che sono completamente trasparenti e facilmente comprensibili dai suoi utenti.

I modelli spiegabili sono sbagliati

I modelli di apprendimento automatico "spiegabili" sono costruiti nel tentativo di capire cosa sta succedendo all'interno di una scatola nera. Se può produrre gli stessi risultati, la gente presume che sia una rappresentazione accurata.

Ma non lo è.

Gli algoritmi spiegabili forniscono spiegazioni imprecise per definizione, altrimenti i complessi meccanismi interni della scatola nera non sarebbero necessari. Mentre un modello esplicativo può produrre risultati simili o addirittura esatti all'algoritmo della scatola nera originale, non c'è modo di sapere se sta usando gli stessi parametri o meno.

"Se un decimo delle spiegazioni è sbagliato, non puoi fidarti delle spiegazioni, e quindi non puoi fidarti della scatola nera originale, " dice Rudin. "Se non possiamo sapere con certezza se la nostra spiegazione è corretta, non possiamo sapere se fidarci né della spiegazione né del modello originale."

Più non è uguale a meglio

Le persone in genere presumono che solo perché un algoritmo di apprendimento automatico è complicato, che è più preciso di uno semplice. Ma questa convinzione è infondata.

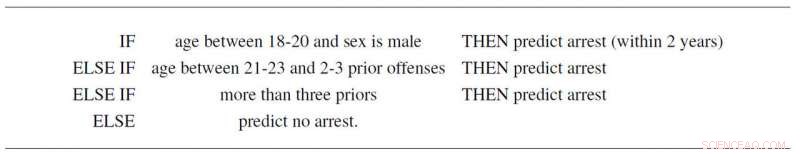

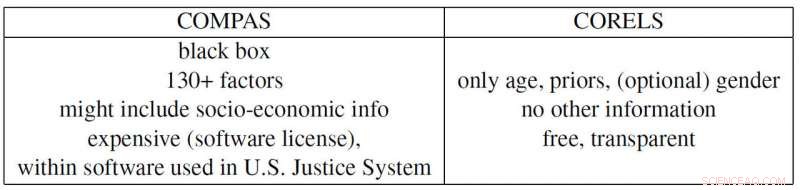

Per esempio, Rudin e collaboratori Elaine Angelino, Margo Seltzer, Nicholas Larus-Stone e Daniel Alabi hanno creato un modello interpretabile semplice per la recidiva criminale basato solo sull'età, sesso e precedenti. Non solo segue tre semplici regole che chiunque può capire, prevede la probabilità di futuri arresti così come il controverso programma "COMPAS", che è ampiamente impiegato nel sistema giudiziario degli Stati Uniti. E oltre ad essere una scatola nera che molti sospettano utilizzi pregiudizi razzisti, COMPAS utilizza più di 130 informazioni per fare le sue previsioni, che è un grosso problema di per sé.

"Se le persone che inseriscono questi dati commettono un errore tipografico solo l'uno per cento delle volte, quindi più di 1 sondaggio su 2 in media avrà almeno un errore, " dice Rudin. "Inoltre, un modello di scatola nera eccessivamente complicato può essere difettoso senza che nessuno se ne accorga, perché è difficile da risolvere".

L'esempio di Propublica

ProPublica ha recentemente accusato l'algoritmo della scatola nera di recidiva COMPAS di essere razzista perché ha creato un modello spiegabile basato sulla razza che riproduce i risultati di COMPAS. Ma poiché le pressioni della società hanno creato un sistema di giustizia penale in cui la storia criminale e l'età sono correlate alla razza in ogni set di dati, l'attuale scatola nera COMPAS potrebbe effettivamente dipendere solo dalle prime due variabili. Ma poi di nuovo, potrebbe anche usare la razza come fattore proprio come sostiene ProPublica. Il problema è che è impossibile dirlo perché COMPAS è una scatola nera proprietaria (costosa) in cui nessuno tranne i suoi proprietari può scrutare.

Rudin indica anche molti altri esempi problematici contemporanei. La scatola nera proprietaria BreezoMeter ha detto agli utenti in California che la loro qualità dell'aria era perfettamente buona quando la qualità dell'aria era pericolosamente cattiva secondo molti altri modelli. Un modello di apprendimento automatico progettato per leggere i raggi X stava rilevando la parola "portatile" all'interno di un'immagine a raggi X, che rappresenta il tipo di apparecchiatura a raggi X piuttosto che il contenuto medico dell'immagine, e quindi riportando cattive conclusioni.

"Esiste un conflitto di responsabilità nell'uso di modelli a scatola nera per decisioni ad alto rischio. Le aziende che traggono profitto da questi modelli non sono necessariamente responsabili della qualità delle previsioni individuali, " dice Rudin. "Un detenuto che sconta una pena troppo lunga a causa di un errore inserito in un punteggio di rischio eccessivamente complicato potrebbe soffrire per anni, mentre l'azienda che ha costruito questo modello trae vantaggio dalla sua complessità e correttezza. In tal senso, i designer del modello non sono incentivati a prestare attenzione nel suo design, prestazioni e facilità d'uso. Questi sono alcuni degli stessi tipi di problemi che affliggono le agenzie di rating del credito che hanno fissato il prezzo dei mutui nel 2008".

"Spero che le persone si rendano conto dei rischi nei modelli spiegabili e che in realtà non abbiano affatto bisogno di scatole nere. Possono utilizzare modelli completamente interpretabili, " dice Rudin. "Mi piacerebbe vedere un sistema in cui non viene utilizzato alcun algoritmo di scatola nera per una decisione ad alto rischio a meno che non ci sia un modello interpretabile altrettanto accurato. Ho lavorato su molte applicazioni diverse:cure mediche, energia, rischio di credito, recidiva criminale, visione artificiale e non ho mai trovato un'applicazione in cui sia effettivamente necessaria una scatola nera."