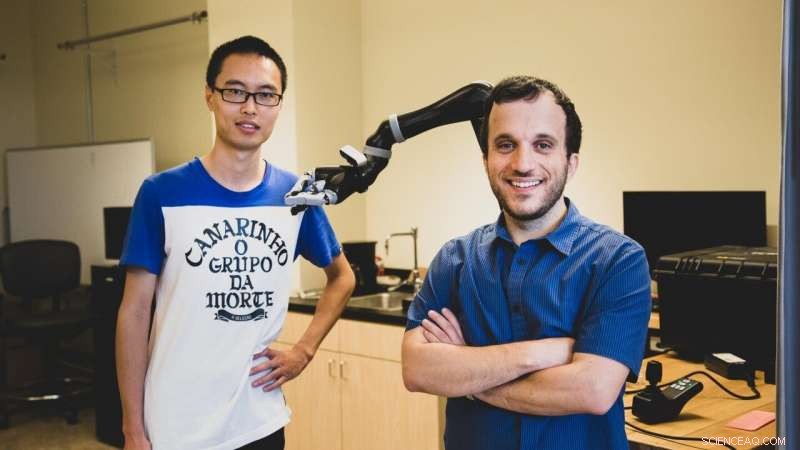

Il dottorando USC Jiali Duan (a sinistra) e Stefanos Nikolaidis, un assistente professore di informatica, utilizzare l'apprendimento per rinforzo, una tecnica in cui i programmi di intelligenza artificiale "imparano" da ripetute sperimentazioni. Credito:Haotian Mai.

Secondo un nuovo studio degli informatici della USC, per aiutare un robot ad avere successo, potresti aver bisogno di mostrargli un po 'di amore duro.

In un compito di manipolazione simulato al computer, i ricercatori hanno scoperto che addestrare un robot con un avversario umano ha migliorato significativamente la sua comprensione degli oggetti.

"Questo è il primo sforzo di apprendimento del robot che utilizza utenti umani avversari, ", ha affermato il coautore dello studio Stefanos Nikolaidis, un assistente professore di informatica.

"Immaginalo come fare uno sport:se giochi a tennis con qualcuno che ti lascia sempre vincere, non migliorerai. Stessa cosa con i robot. Se vogliamo che imparino un compito di manipolazione, come afferrare, così possono aiutare le persone, dobbiamo sfidarli".

Lo studio, "Apprendimento dei robot tramite giochi umani contraddittori, " è stato presentato il 4 novembre alla Conferenza internazionale sui robot e i sistemi intelligenti. Gli studenti di dottorato USC Jiali Duan e Qian Wang sono gli autori principali, consigliato dal Professor C. C. Jay Kuo, con l'ulteriore coautore Lerrel Pinto della Carnegie Mellon University.

Imparare dalla pratica

Nikolaidis, che è entrato a far parte della USC Viterbi School of Engineering nel 2018, e il suo team usano l'apprendimento per rinforzo, una tecnica in cui i programmi di intelligenza artificiale "imparano" da ripetute sperimentazioni.

Invece di limitarsi a completare una piccola gamma di compiti ripetitivi, come robot industriali, il sistema robotico "impara" sulla base degli esempi precedenti, in teoria aumentando la gamma di compiti che può svolgere.

Ma creare robot per tutti gli usi è notoriamente impegnativo, dovuto in parte alla quantità di formazione richiesta. I sistemi robotici devono vedere un numero enorme di esempi per imparare a manipolare un oggetto in modo simile a quello umano.

Ad esempio, L'impressionante sistema robotico di OpenAI ha imparato a risolvere il cubo di Rubik con una mano umanoide, ma richiedeva l'equivalente di 10, 000 anni di addestramento simulato per imparare a manipolare il cubo.

Ma ancora più importante, la destrezza del robot è molto specifica. Senza una formazione approfondita, non può raccogliere un oggetto, manipolalo con un'altra presa, oppure afferrare e maneggiare un oggetto diverso.

"Come umano, anche se conosco la posizione dell'oggetto, Non so esattamente quanto pesa o come si muoverà o si comporterà quando lo prendo, eppure lo facciamo con successo quasi sempre, " disse Nikolaidis.

"Questo perché le persone sono molto intuitive su come si comporta il mondo, ma il robot è come un neonato."

In altre parole, i sistemi robotici hanno difficoltà a generalizzare, un'abilità che gli umani danno per scontata. Questo può sembrare banale, ma può avere gravi conseguenze. Se i dispositivi robotici di assistenza, come afferrare robot, devono mantenere la loro promessa di aiutare le persone con disabilità, i sistemi robotici devono essere in grado di operare in modo affidabile negli ambienti del mondo reale.

Umano nel ciclo

Una linea di ricerca che ha avuto un discreto successo nel superare questo problema è avere un "umano nel giro". In altre parole, l'essere umano fornisce feedback al sistema robotico dimostrando la capacità di completare l'attività.

Ma, fino ad ora, questi algoritmi hanno fatto una forte supposizione di un supervisore umano cooperante che assiste il robot.

"Ho sempre lavorato sulla collaborazione uomo-robot, ma in realtà, le persone non saranno sempre collaboratrici di robot allo stato brado, " disse Nikolaidis.

Come esempio, indica uno studio di ricercatori giapponesi, che ha liberato un robot in un centro commerciale pubblico e ha osservato più volte i bambini "agire violentemente" nei suoi confronti.

Così, pensò Nikolaidis, e se invece sfruttassimo la nostra inclinazione umana per rendere le cose più difficili per il robot? Piuttosto che mostrargli come afferrare meglio un oggetto, e se provassimo a tirarlo via? Aggiungendo la sfida, il pensiero va, il sistema imparerebbe a essere più robusto rispetto alla complessità del mondo reale.

Elemento di sfida

L'esperimento è andato più o meno così:in una simulazione al computer, il robot tenta di afferrare un oggetto. L'umano, al computer, osserva la presa del robot simulato. Se la presa ha successo, l'umano cerca di strappare l'oggetto dalla presa del robot, utilizzando la tastiera per segnalare la direzione.

L'aggiunta di questo elemento di sfida aiuta il robot a imparare la differenza tra una presa debole (ad esempio, tenendo una bottiglia in alto), contro una presa salda (tenendola nel mezzo), il che rende molto più difficile per l'avversario umano strappare via.

È stata un'idea un po' folle, ammette Nikolaidis, ma ha funzionato.

I ricercatori hanno scoperto che il sistema addestrato con l'avversario umano ha rifiutato le prese instabili, e apprese rapidamente solide prese per questi oggetti. In un esperimento, il modello ha ottenuto una percentuale di successo di presa del 52% con un avversario umano rispetto a una percentuale di successo di presa del 26,5 percento con un collaboratore umano.

"Il robot ha imparato non solo come afferrare gli oggetti in modo più robusto, ma anche per riuscire più spesso con nuovi oggetti con un orientamento diverso, perché ha imparato una presa più stabile, " disse Nikolaidis.

Hanno anche scoperto che il modello addestrato con un avversario umano ha funzionato meglio di un avversario simulato, che aveva un tasso di successo del 28%. Così, i sistemi robotici imparano meglio dagli avversari in carne ed ossa.

"Questo perché gli umani possono comprendere la stabilità e la robustezza meglio degli avversari dotti, " ha spiegato Nikolaidis.

"Il robot cerca di raccogliere cose e, se l'umano cerca di disturbare, porta a prese più stabili. E poiché ha imparato una presa più stabile, riuscirà più spesso, anche se l'oggetto si trova in una posizione diversa. In altre parole, ha imparato a generalizzare. Questo è un grosso problema".

Trovare un equilibrio

Nikolaidis spera di far funzionare il sistema su un vero braccio robotico entro un anno. Questo presenterà una nuova sfida:nel mondo reale, il minimo attrito o rumore nelle articolazioni di un robot può far saltare le cose. Ma Nikolaidis è fiducioso per il futuro dell'apprendimento contraddittorio per la robotica.

"Penso che abbiamo appena scalfito la superficie delle potenziali applicazioni dell'apprendimento tramite giochi umani contraddittori, " disse Nikolaidis.

"Siamo entusiasti di esplorare l'apprendimento dell'avversario umano nel ciclo anche in altre attività, come l'evitamento degli ostacoli per i bracci robotici e i robot mobili, come le auto a guida autonoma".

Questo fa sorgere la domanda:fino a che punto siamo disposti a portare l'apprendimento contraddittorio? Saremmo disposti a prendere a calci e picchiare i robot alla sottomissione? La risposta, disse Nikolaidis, sta nel trovare un equilibrio tra amore duro e incoraggiamento con le nostre controparti robotiche.

"Sento che l'amore duro, nel contesto dell'algoritmo che proponiamo, è di nuovo come uno sport:rientra in regole e vincoli specifici, " disse Nikolaidis.

"Se l'umano rompe solo la pinza del robot, il robot fallirà continuamente e non imparerà mai. In altre parole, il robot deve essere sfidato, ma deve comunque avere successo per poter imparare."