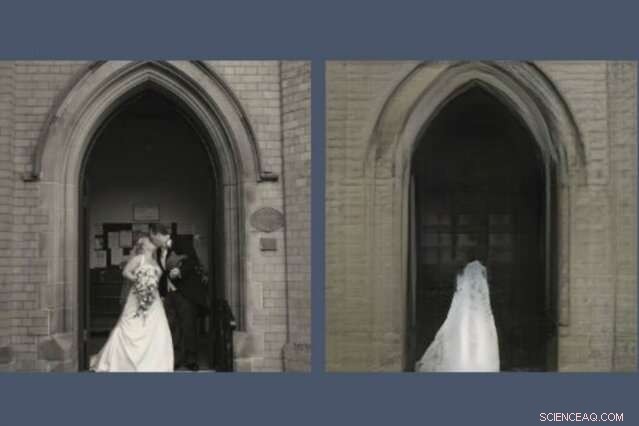

Un nuovo strumento rivela ciò che i modelli di intelligenza artificiale tralasciano nel ricreare una scena. Qui, un GAN, o rete generativa antagonista, ha lasciato cadere la coppia di sposini dalla sua ricostruzione (a destra) della foto che era stato chiesto di disegnare (a sinistra). Credito:Massachusetts Institute of Technology

Chiunque abbia trascorso del tempo sui social media ha probabilmente notato che i GAN, o reti generative avversarie, sono diventati straordinariamente bravi a disegnare volti. Possono prevedere come apparirai quando sarai vecchio e come saresti una celebrità. Ma chiedi a un GAN di disegnare scene dal mondo più ampio e le cose si fanno strane.

Una nuova demo del Watson AI Lab del MIT-IBM rivela ciò che un modello addestrato su scene di chiese e monumenti decide di tralasciare quando disegna la propria versione di, dire, il Pantheon di Parigi, o Piazza di Spagna a Roma. Lo studio più ampio, Vedendo cosa un GAN non può generare, è stato presentato la scorsa settimana alla Conferenza internazionale sulla visione artificiale.

"I ricercatori in genere si concentrano sulla caratterizzazione e sul miglioramento di ciò che un sistema di apprendimento automatico può fare:a cosa presta attenzione, e come particolari input portano a particolari output, "dice David Bau, uno studente laureato presso il Dipartimento di Ingegneria Elettrica e Informatica e Laboratorio di Scienze Informatiche e Artificiali del MIT (CSAIL). "Con questo lavoro, speriamo che i ricercatori prestino la stessa attenzione alla caratterizzazione dei dati che questi sistemi ignorano".

In un GAN, una coppia di reti neurali lavora insieme per creare immagini iperrealistiche modellate sugli esempi che sono stati forniti. Bau si interessò ai GAN come un modo per sbirciare all'interno delle reti neurali black-box per capire il ragionamento dietro le loro decisioni. Uno strumento precedente sviluppato con il suo consulente, Professore del MIT Antonio Torralba, e il ricercatore IBM Hendrik Strobelt, ha permesso di identificare i gruppi di neuroni artificiali responsabili dell'organizzazione dell'immagine in categorie del mondo reale come le porte, alberi, e nuvole. Uno strumento correlato, GANPaint, consente agli artisti dilettanti di aggiungere e rimuovere tali funzionalità dalle proprie foto.

Un giorno, aiutando un artista a usare GANPaint, Bau ha avuto un problema. "Come di solito, stavamo inseguendo i numeri, cercando di ottimizzare la perdita di ricostruzione numerica per ricostruire la foto, " dice. "Ma il mio consigliere ci ha sempre incoraggiato a guardare oltre i numeri ea scrutare le immagini reali. Quando abbiamo guardato, il fenomeno è saltato fuori subito:le persone venivano abbandonate in modo selettivo".

Proprio come i GAN e altre reti neurali trovano schemi in cumuli di dati, ignorano gli schemi, pure. Bau e i suoi colleghi hanno addestrato diversi tipi di GAN su scene interne ed esterne. Ma non importa dove sono state scattate le foto, i GAN hanno costantemente omesso dettagli importanti come persone, macchine, segni, fontane, e mobili, anche quando quegli oggetti apparivano in modo prominente nell'immagine. In una ricostruzione GAN, una coppia di sposini che si baciano sui gradini di una chiesa sono scomparsi, lasciando un'inquietante trama di abito da sposa sulla porta della cattedrale.

"Quando i GAN incontrano oggetti che non possono generare, sembrano immaginare come sarebbe la scena senza di loro, " dice Strobelt. "A volte le persone diventano cespugli o scompaiono completamente nell'edificio dietro di loro".

I ricercatori sospettano che la colpa possa essere della pigrizia delle macchine; sebbene un GAN sia addestrato a creare immagini convincenti, potrebbe imparare che è più facile concentrarsi su edifici e paesaggi e saltare persone e automobili più difficili da rappresentare. I ricercatori sanno da tempo che i GAN hanno la tendenza a trascurare alcuni dettagli statisticamente significativi. Ma questo potrebbe essere il primo studio a dimostrare che i GAN all'avanguardia possono omettere sistematicamente intere classi di oggetti all'interno di un'immagine.

Un'intelligenza artificiale che elimina alcuni oggetti dalle sue rappresentazioni può raggiungere i suoi obiettivi numerici mentre mancano i dettagli più importanti per noi umani, dice Bau. Mentre gli ingegneri si rivolgono ai GAN per generare immagini sintetiche per addestrare sistemi automatizzati come le auto a guida autonoma, c'è il pericolo che le persone, segni, e altre informazioni critiche potrebbero essere eliminate senza che gli esseri umani se ne rendano conto. Mostra perché le prestazioni del modello non dovrebbero essere misurate solo dalla precisione, dice Bau. "Dobbiamo capire cosa sono e cosa non stanno facendo le reti per assicurarci che stiano facendo le scelte che vogliamo che facciano".

Questa storia è stata ripubblicata per gentile concessione di MIT News (web.mit.edu/newsoffice/), un popolare sito che copre notizie sulla ricerca del MIT, innovazione e didattica.