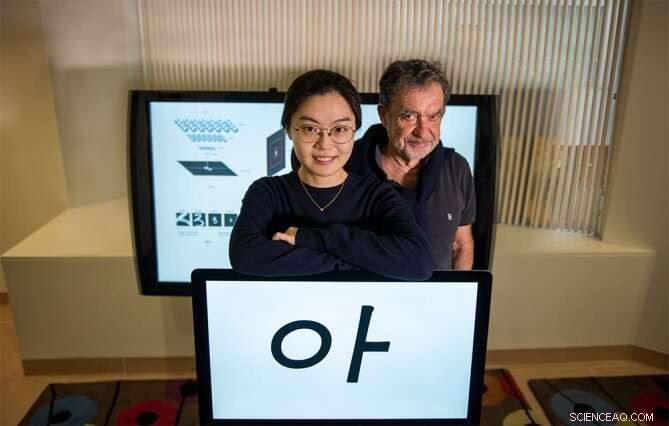

Yena Han (a sinistra) e Tomaso Poggio stanno con un esempio degli stimoli visivi utilizzati in un nuovo studio di psicofisica. Credito:Kris Brewer

Supponi di guardare brevemente da qualche metro di distanza una persona che non hai mai incontrato prima. Fai qualche passo indietro e guarda di nuovo. Riuscirai a riconoscere il suo volto? "Sì, Certo, " probabilmente stai pensando. Se questo è vero, significherebbe che il nostro sistema visivo, aver visto una singola immagine di un oggetto come un viso specifico, lo riconosce in modo robusto nonostante le modifiche alla posizione e alla scala dell'oggetto, Per esempio. D'altra parte, sappiamo che classificatori all'avanguardia, come reti profonde Vanilla, fallirà questo semplice test.

Per riconoscere un volto specifico sotto una serie di trasformazioni, le reti neurali devono essere addestrate con molti esempi del viso nelle diverse condizioni. In altre parole, possono raggiungere l'invarianza attraverso la memorizzazione, ma non può farlo se è disponibile solo un'immagine. Così, capire come la visione umana può realizzare questa straordinaria impresa è importante per gli ingegneri che mirano a migliorare i loro classificatori esistenti. È anche importante per i neuroscienziati che modellano il sistema visivo dei primati con reti profonde. In particolare, è possibile che l'invarianza con l'apprendimento one-shot esibita dalla visione biologica richieda una strategia computazionale piuttosto diversa da quella delle reti profonde.

Un nuovo articolo del MIT Ph.D. candidato in ingegneria elettrica e informatica Yena Han e colleghi in Rapporti scientifici sulla natura , intitolato "Scala e invarianza di traduzione per nuovi oggetti nella visione umana, " discute su come studiano questo fenomeno con maggiore attenzione per creare nuove reti ispirate alla biologia.

"Gli esseri umani possono imparare da pochissimi esempi, a differenza delle reti profonde. Questa è un'enorme differenza con vaste implicazioni per l'ingegneria dei sistemi di visione e per capire come funziona davvero la visione umana, " afferma il coautore Tomaso Poggio, direttore del Center for Brains, Minds and Machines (CBMM) e l'Eugene McDermott Professor of Brain and Cognitive Sciences al MIT. "Una ragione chiave per questa differenza è la relativa invarianza del sistema visivo dei primati rispetto alla scala, spostare, e altre trasformazioni. Stranamente, questo è stato per lo più trascurato nella comunità AI, in parte perché i dati psicofisici erano finora tutt'altro che netti. Il lavoro di Han ha ora stabilito solide misurazioni delle invarianze di base della visione umana".

Per differenziare l'invarianza derivante dal calcolo intrinseco con quella derivante dall'esperienza e dalla memorizzazione, il nuovo studio ha misurato la gamma di invarianza nell'apprendimento one-shot. Un compito di apprendimento one-shot è stato eseguito presentando stimoli di lettere coreane a soggetti umani che non avevano familiarità con la lingua. Queste lettere sono state inizialmente presentate una sola volta in una condizione specifica e testate su scale o posizioni diverse rispetto alla condizione originale. Il primo risultato sperimentale è che, proprio come hai intuito, gli umani hanno mostrato un riconoscimento significativo invariante di scala dopo una sola esposizione a questi nuovi oggetti. Il secondo risultato è che l'intervallo di invarianza di posizione è limitato, a seconda delle dimensioni e della posizione degli oggetti.

Prossimo, Han e i suoi colleghi hanno eseguito un esperimento comparabile in reti neurali profonde progettate per riprodurre questa prestazione umana. I risultati suggeriscono che per spiegare il riconoscimento invariante degli oggetti da parte dell'uomo, i modelli di rete neurale dovrebbero incorporare esplicitamente l'invarianza di scala incorporata. Inoltre, l'invarianza di posizione limitata della visione umana è meglio replicata nella rete facendo aumentare i campi recettivi dei neuroni modello man mano che sono più lontani dal centro del campo visivo. Questa architettura è diversa dai modelli di rete neurale comunemente usati, dove un'immagine viene elaborata con una risoluzione uniforme con gli stessi filtri condivisi.

"Il nostro lavoro fornisce una nuova comprensione della rappresentazione cerebrale degli oggetti sotto diversi punti di vista. Ha anche implicazioni per l'IA, poiché i risultati forniscono nuove informazioni su ciò che è un buon design architettonico per reti neurali profonde, " commenta Han, Ricercatore CBMM e autore principale dello studio.

Questa storia è stata ripubblicata per gentile concessione di MIT News (web.mit.edu/newsoffice/), un popolare sito che copre notizie sulla ricerca del MIT, innovazione e didattica.