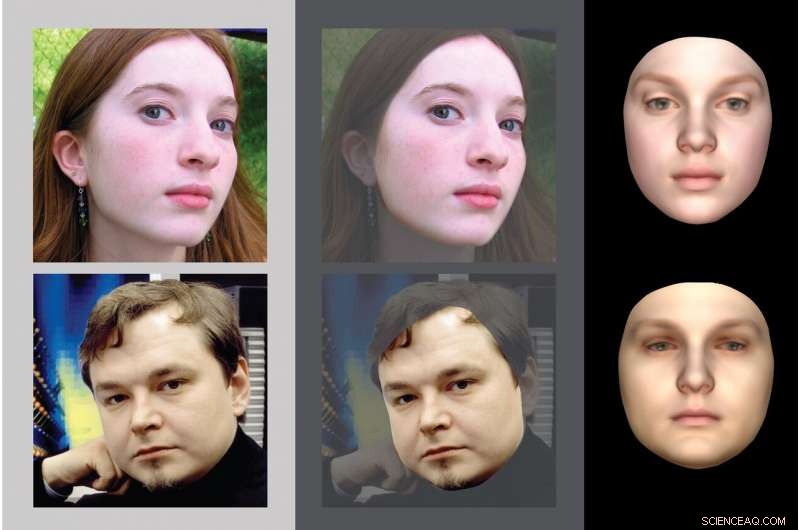

Gli scienziati cognitivi del MIT hanno sviluppato un modello computerizzato di riconoscimento facciale che esegue una serie di calcoli che invertono i passaggi che un programma di computer grafica utilizzerebbe per generare una rappresentazione 2D di un volto. Gli scienziati cognitivi del MIT hanno sviluppato un modello computerizzato di riconoscimento facciale che esegue una serie di calcoli che invertono i passaggi che un programma di computer grafica utilizzerebbe per generare una rappresentazione 2D di un volto. Credito:MIT

Quando apriamo gli occhi, vediamo immediatamente ciò che ci circonda in grande dettaglio. Il modo in cui il cervello è in grado di formare queste rappresentazioni riccamente dettagliate del mondo così rapidamente è uno dei più grandi enigmi irrisolti nello studio della visione.

Gli scienziati che studiano il cervello hanno cercato di replicare questo fenomeno utilizzando modelli di visione al computer, ma così lontano, i modelli principali eseguono solo compiti molto più semplici come individuare un oggetto o una faccia su uno sfondo disordinato. Ora, un team guidato da scienziati cognitivi del MIT ha prodotto un modello al computer che cattura la capacità del sistema visivo umano di generare rapidamente una descrizione dettagliata della scena da un'immagine, e offre alcune informazioni su come il cervello raggiunge questo obiettivo.

"Quello che stavamo cercando di fare in questo lavoro è spiegare come la percezione possa essere molto più ricca del semplice attaccare etichette semantiche su parti di un'immagine, e per esplorare la questione di come vediamo tutto il mondo fisico, "dice Josh Tenenbaum, un professore di scienze cognitive computazionali e membro del Computer Science and Artificial Intelligence Laboratory (CSAIL) del MIT e del Center for Brains, menti, e macchine (CBMM).

Il nuovo modello postula che quando il cervello riceve input visivi, esegue rapidamente una serie di calcoli che invertono i passaggi che un programma di computer grafica utilizzerebbe per generare una rappresentazione 2D di un volto o di un altro oggetto. Questo tipo di modello, nota come grafica inversa efficiente (EIG), si correla bene anche con le registrazioni elettriche da regioni selettive del viso nel cervello dei primati non umani, suggerendo che il sistema visivo dei primati può essere organizzato più o meno allo stesso modo del modello informatico, dicono i ricercatori.

Ilker Yildirim, un ex postdoc del MIT che ora è assistente professore di psicologia alla Yale University, è l'autore principale del documento, che appare oggi in Progressi scientifici . Tenenbaum e Winrich Freiwald, professore di neuroscienze e comportamento alla Rockefeller University, sono gli autori senior dello studio. Mario Belledonne, uno studente laureato a Yale, è anche autore.

Grafica inversa

Decenni di ricerche sul sistema visivo del cervello hanno studiato, in grande dettaglio, come l'ingresso di luce sulla retina si trasforma in scene coese. Questa comprensione ha aiutato i ricercatori di intelligenza artificiale a sviluppare modelli informatici in grado di replicare aspetti di questo sistema, come riconoscere volti o altri oggetti.

"La vista è l'aspetto funzionale del cervello che capiamo meglio, nell'uomo e in altri animali, " Dice Tenenbaum. "E la visione artificiale è una delle aree di maggior successo dell'intelligenza artificiale a questo punto. Diamo per scontato che le macchine ora possano guardare le immagini e riconoscere molto bene i volti, e rilevare altri tipi di oggetti."

Però, anche questi sofisticati sistemi di intelligenza artificiale non si avvicinano a ciò che può fare il sistema visivo umano, Yildirim dice.

"Il nostro cervello non si limita a rilevare che c'è un oggetto laggiù, o riconoscere e mettere un'etichetta su qualcosa, " dice. "Vediamo tutte le forme, la geometria, le superfici, le trame. Vediamo un mondo molto ricco".

Più di un secolo fa, il medico, fisico, e il filosofo Hermann von Helmholtz hanno teorizzato che il cervello crea queste ricche rappresentazioni invertendo il processo di formazione dell'immagine. Ha ipotizzato che il sistema visivo includa un generatore di immagini che sarebbe stato utilizzato, Per esempio, per produrre i volti che vediamo durante i sogni. L'esecuzione di questo generatore al contrario consentirebbe al cervello di lavorare all'indietro dall'immagine e dedurre che tipo di viso o altro oggetto produrrebbe quell'immagine, dicono i ricercatori.

Però, la domanda rimaneva:come potrebbe il cervello eseguire questo processo, noto come grafica inversa, così rapidamente? Gli informatici hanno cercato di creare algoritmi in grado di eseguire questa impresa, ma i migliori sistemi precedenti richiedono molti cicli di elaborazione iterativa, impiegando molto più tempo dei 100-200 millisecondi necessari al cervello per creare una rappresentazione visiva dettagliata di ciò che stai vedendo. I neuroscienziati credono che la percezione nel cervello possa procedere così rapidamente perché è implementata in un passaggio per lo più feedforward attraverso diversi livelli organizzati gerarchicamente di elaborazione neurale.

Il team guidato dal MIT ha deciso di costruire un tipo speciale di modello di rete neurale profonda per mostrare come una gerarchia neurale può dedurre rapidamente le caratteristiche sottostanti di una scena, in questo caso, un volto specifico. In contrasto con le reti neurali profonde standard utilizzate nella visione artificiale, che vengono addestrati da dati etichettati che indicano la classe di un oggetto nell'immagine, la rete dei ricercatori è formata da un modello che riflette le rappresentazioni interne del cervello di come possono apparire le scene con i volti.

Il loro modello impara così a invertire i passaggi eseguiti da un programma di computer grafica per generare volti. Questi programmi di grafica iniziano con una rappresentazione tridimensionale di un singolo volto e poi la convertono in un'immagine bidimensionale, visto da un particolare punto di vista. Queste immagini possono essere posizionate su un'immagine di sfondo arbitraria. I ricercatori teorizzano che il sistema visivo del cervello possa fare qualcosa di simile quando si sogna o si evoca un'immagine mentale del volto di qualcuno.

I ricercatori hanno addestrato la loro rete neurale profonda per eseguire questi passaggi al contrario, ovvero inizia con l'immagine 2-D e poi aggiunge caratteristiche come texture, curvatura, e illuminazione, per creare quella che i ricercatori chiamano una rappresentazione "2.5D". Queste immagini 2.5D specificano la forma e il colore del viso da un particolare punto di vista. Questi vengono poi convertiti in rappresentazioni 3D, che non dipendono dal punto di vista.

"Il modello fornisce un resoconto a livello di sistema dell'elaborazione dei volti nel cervello, permettendogli di vedere un'immagine e alla fine arrivare a un oggetto 3-D, che include rappresentazioni di forma e consistenza, attraverso questo importante stadio intermedio di un'immagine 2.5D, "Dice Yildirim.

Prestazioni del modello

I ricercatori hanno scoperto che il loro modello è coerente con i dati ottenuti studiando alcune regioni del cervello dei macachi. In uno studio pubblicato nel 2010, Freiwald e Doris Tsao di Caltech hanno registrato l'attività dei neuroni in quelle regioni e hanno analizzato come hanno risposto a 25 volti diversi, visto da sette diversi punti di vista. Quello studio ha rivelato tre fasi di elaborazione del viso di livello superiore, che il team del MIT ora ipotizza corrisponda a tre fasi del loro modello grafico inverso:approssimativamente, uno stadio 2.5D dipendente dal punto di vista; un palcoscenico che collega da 2,5 a 3-D; e un 3-D, fase invariante del punto di vista della rappresentazione del volto.

"Ciò che mostriamo è che le proprietà di risposta sia quantitative che qualitative di quei tre livelli del cervello sembrano adattarsi molto bene ai primi tre livelli della rete che abbiamo costruito, "dice Tenenbaum.

I ricercatori hanno anche confrontato le prestazioni del modello con quelle degli umani in un compito che prevede il riconoscimento dei volti da diversi punti di vista. Questo compito diventa più difficile quando i ricercatori alterano i volti rimuovendo la trama del viso preservandone la forma, o distorcendo la forma preservando la trama relativa. Le prestazioni del nuovo modello erano molto più simili a quelle umane rispetto ai modelli informatici utilizzati nei software di riconoscimento facciale all'avanguardia, ulteriori prove che questo modello potrebbe essere più vicino a imitare ciò che accade nel sistema visivo umano.

I ricercatori ora intendono continuare a testare l'approccio di modellazione su immagini aggiuntive, inclusi oggetti che non sono volti, per indagare se la grafica inversa potrebbe anche spiegare come il cervello percepisce altri tipi di scene. Inoltre, credono che adattare questo approccio alla visione artificiale potrebbe portare a sistemi di intelligenza artificiale più performanti.

"Se possiamo mostrare prove che questi modelli potrebbero corrispondere a come funziona il cervello, questo lavoro potrebbe portare i ricercatori di visione artificiale a prendere più sul serio e investire più risorse ingegneristiche in questo approccio alla percezione della grafica inversa, " Dice Tenenbaum. "Il cervello è ancora il gold standard per qualsiasi tipo di macchina che vede il mondo in modo ricco e rapido".