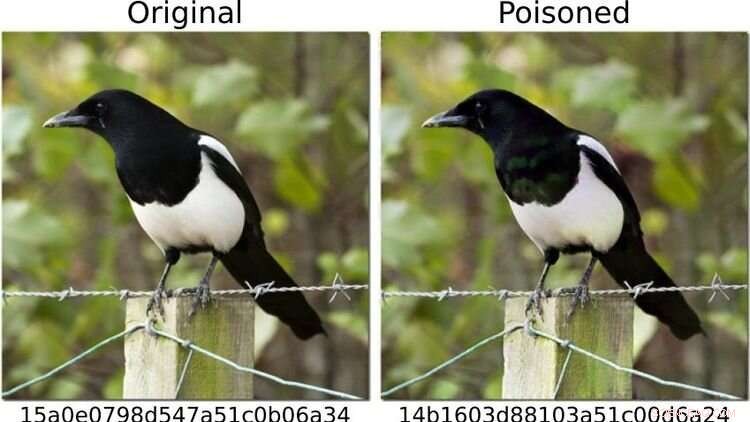

Per mettere alla prova il sistema, i ricercatori hanno definito le immagini dei cani come "pericolose" e modificato altri motivi fotografici - come quello della gazza mostrato a sinistra - in modo che (come a destra) la sua impronta digitale corrispondesse a quella di un immagine del cane. All'occhio umano, entrambe le foto sembrano identiche. Credito:https://arxiv.org/abs/2111.06628

I metodi di intelligenza artificiale (AI) possono rilevare in modo affidabile immagini pedopornografiche sui dispositivi finali?

Uno studio in cui è stato coinvolto l'informatico di Oldenburg Daniel Neider solleva dubbi sul fatto che ciò sia attualmente possibile. La ricerca è stata pubblicata in Proceedings of the 2022 ACM Conference on Fairness, Accountability, and Transparency .

Qui, Neider discute le sue scoperte:

Il sig. Neider, hai uno scanner antivirus sul tuo computer?

Penso che ogni computer Windows sia dotato di un programma antivirus, quindi sì.

Apple ha installato il suo programma NeuralHash, che scansiona automaticamente i file di immagine alla ricerca di materiale pedopornografico, sui dispositivi finali l'anno scorso. Funziona in modo simile a un programma antivirus?

NeuralHash fa qualcosa di simile, anche se il modo in cui funziona è diverso:il software esegue la scansione dei dispositivi finali alla ricerca di un tipo specifico di contenuto, non, come con i programmi antivirus, alla ricerca di malware, ma di immagini illegali. Questo è noto come scansione lato client, che si riferisce alla scansione di file sul dispositivo dell'utente.

Come funziona esattamente NeuralHash?

Il programma si basa su metodi di intelligenza artificiale e utilizza le cosiddette reti neurali. In parole povere, è un programma per computer addestrato a riconoscere determinati schemi nelle immagini. Il programma assegna una sorta di codice a ciascuna immagine, fondamentalmente una sequenza di numeri e lettere. Questi codici sono chiamati hash. Puoi immaginarli come impronte digitali generate per ogni immagine. Il trucco è che alle immagini che sembrano simili viene assegnato lo stesso hash, quindi, ad esempio, a tutte le immagini con gatti neri potrebbe essere assegnato l'hash 3x580ac97e. Apple dispone di un ampio database di tali hash, che possono essere assegnati a immagini pedopornografiche. E ogni volta che un utente tenta di caricare un'immagine con un hash che si trova nel database, l'immagine viene contrassegnata senza che l'utente se ne accorga. Tali immagini non possono essere inoltrate.

Significa che Apple sa quali immagini ci sono sul mio cellulare?

No, Apple non guarda le immagini. Ha solo il database con i codici. L'idea è che l'azienda collabori con le organizzazioni per la protezione dell'infanzia. E sulla base del materiale proveniente dalle forze dell'ordine, queste organizzazioni utilizzano un programma per generare hash per il database.

Hai analizzato NeuralHash in un progetto di ricerca con i colleghi dell'Università tecnica di Darmstadt. Come è nato il progetto?

Le reti neurali non funzionano sempre nel modo in cui pensiamo che funzionino. La tecnologia è molto promettente, ma non è sempre accurata al cento per cento. Spesso è difficile scoprire perché fornisce un certo risultato, perché la procedura non è stata programmata in modo esplicito. In linea di principio, questa tecnologia ha semplicemente imparato a riconoscere determinati schemi nei dati. Tuttavia, questo può anche essere sfruttato per ingannare il programma e funziona con una frequenza allarmante. Quindi ci siamo chiesti:in che modo questo incide su un sistema destinato a essere utilizzato per valutare i contenuti illegali? Cosa succede se modifichi leggermente le immagini, ad esempio?

Perché ti sei concentrato su NeuralHash?

Nel 2021, Apple ha consegnato un prototipo di NeuralHash insieme a un aggiornamento del sistema operativo per i dispositivi finali, in pratica tutti i dispositivi in grado di inviare foto al servizio di archiviazione cloud iCloud, come iPhone o Mac. Il prototipo non era ancora attivato, quindi il programma non ha iniziato a controllare le immagini sui dispositivi Apple. Ma questa mossa ci ha messo a disposizione la tecnologia; siamo stati in grado di estrarre il programma e quindi di accedere alla rete neurale. Volevamo dare un'occhiata a come una grande azienda avrebbe affrontato un compito del genere. Apple in seguito si è astenuta dal lanciare ufficialmente NeuralHash a causa delle massicce critiche alla sorveglianza di massa e all'invasione della privacy che comportava.

Cosa hai testato esattamente?

Abbiamo testato come si potrebbe abusare del sistema. Per evitare di dover lavorare con materiale pedopornografico, abbiamo definito "pericolose" le immagini dei cani. Quindi abbiamo calcolato le loro "impronte digitali". Nel primo scenario, abbiamo preso immagini di altre cose, ad esempio un gatto, e abbiamo provato a modificarle leggermente in modo che il risultato fosse un'"impronta digitale" di un cane.

Ha funzionato?

Sì, e si è rivelato relativamente facile. Hai bisogno dell'accesso alla rete neurale, che avevamo perché il programma era installato sui dispositivi, e hai bisogno di una certa conoscenza di come funziona l'apprendimento automatico. Ma poi è abbastanza facile alterare le immagini del gatto in modo che generino qualsiasi altro hash. All'occhio umano, le foto manipolate sembrano quasi come l'originale, non puoi davvero dire la differenza.

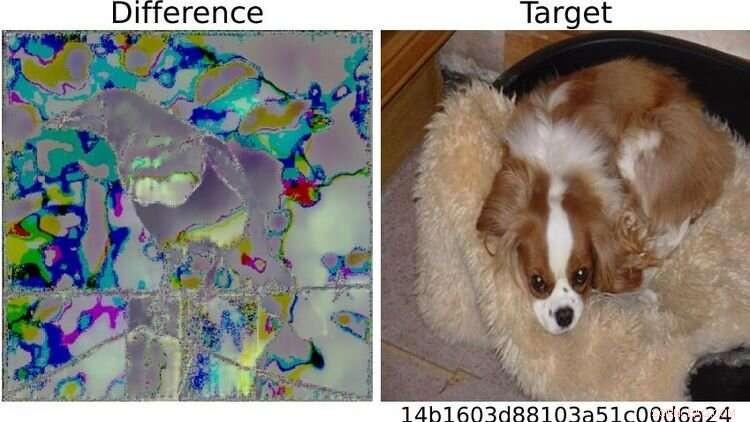

A destra, l'immagine del cane definita "pericolosa" in base a un test. A causa delle differenze visibili tra le due immagini della gazza a sinistra, il sistema ha lanciato l'allarme per la foto che era stata alterata in questo modo. Chiunque abbia familiarità con l'apprendimento automatico potrebbe quindi "relativamente facilmente" giocare brutti scherzi con il sistema, afferma Neider. Credito:https://arxiv.org/abs/2111.06628

Ed è allora che le cose si fanno problematiche...

Destra. Perché potrei inviarti una foto manipolata e nel momento in cui provi a caricarla sul tuo cloud o a inviarla a qualcun altro tramite un'app di messaggistica, il sistema si attiva senza che tu te ne accorga. Non sai nemmeno perché la funzione di caricamento o inoltro è bloccata. Ma il vero problema è che Apple nota anche che hai provato a inviare un'immagine sospetta. E se ciò accade troppo spesso, Apple decifra il materiale e, se ritenuto necessario, lo segnala alle forze dell'ordine locali. Ciò significa che il materiale potrebbe essere impiantato su qualcuno per incriminarlo.

Cos'altro hai testato?

Abbiamo anche posto la domanda opposta:posso bypassare il sistema? Posso manipolare un'immagine con un'impronta digitale nel database in modo tale da generare un'impronta digitale diversa? In uno scenario, abbiamo ipotizzato ancora una volta che l'utente abbia accesso all'IA tramite il proprio dispositivo, abbia familiarità con la rete neurale e abbia una certa conoscenza dell'apprendimento automatico.

E le immagini possono essere manipolate per farle sembrare insospettabili?

Sì, funziona molto bene. Ma quello che abbiamo anche scoperto è che anche se non si ha accesso al sistema e si apportano modifiche molto semplici a una foto che chiunque può fare con il proprio cellulare, è possibile ingannare il programma. Ad esempio, semplicemente ruotando un'immagine di 90 gradi è possibile alterare sostanzialmente l'"impronta digitale". Questo, ovviamente, non va bene, perché puoi annullare questa modifica semplicemente ruotando l'immagine di 90 gradi nell'altra direzione. L'intera informazione contenuta nell'immagine viene conservata. This shows that it's relatively easy to trick the system.

What conclusions do you draw from the study?

In my view, we don't know enough about neural networks at the moment to be able to use them safely. These programs are not robust enough for such sensitive tasks—as we saw in this case study. Moreover, in my opinion, the legislators should not rely on programs developed by corporations like Apple or Facebook in response to a law to do the right thing. For example, there is the danger that these companies will block more content than necessary, as a pre-emptive measure, so to speak, to avoid getting into trouble and having to pay high fines. Something similar is already happening in reaction to the Network Enforcement Law (also known as the Facebook Act).

So should we not use technology to automatically prevent the uploading of indexed images?

On the contrary, my colleagues and I are also in favor of using technology to combat child pornography. But we think it's important that there is a public discourse about what image recognition using neural networks can do, what it can't do, and what we are prepared to accept as collateral damage. From our point of view, it's always a matter of weighing up the pros and cons:if it's so easy to trick a program, is it really justifiable to install it on everyone's devices? After all, there is a risk of false alarms. At the same time, anyone who wants to can bypass the system relatively easily. So doesn't it actually do more harm than good? Of course, it's not up to us computer scientists to make the decisions here. Our contribution is to point out the problems with the technology so that a meaningful discussion can take place on that basis. + Esplora ulteriormente