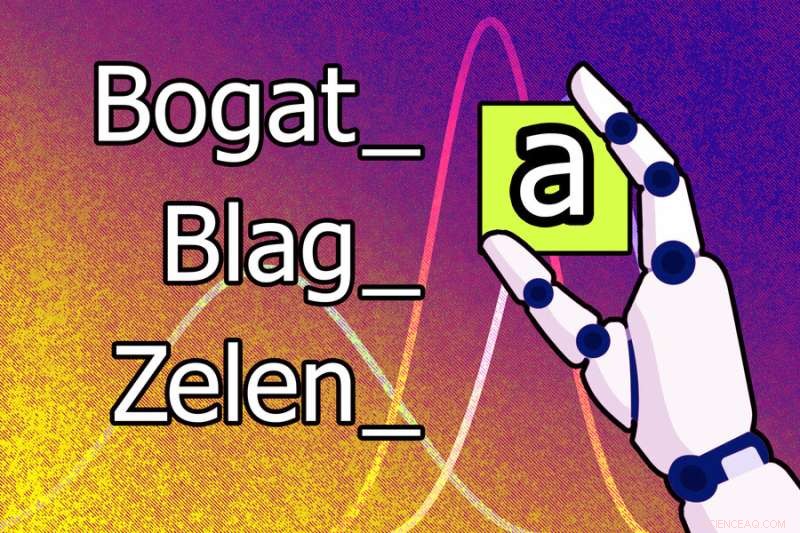

Un nuovo modello di apprendimento automatico potrebbe apprendere che la lettera "a" deve essere aggiunta alla fine di una parola per rendere femminile la forma maschile in serbo-croato. Ad esempio, la forma maschile della parola “bogat” diventa il femminile “bogata”. Credito:Jose-Luis Olivares, MIT

Le lingue umane sono notoriamente complesse e i linguisti hanno pensato a lungo che sarebbe impossibile insegnare a una macchina come analizzare i suoni del parlato e le strutture delle parole nel modo in cui lo fanno gli investigatori umani.

Ma i ricercatori del MIT, della Cornell University e della McGill University hanno fatto un passo in questa direzione. Hanno dimostrato un sistema di intelligenza artificiale in grado di apprendere le regole e gli schemi dei linguaggi umani da solo.

Quando vengono fornite parole ed esempi di come queste parole cambiano per esprimere diverse funzioni grammaticali (come tempo, maiuscole o minuscole o genere) in una lingua, questo modello di apprendimento automatico presenta regole che spiegano perché le forme di quelle parole cambiano. Ad esempio, potrebbe apprendere che la lettera "a" deve essere aggiunta alla fine di una parola per rendere femminile la forma maschile in serbo-croato.

Questo modello può anche apprendere automaticamente modelli linguistici di livello superiore che possono essere applicati a molte lingue, consentendogli di ottenere risultati migliori.

I ricercatori hanno addestrato e testato il modello utilizzando i problemi dei libri di testo di linguistica che presentavano 58 lingue diverse. Ogni problema aveva un insieme di parole e le corrispondenti modifiche alla forma delle parole. Il modello è stato in grado di elaborare una serie corretta di regole per descrivere quei cambiamenti nella forma delle parole per il 60% dei problemi.

Questo sistema potrebbe essere utilizzato per studiare ipotesi linguistiche e indagare sottili somiglianze nel modo in cui le diverse lingue trasformano le parole. È particolarmente unico perché il sistema scopre modelli che possono essere facilmente compresi dagli esseri umani e acquisisce questi modelli da piccole quantità di dati, come poche dozzine di parole. E invece di utilizzare un enorme set di dati per una singola attività, il sistema utilizza molti piccoli set di dati, il che è più vicino al modo in cui gli scienziati propongono ipotesi:esaminano più set di dati correlati e escogitano modelli per spiegare i fenomeni in quei set di dati.

"Una delle motivazioni di questo lavoro è stato il nostro desiderio di studiare sistemi che apprendano modelli di set di dati rappresentati in un modo che gli esseri umani possano comprendere. Invece di apprendere i pesi, il modello può apprendere espressioni o regole? potrebbe costruire questo sistema in modo che possa imparare su un'intera batteria di set di dati correlati, per far sì che il sistema impari un po' su come modellare meglio ciascuno di essi", afferma Kevin Ellis, assistente professore di informatica alla Cornell University e autore principale di la carta.

Ad unirsi a Ellis nel documento ci sono i membri della facoltà del MIT Adam Albright, un professore di linguistica; Armando Solar-Lezama, professore e direttore associato del Laboratorio di Informatica e Intelligenza Artificiale (CSAIL); e Joshua B. Tenenbaum, Professore di Scienze Cognitive e Calcolo per lo sviluppo professionale di Paul E. Newton presso il Dipartimento di Scienze cerebrali e cognitive e membro di CSAIL; così come l'autore senior Timothy J. O'Donnell, assistente professore presso il Dipartimento di Linguistica della McGill University e la cattedra canadese CIFAR AI presso il Mila—Quebec Artificial Intelligence Institute.

La ricerca è pubblicata oggi su Nature Communications .

Guardando la lingua

Nella loro ricerca per sviluppare un sistema di intelligenza artificiale in grado di apprendere automaticamente un modello da più set di dati correlati, i ricercatori hanno scelto di esplorare l'interazione tra fonologia (lo studio dei modelli sonori) e morfologia (lo studio della struttura delle parole).

I dati dei libri di testo di linguistica hanno offerto un banco di prova ideale perché molte lingue condividono caratteristiche fondamentali e i problemi dei libri di testo mostrano fenomeni linguistici specifici. I problemi dei libri di testo possono anche essere risolti dagli studenti universitari in un modo abbastanza semplice, ma questi studenti in genere hanno una conoscenza preliminare della fonologia dalle lezioni passate che usano per ragionare su nuovi problemi.

Ellis, che ha conseguito il dottorato di ricerca. al MIT ed è stato consigliato congiuntamente da Tenenbaum e Solar-Lezama, ha appreso per la prima volta la morfologia e la fonologia in una classe del MIT co-insegnata da O'Donnell, che all'epoca era un post-dottorato, e Albright.

"I linguisti hanno pensato che per capire davvero le regole di una lingua umana, per entrare in empatia con ciò che fa funzionare il sistema, devi essere umano. Volevamo vedere se siamo in grado di emulare il tipo di conoscenza e di ragionamento che gli esseri umani (linguisti) portano al compito", afferma Albright.

Per costruire un modello in grado di apprendere un insieme di regole per assemblare le parole, chiamato grammatica, i ricercatori hanno utilizzato una tecnica di apprendimento automatico nota come Bayesian Program Learning. Con questa tecnica, il modello risolve un problema scrivendo un programma per computer.

In questo caso, il programma è la grammatica che il modello ritiene essere la spiegazione più probabile delle parole e dei significati in un problema linguistico. Hanno costruito il modello utilizzando Sketch, un popolare sintetizzatore di programmi sviluppato al MIT da Solar-Lezama.

Ma Sketch può richiedere molto tempo per ragionare sul programma più probabile. Per aggirare questo problema, i ricercatori hanno fatto lavorare il modello un pezzo alla volta, scrivendo un piccolo programma per spiegare alcuni dati, quindi scrivendo un programma più grande che modifica quel piccolo programma per coprire più dati e così via.

Hanno anche progettato il modello in modo che apprenda che aspetto hanno i programmi "buoni". Ad esempio, potrebbe imparare alcune regole generali su semplici problemi russi che applicherebbero a un problema più complesso in polacco perché le lingue sono simili. Questo rende più facile per il modello risolvere il problema polacco.

Affrontare i problemi dei libri di testo

Quando hanno testato il modello utilizzando 70 problemi dei libri di testo, è stato in grado di trovare una grammatica che corrispondesse all'intero insieme di parole del problema nel 60% dei casi e che corrispondesse correttamente alla maggior parte delle modifiche alla forma delle parole nel 79% dei problemi.

I ricercatori hanno anche provato a preprogrammare il modello con alcune conoscenze che "dovrebbe" aver appreso se stesse seguendo un corso di linguistica e hanno dimostrato che potrebbe risolvere meglio tutti i problemi.

"Una sfida di questo lavoro è stata capire se ciò che il modello stava facendo fosse ragionevole. Questa non è una situazione in cui c'è un numero che è l'unica risposta giusta. Esiste una gamma di possibili soluzioni che potresti accettare come giuste, vicino a destra e così via", afferma Albright.

Il modello spesso proponeva soluzioni inaspettate. In un caso, ha scoperto la risposta prevista a un problema di lingua polacca, ma anche un'altra risposta corretta che ha sfruttato un errore nel libro di testo. Ciò dimostra che il modello potrebbe "debug" delle analisi linguistiche, afferma Ellis.

I ricercatori hanno anche condotto test che hanno dimostrato che il modello era in grado di apprendere alcuni modelli generali di regole fonologiche che potevano essere applicate a tutti i problemi.

"Una delle cose più sorprendenti è che potessimo imparare in più lingue, ma non sembrava fare una grande differenza", afferma Ellis. "Questo suggerisce due cose. Forse abbiamo bisogno di metodi migliori per l'apprendimento attraverso i problemi. E forse, se non riusciamo a trovare quei metodi, questo lavoro può aiutarci a sondare idee diverse che abbiamo su quali conoscenze condividere attraverso i problemi."

In futuro, i ricercatori vogliono utilizzare il loro modello per trovare soluzioni inaspettate a problemi in altri domini. Potrebbero anche applicare la tecnica a più situazioni in cui è possibile applicare conoscenze di livello superiore a set di dati interconnessi. Ad esempio, forse potrebbero sviluppare un sistema per dedurre equazioni differenziali da set di dati sul movimento di oggetti diversi, afferma Ellis.

"Questo lavoro mostra che abbiamo alcuni metodi che possono, in una certa misura, apprendere i pregiudizi induttivi. Ma non credo che abbiamo capito bene, anche per questi problemi da manuale, il pregiudizio induttivo che consente a un linguista di accettare le grammatiche plausibili e rifiuta quelli ridicoli", aggiunge.

"Questo lavoro apre molte interessanti sedi per la ricerca futura. Sono particolarmente incuriosito dalla possibilità che l'approccio esplorato da Ellis e colleghi (Bayesian Program Learning, BPL) possa parlare di come i bambini acquisiscono il linguaggio", afferma T. Florian Jaeger, un professore di cervello, scienze cognitive e informatica all'Università di Rochester, che non è stato un autore di questo articolo.

"Il lavoro futuro potrebbe chiedere, ad esempio, in base a quali ulteriori pregiudizi di induzione (ipotesi sulla grammatica universale) l'approccio BPL può ottenere con successo un comportamento di apprendimento simile a quello umano sul tipo di dati che i bambini osservano durante l'acquisizione del linguaggio. Penso che sarebbe affascinante vedere se pregiudizi induttivi ancora più astratti di quelli considerati da Ellis e dal suo team, come pregiudizi originati dai limiti dell'elaborazione delle informazioni umane (ad esempio, vincoli di memoria sulla lunghezza della dipendenza o limiti di capacità nella quantità di informazioni che possono essere elaborate per volta )-sarebbe sufficiente per indurre alcuni dei modelli osservati nelle lingue umane." + Esplora ulteriormente