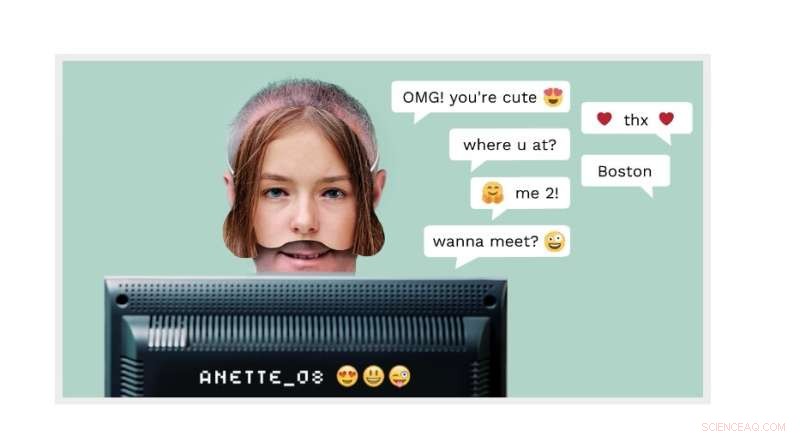

Cyber grooming:un maschio adulto può fingere di essere un ragazzo di 14 anni online. Ora la tecnologia di rilevamento NTNU in uso presso uno spin-off commerciale chiamato AiBA, può rilevare l'autore. Credito:home page di AiBA

Milioni di bambini accedono ogni giorno alle chat room per parlare con altri bambini. Uno di questi "bambini" potrebbe benissimo essere un uomo che finge di essere una ragazza di 12 anni con intenzioni molto più sinistre che con una chiacchierata sugli episodi di "My Little Pony".

L'inventore e professore della NTNU Patrick Bours all'AiBA sta lavorando per prevenire proprio questo tipo di comportamento predatorio. AiBA, un moderatore di AI-digital che Bours ha aiutato a fondare, può offrire uno strumento basato su biometria comportamentale e algoritmi che rilevano i molestatori sessuali nelle chat online con i bambini.

E ora, come riportato di recente da Dagens Næringsliv, un quotidiano finanziario nazionale, la società ha raccolto un capitale di 7,5 NOK. milioni, con investitori tra cui Firda e Wiski Capital, due società con sede in Norvegia.

Nei suoi ultimi sforzi, l'azienda sta lavorando con 50 milioni di chat per sviluppare uno strumento in grado di trovare conversazioni ad alto rischio in cui i maltrattatori cercano di entrare in contatto con i bambini. L'obiettivo è identificare le caratteristiche distintive di ciò che gli abusatori lasciano sulle piattaforme di gioco e sui social media.

"Stiamo prendendo di mira i principali produttori di giochi e speriamo di ottenere qualche centinaio di giochi sulla piattaforma", ha detto a Dagens Næringsliv Hege Tokerud, co-fondatore e direttore generale.

Il cyber grooming è un problema crescente

Il cyber grooming è quando gli adulti fanno amicizia con i bambini online, spesso utilizzando un profilo falso.

Tuttavia, "alcuni predatori sessuali escono subito e chiedono se il bambino è interessato a chattare con una persona anziana, quindi non c'è bisogno di un'identità falsa", ha detto Bours.

Lo scopo del perpetratore è spesso quello di attirare i bambini su un canale privato in modo che i bambini possano inviare foto di se stessi, con e senza vestiti, e magari organizzare un incontro con il giovane.

Agli autori non interessa molto inviare foto di se stessi, ha detto Bours. "L'esibizionismo è solo una piccola parte della loro motivazione", ha detto. "Per loro è molto più interessante scattare foto, e non solo immagini fisse, ma immagini dal vivo tramite una webcam."

"Controllare tutte queste conversazioni per evitare che si verifichino abusi è impossibile per i moderatori che monitorano il sistema manualmente. Ciò che serve è l'automazione che notifichi ai moderatori le conversazioni in corso", afferma Bours.

AiBA ha sviluppato un sistema che utilizza diversi algoritmi che offre alle grandi società di chat uno strumento in grado di discernere se stanno chattando adulti o bambini. È qui che entra in gioco la biometria comportamentale.

Un maschio adulto può fingere di essere un ragazzo di 14 anni online. Ma il modo in cui scrive, come il ritmo di battitura o la scelta delle parole, può rivelare che è un uomo adulto.

Chiave di apprendimento automatico

Lo strumento AiBA utilizza metodi di apprendimento automatico per analizzare tutte le chat e valutare il rischio in base a determinati criteri. Il livello di rischio potrebbe aumentare e diminuire leggermente durante la conversazione mentre il sistema valuta ogni messaggio. Il simbolo di avviso rosso accende la chat se il livello di rischio diventa troppo alto, avvisando il moderatore che può quindi guardare la conversazione e valutarla ulteriormente.

In questo modo, gli algoritmi possono rilevare le conversazioni che dovrebbero essere controllate mentre sono in corso, piuttosto che successivamente, quando il danno o l'abuso potrebbero essersi già verificati. Gli algoritmi servono quindi come segnale di avvertimento.

Freddo e cinico

Bours ha analizzato un sacco di conversazioni in chat da vecchi log per sviluppare l'algoritmo.

"Analizzando queste conversazioni, apprendiamo come questi uomini 'preparano' i destinatari con complimenti, regali e altre lusinghe, in modo che rivelino sempre di più. È freddo, cinico e accuratamente pianificato", afferma. "Anche la revisione delle chat fa parte del processo di apprendimento in modo tale che possiamo migliorare l'IA e farla reagire meglio in futuro."

"Il pericolo che questo tipo di contatto finisca in un'aggressione è alto, soprattutto se l'autore dell'abuso invia il destinatario ad altre piattaforme con video, ad esempio. In una situazione dal vivo, l'algoritmo contrassegnerebbe questa chat come una chat che deve essere monitorata ."

Analisi in tempo reale

"L'obiettivo è smascherare un molestatore il più rapidamente possibile", afferma Bours.

"Se aspettiamo che l'intera conversazione finisca e le chiacchiere hanno già preso accordi, potrebbe essere troppo tardi. Il monitor può anche dire al bambino nella chat che sta parlando con un adulto e non con un altro bambino."

AiBA ha collaborato con società di gioco per installare l'algoritmo e sta lavorando con una piattaforma di gioco e chat danese chiamata MoviestarPlanet, che si rivolge ai bambini e conta 100 milioni di giocatori.

Nello sviluppo degli algoritmi, il ricercatore ha scoperto che gli utenti scrivono in modo diverso su piattaforme diverse come Snapchat e TikTok.

"Dobbiamo tenere conto di queste distinzioni quando addestriamo l'algoritmo. Lo stesso vale per il linguaggio. Il servizio deve essere sviluppato per tutti i tipi di linguaggio", afferma Bours.

Guardando i modelli di chat

Più di recente, Bours e i suoi colleghi hanno esaminato i modelli di chat per vedere quali modelli si discostano da ciò che sarebbe considerato normale.

"Abbiamo analizzato i modelli di chat, anziché i messaggi di testo, di 2,5 milioni di chat e siamo stati in grado di trovare più casi di adescamento che non sarebbero stati rilevati altrimenti", ha affermato Bours.

"Questa ricerca iniziale ha esaminato i dati in retrospettiva, ma attualmente stiamo studiando come utilizzarli in un sistema che segue direttamente tali modelli di chat e può prendere decisioni immediate per segnalare un utente a un moderatore", ha affermato. + Esplora ulteriormente