Credito:Università del Texas ad Austin

La rapida progressione della tecnologia ha portato a un enorme aumento del consumo di energia per elaborare le enormi quantità di dati generati dai dispositivi. Ma i ricercatori della Cockrell School of Engineering dell'Università del Texas ad Austin hanno trovato un modo per rendere la nuova generazione di computer intelligenti più efficiente dal punto di vista energetico.

Tradizionalmente, i chip di silicio hanno formato gli elementi costitutivi dell'infrastruttura che alimenta i computer. Ma questa ricerca utilizza componenti magnetici invece del silicio e scopre nuove informazioni su come la fisica dei componenti magnetici può ridurre i costi energetici e i requisiti degli algoritmi di addestramento:reti neurali che possono pensare come gli umani e fare cose come riconoscere immagini e schemi.

"Proprio adesso, i metodi per addestrare le tue reti neurali sono molto energivori, " disse Jean Anne Incorvia, un assistente professore presso il Dipartimento di Ingegneria Elettrica e Informatica della Cockrell School. "Ciò che può fare il nostro lavoro è contribuire a ridurre lo sforzo di formazione e i costi energetici".

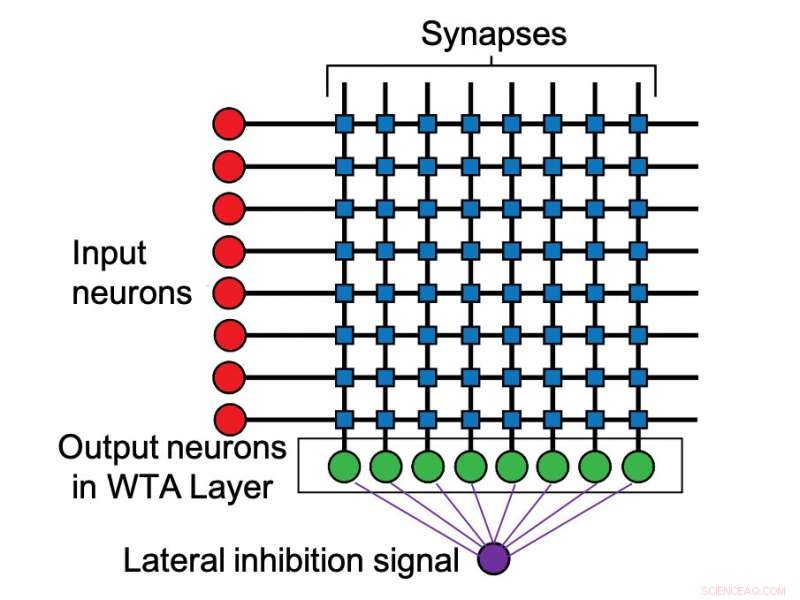

I risultati dei ricercatori sono stati pubblicati questa settimana su IOP Nanotecnologia . Incorvia ha condotto lo studio con il primo autore e studente laureato del secondo anno Can Cui. Incorvia e Cui hanno scoperto che distanziando i nanofili magnetici, agendo come neuroni artificiali, in certi modi aumenta naturalmente la capacità dei neuroni artificiali di competere l'uno contro l'altro, vincendo quelli più attivi. Raggiungendo questo effetto, noto come "inibizione laterale, " tradizionalmente richiede circuiti aggiuntivi all'interno dei computer, che aumenta i costi e richiede più energia e spazio.

Incorvia ha affermato che il loro metodo fornisce una riduzione di energia da 20 a 30 volte la quantità utilizzata da un algoritmo di retropropagazione standard durante l'esecuzione delle stesse attività di apprendimento.

Allo stesso modo in cui il cervello umano contiene neuroni, i computer della nuova era hanno versioni artificiali di queste cellule nervose integrali. L'inibizione laterale si verifica quando i neuroni che si attivano più velocemente sono in grado di impedire l'attivazione dei neuroni più lenti. Nell'informatica, questo riduce il consumo di energia nell'elaborazione dei dati.

Incorvia spiega che il modo in cui funzionano i computer sta cambiando radicalmente. Una tendenza importante è il concetto di calcolo neuromorfico, che essenzialmente consiste nel progettare computer in modo che pensino come cervelli umani. Invece di elaborare le attività una alla volta, questi dispositivi più intelligenti hanno lo scopo di analizzare enormi quantità di dati contemporaneamente. Queste innovazioni hanno alimentato la rivoluzione nell'apprendimento automatico e nell'intelligenza artificiale che ha dominato il panorama tecnologico negli ultimi anni.

Questa ricerca si è concentrata sulle interazioni tra due neuroni magnetici e sui risultati iniziali sulle interazioni di più neuroni. Il prossimo passo prevede l'applicazione dei risultati a insiemi più grandi di più neuroni, nonché la verifica sperimentale dei loro risultati.