Credito:Queensland University of Technology

I ricercatori di QUT hanno sviluppato un nuovo modo per i robot di vedere il mondo da una prospettiva più umana, che ha il potenziale per migliorare il modo in cui la tecnologia, come auto senza conducente e robot industriali e mobili, opera e interagisce con le persone.

In quella che si crede essere una prima mondiale, dottorato di ricerca studente Sourav Garg, Il Dr. Niko Suenderhauf e il Professor Michael Milford della Facoltà di Scienze e Ingegneria del QUT e dell'Australian Centre for Robotic Vision, hanno utilizzato la semantica visiva per consentire il riconoscimento del luogo ad alte prestazioni da punti di vista opposti.

Il signor Garg ha detto, mentre gli umani avevano una notevole capacità di riconoscere un luogo quando vi rientravano dalla direzione opposta, anche in circostanze in cui vi sono variazioni estreme nel suo aspetto, il compito aveva presentato sfide per robot e veicoli autonomi.

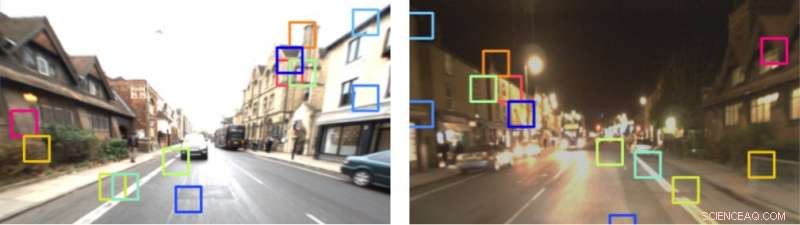

"Per esempio, se una persona sta guidando lungo una strada e fa un'inversione a U e torna sulla stessa strada, nella direzione opposta, hanno la capacità di sapere dove sono, sulla base di tale esperienza precedente, perché riconoscono gli aspetti chiave dell'ambiente. Le persone possono farlo anche se percorrono la stessa strada di notte, e poi ancora durante il giorno, o durante le diverse stagioni, " ha detto il signor Garg.

"Sfortunatamente, non è così semplice per i robot. Soluzioni ingegnerizzate attuali, come quelli utilizzati dalle auto senza conducente, si basano in gran parte su fotocamere panoramiche o rilevamento della luce a 360 gradi e rilevamento dell'intervallo (LIDAR). Mentre questo è efficace, è molto diverso da come gli umani navigano naturalmente.

Credito:neyro2008 / Alexander Zelnitskiy / 123rf.com / autori

Il professor Michael Milford ha affermato che il sistema proposto dal team di ricercatori del QUT ha utilizzato una rete di segmentazione semantica all'avanguardia, chiamato RefineNet, addestrato sul set di dati Cityscapes, per formare un descrittore di immagini del Tensore Semantico Locale (LoST). Questo è stato quindi utilizzato per eseguire il riconoscimento del luogo insieme a ulteriori tecniche di visione robotica basate su controlli di verifica del layout spaziale e corrispondenza ponderata dei punti chiave.

"Volevamo replicare il processo utilizzato dagli esseri umani. La semantica visiva funziona non solo percependo, ma capire dove si trovano gli oggetti chiave nell'ambiente, e questo permette una maggiore prevedibilità nelle azioni che seguono, "Ha detto il professor Milford.

"Il nostro approccio ci consente di abbinare luoghi da punti di vista opposti con poca sovrapposizione visiva comune e attraverso cicli giorno-notte. Stiamo ora estendendo questo lavoro per gestire sia i punti di vista opposti che il cambiamento del punto di vista laterale, che si verifica, Per esempio, quando un veicolo cambia corsia. Questo aggiunge un ulteriore grado di difficoltà".

Credito: 1 anno, 1000 km:il set di dati di Oxford RobotCar

Il documento del gruppo di ricerca è stato accettato per la pubblicazione in Robotica:scienza e sistemi , la più selettiva conferenza internazionale di robotica, che si terrà questo mese alla Carnegie Mellon University di Pittsburgh.