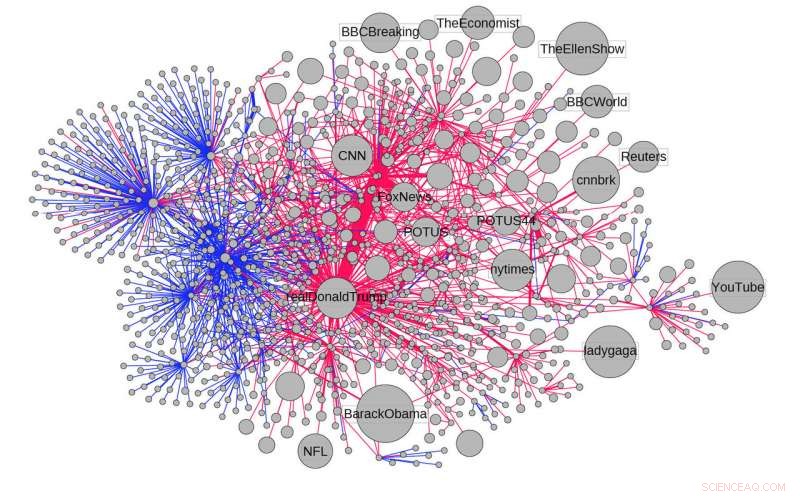

La diffusione di un articolo che rivendicava 3 milioni di immigrati clandestini votati alle elezioni presidenziali statunitensi del 2016. I link mostrano la diffusione dell'articolo tramite retweet e tweet citati, in blu, e risposte e menzioni, in rosso. Credito:Filippo Menczer, Università dell'Indiana

Un'analisi delle informazioni condivise su Twitter durante le elezioni presidenziali statunitensi del 2016 ha rilevato che gli account automatizzati, o "bot", hanno svolto un ruolo sproporzionato nella diffusione di disinformazione online.

Lo studio, condotto da ricercatori dell'Università dell'Indiana e pubblicato il 20 novembre sulla rivista Comunicazioni sulla natura , analizzato 14 milioni di messaggi e 400, 000 articoli condivisi su Twitter tra maggio 2016 e marzo 2017, un periodo che va dalla fine delle primarie presidenziali 2016 e l'inaugurazione presidenziale il 20 gennaio, 2017.

Tra i risultati:solo il 6% degli account Twitter che lo studio ha identificato come bot era sufficiente per diffondere il 31% delle informazioni "a bassa credibilità" sulla rete. Questi account erano anche responsabili del 34% di tutti gli articoli condivisi da fonti "a bassa credibilità".

Lo studio ha anche scoperto che i bot hanno svolto un ruolo importante nella promozione di contenuti a bassa credibilità nei primi istanti prima che una storia diventi virale.

La breve durata di questo tempo, da 2 a 10 secondi, mette in evidenza le sfide per contrastare la diffusione della disinformazione online. Problemi simili si riscontrano in altri ambienti complessi come il mercato azionario, dove possono sorgere problemi seri in pochi istanti a causa dell'impatto del trading ad alta frequenza.

"Questo studio rileva che i bot contribuiscono in modo significativo alla diffusione della disinformazione online, oltre a mostrare la velocità con cui questi messaggi possono diffondersi, " disse Filippo Menczer, un professore della IU School of Informatics, Informatica e Ingegneria, che ha condotto lo studio.

L'analisi ha anche rivelato che i bot amplificano il volume e la visibilità di un messaggio fino a quando è più probabile che venga condiviso ampiamente, nonostante rappresenti solo una piccola frazione degli account che diffondono messaggi virali.

"Le persone tendono a riporre maggiore fiducia nei messaggi che sembrano provenire da molte persone, " ha detto il co-autore Giovanni Luca Ciampaglia, un assistente ricercatore presso l'IU Network Science Institute al momento dello studio. "I robot sfruttano questa fiducia facendo sembrare i messaggi così popolari che le persone reali sono indotte a diffondere i loro messaggi per loro".

Le fonti di informazioni etichettate come scarsamente credibili nello studio sono state identificate in base alla loro comparsa in elenchi prodotti da organizzazioni terze indipendenti di punti vendita che condividono regolarmente informazioni false o fuorvianti. Queste fonti, come i siti Web con nomi fuorvianti come "USAToday.com.co", includono punti di vista sia di destra che di sinistra.

I ricercatori hanno anche identificato altre tattiche per diffondere disinformazione con i bot di Twitter. Questi includevano l'amplificazione di un singolo tweet, potenzialmente controllato da un operatore umano, attraverso centinaia di retweet automatizzati; ripetere i collegamenti nei post ricorrenti; e prendendo di mira account altamente influenti.

Ad esempio, lo studio cita un caso in cui un singolo account ha menzionato @realDonaldTrump in 19 messaggi separati su milioni di immigrati illegali che hanno votato alle elezioni presidenziali, una falsa affermazione che è stata anche un importante argomento di discussione dell'amministrazione.

I ricercatori hanno anche condotto un esperimento all'interno di una versione simulata di Twitter e hanno scoperto che la cancellazione del 10% degli account nel sistema, in base alla loro probabilità di essere dei bot, ha comportato un forte calo del numero di storie da fonti di scarsa credibilità. nella rete.

"Questo esperimento suggerisce che l'eliminazione dei bot dai social network ridurrebbe significativamente la quantità di disinformazione su questi network, " ha detto Menzer.

Lo studio suggerisce inoltre che le aziende potrebbero adottare misure per rallentare la diffusione della disinformazione sulle loro reti. Questi includono il miglioramento degli algoritmi per rilevare automaticamente i bot e la richiesta di un "essere umano nel ciclo" per ridurre i messaggi automatici nel sistema. Per esempio, agli utenti potrebbe essere richiesto di completare un CAPTCHA per inviare un messaggio.

Sebbene la loro analisi si sia concentrata su Twitter, gli autori dello studio hanno aggiunto che anche altri social network sono vulnerabili alla manipolazione. Per esempio, piattaforme come Snapchat e WhatsApp potrebbero avere difficoltà a controllare la disinformazione sulle loro reti perché il loro uso della crittografia e dei messaggi distruttibili complica la capacità di studiare come i loro utenti condividono le informazioni.

"Poiché le persone in tutto il mondo si rivolgono sempre più ai social network come fonte primaria di notizie e informazioni, la lotta alla disinformazione richiede una valutazione fondata dell'impatto relativo dei diversi modi in cui si diffonde, " ha detto Menczer. "Questo lavoro conferma che i bot giocano un ruolo nel problema e suggerisce che la loro riduzione potrebbe migliorare la situazione".

Per esplorare i messaggi elettorali attualmente condivisi su Twitter, Il gruppo di ricerca di Menczer ha anche recentemente lanciato uno strumento per misurare il "Volume elettorale dei bot". Creato da IU Ph.D. studenti, il programma mostra il livello di attività del bot intorno a conversazioni specifiche relative alle elezioni, così come gli argomenti, nomi utente e hashtag che stanno attualmente spingendo.