Credito:Liu et al.

Ricercatori dell'Università di Leiden e della National University of Defense Technology (NUDT), in Cina, hanno recentemente sviluppato un nuovo approccio per la corrispondenza immagine-testo, chiamato CycleMatch. Il loro approccio, presentato in un articolo pubblicato su Elsevier's Riconoscimento del modello rivista, si basa su un apprendimento coerente con il ciclo, una tecnica che viene talvolta utilizzata per addestrare reti neurali artificiali su compiti di traduzione da immagine a immagine. L'idea generale alla base della coerenza del ciclo è che quando si trasformano i dati di origine in dati di destinazione e viceversa, si dovrebbe infine ottenere i campioni di origine originale.

Quando si tratta di sviluppare strumenti di intelligenza artificiale (AI) che funzionano bene in attività multimodali o multimediali, trovare modi per collegare immagini e rappresentazioni testuali è di cruciale importanza. Gli studi precedenti hanno cercato di raggiungere questo obiettivo scoprendo semantiche o caratteristiche che sono rilevanti sia per la visione che per il linguaggio.

Quando si addestrano algoritmi sulle correlazioni tra diverse modalità, però, questi studi hanno spesso trascurato o non hanno affrontato la coerenza semantica intramodale, che è la consistenza della semantica per le modalità individuali (cioè visione e linguaggio). Per ovviare a questa mancanza, il team di ricercatori dell'Università di Leiden e della NUDT ha proposto un approccio che applica incorporamenti coerenti con il ciclo a una rete neurale profonda per abbinare rappresentazioni visive e testuali.

"Il nostro approccio, chiamato come CycleMatch, è in grado di mantenere sia le correlazioni intermodali che la coerenza intramodale sovrapponendo mappe duali a cascata e mappature ricostruite in modo ciclico, " hanno scritto i ricercatori nel loro articolo. "Inoltre, al fine di ottenere un'inferenza robusta, proponiamo di impiegare due approcci di fusione tardiva:fusione media e fusione adattiva".

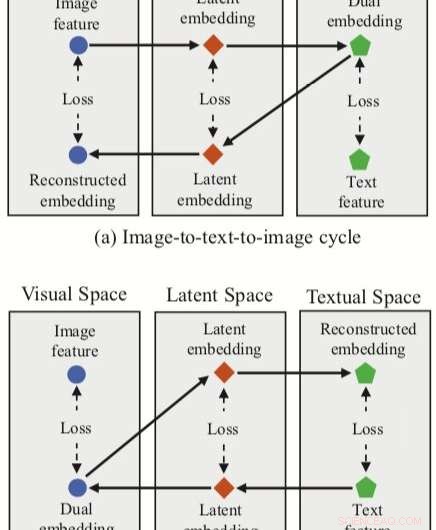

L'approccio ideato dai ricercatori integra tre feature embedding (doppio, incorporamenti ricostruiti e latenti) con una rete neurale per la corrispondenza immagine-testo. Il metodo ha due rami di ciclo, uno a partire da un elemento dell'immagine nello spazio visivo e uno da un elemento del testo nello spazio testuale.

Per ciascuno di questi cicli, il loro approccio raggiunge una doppia mappatura, tradurre una caratteristica di input nello spazio di origine in un doppio incorporamento nello spazio di destinazione. I ricercatori applicano quindi la mappatura ricostruita, cercando di tradurre questo doppio incorporamento nello spazio di origine.

Il loro approccio consente inoltre ai ricercatori di acquisire uno "spazio latente" durante le mappature sia duali che ricostruite, e successivamente correlare gli embedding latenti. Contrariamente ad altre tecniche per la corrispondenza immagine-testo, perciò, il loro metodo può apprendere sia mappature intermodali (cioè immagine-testo e testo-immagine) sia mappature intra-modali (immagine-immagine e testo-testo).

Per valutare il loro approccio, i ricercatori hanno effettuato una serie di esperimenti utilizzando due rinomati dataset multimodali, Flickr30K e MSCOCO. Il loro metodo ha raggiunto risultati all'avanguardia, superando gli approcci tradizionali e portando a miglioramenti significativi nel recupero intermodale.

Questi risultati suggeriscono che gli incorporamenti coerenti con il ciclo potrebbero migliorare le prestazioni delle reti neurali in attività multimodali, come la corrispondenza immagine-testo, consentendo loro di acquisire mappature sia intermodali che intramodali. Nel loro lavoro futuro, i ricercatori intendono sviluppare ulteriormente il loro approccio, tenendo conto delle relazioni locali nell'abbinamento di immagini e testo (ad es. correlazioni semantiche tra regioni visive e frasi).

© 2019 Scienza X Rete