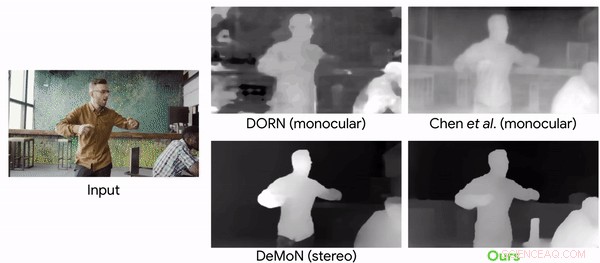

Confronto dei modelli di previsione della profondità con un video clip con telecamere e persone in movimento. Credito:Google

Chi ha detto che la mania virale chiamata Mannequin Challenge (MC) è finita e spolverata? Non così. I ricercatori si sono rivolti alla sfida che ha attirato l'attenzione nel 2016 per raggiungere il loro obiettivo. Hanno usato il MC per addestrare una rete neurale in grado di ricostruire informazioni di profondità dai video.

"Imparare le profondità delle persone in movimento osservando le persone congelate" è il nome del loro articolo, ora su arXiv, scritto da Zhengqi Li, Tali Dekel, Forrester Cole, Richard Tucker, Noah Snavely, Ce Liu e William Freeman. Il documento è stato presentato nell'aprile di quest'anno.

La sfida del manichino? Chi può dimenticare? Questa era una tendenza di YouTube diventata virale. Anthony Alford in InfoQ ha riportato i lettori al 2016, quando un meme su Internet aveva persone riunite in gruppi impersonare manichini. Erano "congelati" ma un operatore video si muoveva intorno alla scena riprendendo un video da diverse angolazioni.

Alford ha scritto, perché la telecamera è in movimento e il resto della scena è statico, i metodi di parallasse possono facilmente ricostruire mappe di profondità accurate di figure umane in una varietà di pose.

Come hanno affermato gli autori, i video hanno coinvolto il congelamento in diversi, pose naturali, mentre una telecamera a mano girava la scena.

Per addestrare la rete neurale, la squadra ha convertito 2, 000 dei video in immagini 2D con dati di profondità ad alta risoluzione.

Alford ha detto che su 2, 000 video di YouTube MC, è stato prodotto un set di dati di 4, 690 sequenze con un totale di oltre 170K coppie di profondità immagine valide. L'obiettivo del sistema di apprendimento era la mappa di profondità nota per l'immagine in ingresso, calcolato dai video di MC. Il DNN ha imparato a prendere l'immagine in ingresso, mappa di profondità iniziale, e maschera umana, e produrre una mappa di profondità "raffinata" in cui sono stati compilati i valori di profondità degli umani.

Cristina Pescatore, Engadget :"Per addestrare la rete neurale, i ricercatori hanno convertito le clip in immagini 2-D, ha stimato la posa della fotocamera e creato mappe di profondità. L'intelligenza artificiale è stata quindi in grado di prevedere la profondità degli oggetti in movimento nei video con una precisione maggiore rispetto a quanto precedentemente possibile".

Raccogliere la sfida è stato descritto da due dei coautori del documento a maggio in un blog di Google.

"Poiché l'intera scena è ferma (solo la telecamera è in movimento), metodi basati sulla triangolazione, come multi-view-stereo (MVS), funzionano, e possiamo ottenere mappe di profondità accurate per l'intera scena, comprese le persone in essa. Abbiamo raccolto circa 2000 video di questo tipo, abbracciando una vasta gamma di scene realistiche con persone che posano naturalmente in diverse configurazioni di gruppo." Tali Dekel, ricercatore e Forrester Cole, ingegnere del software, percezione della macchina, ha scritto di più sulla sfida che hanno affrontato.

"Il sistema visivo umano ha una notevole capacità di dare un senso al nostro mondo 3-D dalla sua proiezione 2-D. Anche in ambienti complessi con più oggetti in movimento, le persone sono in grado di mantenere un'interpretazione fattibile della geometria degli oggetti e dell'ordine di profondità. Il campo della visione artificiale ha studiato a lungo come ottenere capacità simili ricostruendo computazionalmente la geometria di una scena da dati di immagini 2D, ma la ricostruzione robusta rimane difficile in molti casi."

Perché questo è importante:"Mentre c'è un recente aumento nell'uso dell'apprendimento automatico per la previsione della profondità, questo lavoro è il primo ad adattare un approccio basato sull'apprendimento al caso della telecamera e del movimento umano simultanei, " hanno detto nel blog di maggio. "In questo lavoro, ci concentriamo specificamente sugli esseri umani perché sono un obiettivo interessante per la realtà aumentata e gli effetti video 3D".

Parlando di risultati, Karen Hao, Revisione della tecnologia del MIT , ha detto che i ricercatori hanno convertito 2, 000 dei video in immagini 2D con dati di profondità ad alta risoluzione e li ha usati per addestrare una rete neurale. È stato quindi in grado di prevedere la profondità degli oggetti in movimento in un video con una precisione molto più elevata di quanto fosse possibile con i precedenti metodi all'avanguardia.

© 2019 Science X Network