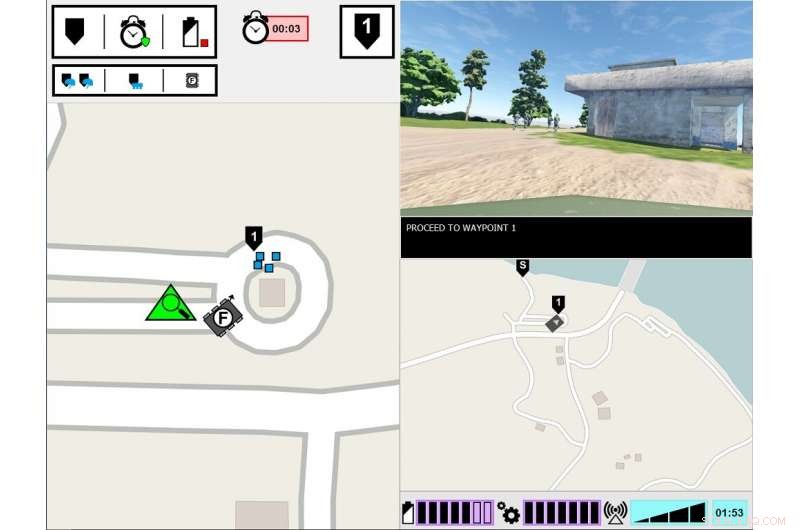

Interfaccia sperimentale ASM. Il monitor di sinistra mostra il punto di vista del Soldato capo dell'ambiente di lavoro. Il monitor di destra visualizza l'interfaccia di comunicazione dell'ASM. Credito:esercito americano

Cosa ci vuole perché un umano si fidi di un robot? Questo è ciò che i ricercatori dell'esercito stanno scoprendo in un nuovo studio su come gli esseri umani e i robot lavorano insieme.

Ricerca sul teaming uomo-agente, o CAPPELLO, ha esaminato come la trasparenza degli agenti, come i robot, veicoli senza pilota o agenti software:influenza la fiducia umana, prestazione del compito, carico di lavoro e percezioni dell'agente. La trasparenza dell'agente si riferisce alla sua capacità di trasmettere agli esseri umani il suo intento, processo di ragionamento e progetti futuri.

Una nuova ricerca condotta dall'esercito rileva che la fiducia umana nei robot diminuisce dopo che il robot commette un errore, anche quando è trasparente con il suo processo di ragionamento. La carta, "Trasparenza e affidabilità degli agenti nell'interazione uomo-robot:l'influenza sulla fiducia dell'utente e sull'affidabilità percepita, " è stato pubblicato nel numero di agosto di Transazioni IEEE su sistemi uomo-macchina .

Ad oggi, la ricerca si è in gran parte concentrata su HAT con agenti intelligenti perfettamente affidabili, il che significa che gli agenti non commettono errori, ma questo è uno dei pochi studi che ha esplorato come la trasparenza dell'agente interagisce con l'affidabilità dell'agente. In questo ultimo studio, gli umani hanno visto un robot commettere un errore, e i ricercatori si sono concentrati sul fatto che gli umani percepissero il robot come meno affidabile, anche quando all'essere umano sono state fornite informazioni sul processo di ragionamento del robot.

"Capire come il comportamento del robot influenza i loro compagni di squadra umani è fondamentale per lo sviluppo di efficaci squadre uomo-robot, così come la progettazione di interfacce e metodi di comunicazione tra i membri del team, " ha detto la dottoressa Julia Wright, ricercatore principale per questo progetto e ricercatore presso il Laboratorio di ricerca dell'esercito del comando di sviluppo delle capacità di combattimento dell'esercito degli Stati Uniti, noto anche come ARL. "Questa ricerca contribuisce agli sforzi delle operazioni multidominio dell'esercito per garantire il superamento delle capacità abilitate dall'intelligenza artificiale. Ma è anche interdisciplinare, come i suoi risultati informeranno il lavoro degli psicologi, robotisti, ingegneri, e progettisti di sistemi che stanno lavorando per facilitare una migliore comprensione tra umani e agenti autonomi nel tentativo di creare compagni di squadra autonomi piuttosto che semplici strumenti.

Questa ricerca è stata uno sforzo congiunto tra ARL e l'Istituto per le simulazioni e la formazione dell'Università della Florida centrale, ed è il terzo e ultimo studio del progetto Autonomous Squad Member (ASM), sponsorizzato dall'Iniziativa pilota di ricerca sull'autonomia del Segretario della Difesa. L'ASM è un piccolo robot di terra che interagisce e comunica con una squadra di fanteria.

Precedenti studi ASM hanno studiato come un robot avrebbe comunicato con un compagno di squadra umano. Utilizzando il modello di trasparenza dell'agente basato sulla consapevolezza della situazione come guida, vari metodi di visualizzazione per trasmettere gli obiettivi dell'agente, intenti, ragionamento, vincoli, e i risultati previsti sono stati esplorati e testati. Sulla base di questi primi risultati dello studio è stato sviluppato un modulo iconografico a colpo d'occhio, e poi è stato utilizzato in studi successivi per esplorare l'efficacia della trasparenza dell'agente in HAT.

I ricercatori hanno condotto questo studio in un ambiente simulato, in cui i partecipanti hanno osservato una squadra di soldati agenti umani, che comprendeva l'ASM, attraversando un corso di formazione. Il compito dei partecipanti era monitorare la squadra e valutare il robot. La squadra soldato-robot ha incontrato vari eventi lungo il percorso e ha risposto di conseguenza. Mentre i soldati hanno sempre risposto correttamente all'evento, a volte il robot ha frainteso la situazione, portando ad azioni scorrette. La quantità di informazioni condivise dal robot variava tra le prove. Mentre il robot spiegava sempre le sue azioni, le ragioni alla base delle sue azioni e il risultato atteso delle sue azioni, in alcune prove il robot ha anche condiviso il ragionamento alla base delle sue decisioni, la sua logica di fondo. I partecipanti hanno visto più squadre di soldati-robot, e le loro valutazioni dei robot sono state confrontate.

Lo studio ha scoperto che, indipendentemente dalla trasparenza del robot nello spiegare il suo ragionamento, l'affidabilità del robot è stato l'ultimo fattore determinante nell'influenzare le proiezioni dei partecipanti sull'affidabilità futura del robot, fiducia nel robot e nelle percezioni del robot. Questo è, dopo che i partecipanti hanno assistito a un errore, hanno continuato a valutare l'affidabilità del robot più bassa, anche quando il robot non ha commesso errori successivi. Sebbene queste valutazioni siano migliorate lentamente nel tempo finché il robot non ha commesso ulteriori errori, la fiducia dei partecipanti nelle proprie valutazioni dell'affidabilità del robot è rimasta ridotta per tutto il resto delle prove, rispetto ai partecipanti che non hanno mai visto un errore. Per di più, i partecipanti che hanno assistito a un errore del robot hanno riportato una minore fiducia nel robot, rispetto a coloro che non hanno mai assistito a un errore del robot.

È stato riscontrato che l'aumento della trasparenza degli agenti migliora la fiducia dei partecipanti nel robot, ma solo quando il robot stava raccogliendo o filtrando informazioni. Ciò potrebbe indicare che la condivisione di informazioni approfondite può mitigare alcuni degli effetti dell'automazione inaffidabile per compiti specifici, ha detto Wright. Inoltre, i partecipanti hanno valutato il robot inaffidabile come meno animato, simpatico, intelligente, e sicuro del robot affidabile.

"Studi precedenti suggeriscono che il contesto è importante nel determinare l'utilità delle informazioni sulla trasparenza, " ha detto Wright. "Dobbiamo capire meglio quali attività richiedono una comprensione più approfondita del ragionamento dell'agente, e come discernere cosa comporterebbe quella profondità. La ricerca futura dovrebbe esplorare modi per fornire informazioni sulla trasparenza in base ai requisiti dei compiti".