I ricercatori CMU hanno sviluppato un metodo per identificare automaticamente i meme e applicare modelli prescritti per aggiungere testo alternativo descrittivo, rendendoli intelligibili tramite tecnologie assistive come gli screen reader. Credito:Carnegie Mellon University

Le persone con disabilità visive usano i social media come tutti gli altri, spesso con l'aiuto di software di lettura dello schermo. Ma quella tecnologia non è all'altezza quando incontra i meme, che non includono testo alternativo, o testo alternativo, per descrivere ciò che è raffigurato nell'immagine.

Per contrastare questo, i ricercatori della Carnegie Mellon University hanno sviluppato un metodo per identificare automaticamente i meme e applicare modelli prescritti per aggiungere testo alternativo descrittivo, rendendoli intelligibili tramite le tecnologie assistive esistenti.

I meme sono immagini che vengono copiate e poi sovrapposte a leggere variazioni di testo. Sono spesso divertenti e trasmettono un'esperienza condivisa, ma "se sei cieco, ti manca quella parte della conversazione, " ha detto Cole Gleason, un dottorato di ricerca studente presso lo Human-Computer Interaction Institute (HCII.) della CMU

"I meme potrebbero non sembrare il problema più importante, ma una parte vitale dell'accessibilità non è scegliere per le persone ciò che merita la loro attenzione, " ha detto Jeff Bigham, professore associato presso l'HCII. "Molte persone usano i meme, e quindi dovrebbero essere resi accessibili."

I meme vivono in gran parte all'interno di piattaforme di social media che hanno barriere all'aggiunta di testo alternativo. Twitter, Per esempio, consente alle persone di aggiungere testo alternativo alle proprie immagini, ma quella caratteristica non è sempre facile da trovare. Dei 9 milioni di tweet esaminati dai ricercatori della CMU, un milione di immagini incluse e, di quelli, solo lo 0,1 percento includeva il testo alternativo.

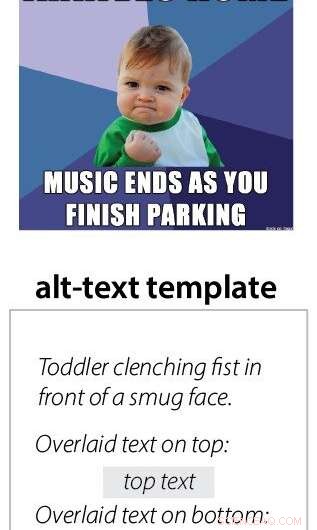

Gleason ha affermato che le tecniche di visione artificiale di base consentono di descrivere le immagini alla base di ogni meme, che si tratti di una celebrità, un bambino che piange, un personaggio dei cartoni animati o una scena come un autobus capovolto in una dolina. Le tecniche di riconoscimento ottico dei caratteri vengono utilizzate per decifrare il testo sovrapposto, che può cambiare ad ogni iterazione del meme. Per ogni tipo di meme, è solo necessario creare un modello che descriva l'immagine, e il testo sovrapposto può essere aggiunto per ogni iterazione di quel meme.

Ma scrivere ciò che il meme intende trasmettere si è rivelato difficile.

"Dipendeva dal meme se l'umorismo veniva tradotto. Alcune delle immagini sono più sfumate, " ha detto Gleason. "E a volte è esplicito e puoi semplicemente descriverlo." Ad esempio, il testo alternativo completo per il cosiddetto meme "success kid" afferma "Bambino che stringe il pugno davanti al viso compiaciuto. Testo sovrapposto in alto:è stato un cattivo ragazzo tutto l'anno. Testo sovrapposto in basso:Ho ancora ricevuto fantastici regali da Babbo Natale".

Il team ha anche creato una piattaforma per tradurre i meme in suoni anziché in testo. Gli utenti effettuano ricerche in una libreria di suoni e trascinano gli elementi in un modello. Questo sistema è stato creato per tradurre i meme esistenti e trasmettere il sentimento attraverso la musica e gli effetti sonori.

"Uno dei motivi per cui abbiamo provato i meme audio è stato perché pensavamo che il testo alternativo avrebbe ucciso lo scherzo, ma la gente continuava a preferire il testo perché ci sono così abituati, " disse Gleason.

La distribuzione della tecnologia sarà una sfida. Anche se è stato integrato in un sito Web generatore di meme, quel testo alternativo non veniva copiato automaticamente quando l'immagine veniva condivisa sui social media.

"Dovremmo convincere Twitter ad aggiungere una nuova funzionalità, " ha detto Gleason. Potrebbe essere qualcosa di aggiunto a uno smartphone personale, ma ha notato che avrebbe messo l'onere sull'utente. I ricercatori della CMU stanno attualmente lavorando a progetti correlati, inclusa un'estensione del browser per Twitter che tenta di aggiungere testo alternativo per ogni immagine e potrebbe includere un sistema di meme. Un altro progetto cerca di integrare il testo alternativo nei metadati delle immagini che rimarrebbero con l'immagine ovunque sia stata pubblicata.

Questo lavoro è stato presentato all'inizio di quest'anno alla conferenza ACCESS a Pittsburgh. Altri ricercatori coinvolti nel progetto includono la borsista post-dottorato HCII Amy Pavel, Studente universitario CMU Xingyu Liu, assistente professore HCII Patrick Carrington, e Lydia Chilton della Columbia University.