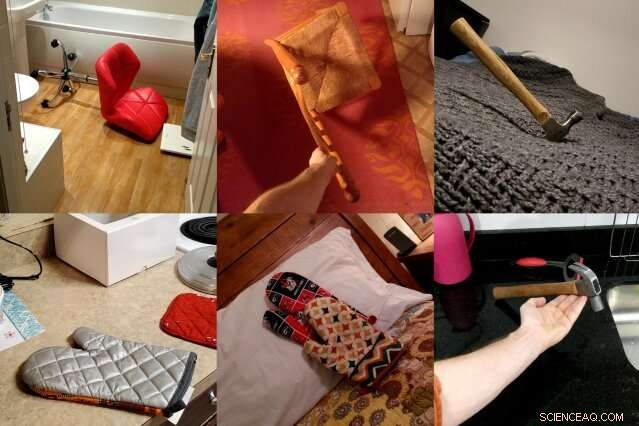

ObjectNet, un dataset di foto creato dai ricercatori del MIT e dell'IBM, mostra gli oggetti da angoli dispari, in più orientamenti, e su diversi sfondi per rappresentare al meglio la complessità degli oggetti 3D. I ricercatori sperano che il set di dati porterà a nuove tecniche di visione artificiale che funzionano meglio nella vita reale. Credito:Massachusetts Institute of Technology

I modelli di visione artificiale hanno imparato a identificare gli oggetti nelle foto in modo così accurato che alcuni possono superare gli umani su alcuni set di dati. Ma quando quegli stessi rilevatori di oggetti vengono liberati nel mondo reale, le loro prestazioni calano notevolmente, creare problemi di affidabilità per le auto a guida autonoma e altri sistemi critici per la sicurezza che utilizzano la visione artificiale.

Nel tentativo di colmare questo divario di prestazioni, un team di ricercatori del MIT e dell'IBM ha deciso di creare un tipo molto diverso di set di dati per il riconoscimento degli oggetti. Si chiama ObjectNet, un gioco su ImageNet, il database di foto in crowdsourcing responsabile del lancio di gran parte del boom moderno dell'intelligenza artificiale.

A differenza di ImageNet, che presenta foto prese da Flickr e altri siti di social media, ObjectNet presenta foto scattate da liberi professionisti pagati. Gli oggetti sono mostrati inclinati su un lato, sparato ad angoli strani, ed esposto in stanze disseminate di disordine. Quando i principali modelli di rilevamento degli oggetti sono stati testati su ObjectNet, i loro tassi di precisione sono scesi da un massimo del 97 percento su ImageNet a solo il 50-55 percento.

"Abbiamo creato questo set di dati per dire alle persone che il problema del riconoscimento degli oggetti continua a essere un problema difficile, "dice Boris Katz, ricercatore presso il Computer Science and Artificial Intelligence Laboratory (CSAIL) e Center for Brains del MIT, Menti e macchine (CBMM). "Abbiamo bisogno di meglio, algoritmi più intelligenti." Katz e i suoi colleghi presenteranno ObjectNet e i loro risultati alla Conferenza sui sistemi di elaborazione delle informazioni neurali (NeurIPS).

Apprendimento profondo, la tecnica che guida gran parte dei recenti progressi nell'IA, utilizza strati di "neuroni" artificiali per trovare modelli in grandi quantità di dati grezzi. Impara a distinguere, dire, la sedia in una foto dopo l'allenamento su centinaia o migliaia di esempi. Ma anche i set di dati con milioni di immagini non possono mostrare ogni oggetto in tutti i suoi possibili orientamenti e impostazioni, creando problemi quando i modelli incontrano questi oggetti nella vita reale.

ObjectNet è diverso dai set di dati di immagini convenzionali in un altro importante aspetto:non contiene immagini di addestramento. La maggior parte dei set di dati è suddivisa in dati per l'addestramento dei modelli e il test delle loro prestazioni. Ma il training set condivide spesso sottili somiglianze con il test set, in effetti dando ai modelli un'anteprima durante il test.

A prima vista, ImageNet, a 14 milioni di immagini, sembra enorme. Ma quando il suo training set è escluso, è di dimensioni paragonabili a ObjectNet, a 50 anni, 000 foto.

"Se vogliamo sapere come funzioneranno gli algoritmi nel mondo reale, dovremmo testarli su immagini che sono imparziali e che non hanno mai visto prima, ", afferma il coautore dello studio Andrei Barbu, un ricercatore presso CSAIL e CBMM.

Un set di dati che cerca di catturare la complessità degli oggetti del mondo reale

Poche persone penserebbero di condividere le foto di ObjectNet con i propri amici, e questo è il punto. I ricercatori hanno assunto freelance di Amazon Mechanical Turk per scattare fotografie di centinaia di oggetti domestici posizionati casualmente. I lavoratori hanno ricevuto incarichi fotografici su un'app, con istruzioni animate che dicono loro come orientare l'oggetto assegnato, da quale angolo sparare, e se posare l'oggetto in cucina, bagno, Camera da letto, o soggiorno.

Volevano eliminare tre pregiudizi comuni:oggetti mostrati frontalmente, in posizioni iconiche, e in contesti altamente correlati, ad esempio piatti impilati in cucina.

Ci sono voluti tre anni per concepire il set di dati e progettare un'app che standardizzasse il processo di raccolta dei dati. "Scoprire come raccogliere dati in modo da controllare i vari pregiudizi è stato incredibilmente complicato, ", afferma il coautore dello studio David Mayo, uno studente laureato presso il Dipartimento di Ingegneria Elettrica e Informatica del MIT. "Abbiamo anche dovuto eseguire esperimenti per assicurarci che le nostre istruzioni fossero chiare e che i lavoratori sapessero esattamente cosa veniva loro chiesto".

Ci è voluto un altro anno per raccogliere i dati effettivi, e alla fine, la metà di tutte le foto inviate dai freelance è stata scartata per non aver soddisfatto le specifiche dei ricercatori. Nel tentativo di essere d'aiuto, alcuni lavoratori hanno aggiunto etichette ai loro oggetti, li mettono in scena su sfondi bianchi, o comunque hanno cercato di migliorare l'estetica delle foto che erano loro assegnate a scattare.

Molte delle foto sono state scattate al di fuori degli Stati Uniti, e quindi, alcuni oggetti potrebbero sembrare sconosciuti. Le arance mature sono verdi, le banane sono di diverse dimensioni, e l'abbigliamento appare in una varietà di forme e trame.

Object Net vs ImageNet:come confrontare i principali modelli di riconoscimento degli oggetti

Quando i ricercatori hanno testato modelli di visione artificiale all'avanguardia su ObjectNet, hanno riscontrato un calo delle prestazioni di 40-45 punti percentuali da ImageNet. I risultati mostrano che i rilevatori di oggetti fanno ancora fatica a capire che gli oggetti sono tridimensionali e possono essere ruotati e spostati in nuovi contesti, dicono i ricercatori. "Queste nozioni non sono integrate nell'architettura dei moderni rilevatori di oggetti, ", afferma il coautore dello studio Dan Gutfreund, un ricercatore presso IBM.

Per dimostrare che ObjectNet è difficile proprio a causa del modo in cui gli oggetti vengono visualizzati e posizionati, i ricercatori hanno permesso ai modelli di addestrarsi su metà dei dati ObjectNet prima di testarli sulla metà rimanente. L'addestramento e il test sullo stesso set di dati in genere migliorano le prestazioni, ma qui i modelli sono migliorati solo leggermente, suggerendo che i rilevatori di oggetti devono ancora comprendere appieno come esistono gli oggetti nel mondo reale.

I modelli di computer vision sono progressivamente migliorati dal 2012, quando un rilevatore di oggetti chiamato AlexNet ha sbaragliato la concorrenza al concorso annuale ImageNet. Poiché i set di dati sono diventati più grandi, anche le prestazioni sono migliorate.

Ma progettando versioni più grandi di ObjectNet, con i suoi angoli di visione e orientamenti aggiunti, non porterà necessariamente a risultati migliori, avvertono i ricercatori. L'obiettivo di ObjectNet è motivare i ricercatori a proporre la prossima ondata di tecniche rivoluzionarie, proprio come ha fatto il lancio iniziale della sfida ImageNet.

"Le persone forniscono a questi rilevatori enormi quantità di dati, ma ci sono rendimenti decrescenti, " dice Katz. "Non è possibile visualizzare un oggetto da ogni angolazione e in ogni contesto. La nostra speranza è che questo nuovo set di dati si traduca in una solida visione artificiale senza sorprendenti fallimenti nel mondo reale".

Questa storia è stata ripubblicata per gentile concessione di MIT News (web.mit.edu/newsoffice/), un popolare sito che copre notizie sulla ricerca del MIT, innovazione e didattica.