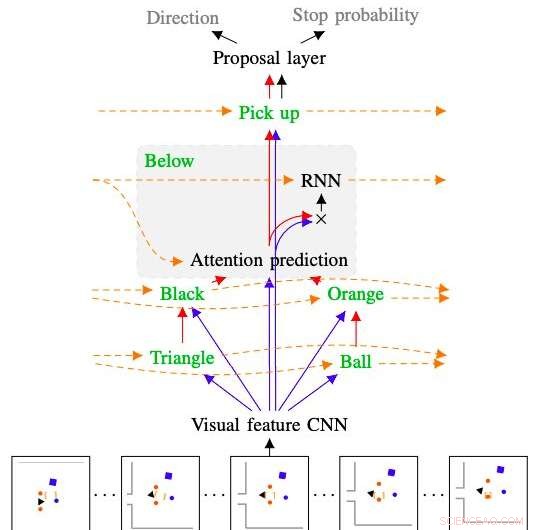

La figura mostra come il modello sviluppato dai ricercatori interpreta e segue il comando "raccogli la pallina arancione da sotto il triangolo nero". Credito:Kuo, Katz &Barbu.

Negli anni a venire, i robot potrebbero assistere gli utenti umani in vari modi, sia quando sono all'interno delle loro case che in altri ambienti. Per essere più intuitivo, i robot dovrebbero essere in grado di seguire comandi e istruzioni in linguaggio naturale, in quanto ciò consente agli utenti di comunicare con loro proprio come farebbero con altri umani.

Con questo in testa, ricercatori del Center for Brains del MIT, Minds &Machines ha recentemente sviluppato un pianificatore robotico basato sul campionamento che può essere addestrato a comprendere sequenze di comandi del linguaggio naturale. Il sistema che hanno sviluppato, presentato in un articolo pre-pubblicato su arXiv, combina una rete neurale profonda con un pianificatore basato sul campionamento.

"È abbastanza importante garantire che i futuri robot nelle nostre case ci capiscano, sia per motivi di sicurezza sia perché la lingua è l'interfaccia più comoda per chiedere ciò che si vuole, "Andrei Barbu, uno dei ricercatori che ha condotto lo studio, ha detto a TechXplore. "Il nostro lavoro unisce tre linee di ricerca:progettazione robotica, reti profonde, e il nostro lavoro su come le macchine possono comprendere il linguaggio. L'obiettivo generale è quello di dare a un robot solo alcuni esempi di cosa significa una frase e fargli seguire nuovi comandi e nuove frasi che non ha mai sentito prima."

L'obiettivo di vasta portata della ricerca condotta da Barbu e dai suoi colleghi è comprendere meglio la comunicazione del linguaggio del corpo. Infatti, mentre le funzioni e i meccanismi alla base della comunicazione orale sono ora ben compresi, la maggior parte della comunicazione che avviene tra animali e umani è non verbale.

Una migliore comprensione del linguaggio del corpo potrebbe portare allo sviluppo di strategie più efficaci per la comunicazione uomo-robot. Tra l'altro, i ricercatori del MIT hanno così esplorato la possibilità di tradurre frasi in movimenti robotici, e viceversa. Il loro recente studio è un primo passo in questa direzione.

Credito:Kuo, Katz &Barbu.

"I pianificatori robotici sono fantastici nell'esplorare ciò che il robot può fare e poi nel far eseguire al robot un'azione, "Yen-Ling Kuo, un altro ricercatore che ha condotto lo studio, ha detto a TechXplore. "Il nostro lavoro richiede una frase, lo fa a pezzi, questi pezzi sono tradotti in piccole reti, che vengono ricombinati insieme."

Proprio come il linguaggio è composto da parole che possono essere combinate in frasi seguendo regole grammaticali, le reti sviluppate da Barbu, Kuo e il loro collega Boris Katz sono costituiti da reti più piccole addestrate a comprendere singoli concetti. Quando combinati insieme, queste reti possono scoprire e rappresentare il significato di intere frasi.

Il nuovo pianificatore robotico sviluppato dai ricercatori ha due componenti chiave. Il primo è una rete neurale profonda gerarchica ricorrente, che controlla come il pianificatore esplora l'ambiente circostante, prevedendo anche quando è probabile che un percorso pianificato raggiunga un determinato obiettivo e stimando l'efficacia di ciascuna delle possibili mosse del robot individualmente. Il secondo è un pianificatore basato sul campionamento spesso utilizzato negli studi di robotica, chiamato albero casuale ad esplorazione rapida (RRT).

"Il vantaggio principale del nostro pianificatore è che richiede pochi dati di addestramento, " spiegò Barbu. "Se vuoi insegnare a un robot, non gli darai migliaia di esempi a casa, ma una manciata sono abbastanza ragionevoli. Addestrare un robot dovrebbe comportare azioni simili a quelle che potresti eseguire se stessi addestrando un cane".

Mentre gli studi passati hanno anche esplorato i modi per guidare i robot tramite comandi verbali, le tecniche presentate in esse spesso si applicano solo ad ambienti discreti, in cui i robot possono eseguire solo un numero limitato di azioni. Il pianificatore sviluppato dai ricercatori, d'altra parte, può supportare una varietà di interazioni con l'ambiente circostante, anche se coinvolgono oggetti che il robot non ha mai incontrato prima.

"Quando la nostra rete è confusa, la parte del pianificatore prende il sopravvento, capisce cosa fare e poi la rete può prendere il sopravvento la prossima volta che è sicura di cosa fare, " ha spiegato Kuo. "Il fatto che il nostro modello sia costituito da parti gli conferisce anche un'altra proprietà desiderabile:l'interpretabilità".

Quando non sono in grado di completare un determinato compito, molti modelli di machine learning esistenti non sono in grado di fornire informazioni su cosa è andato storto e sui problemi che hanno incontrato. Ciò rende più difficile per gli sviluppatori identificare le carenze di un modello e apportare modifiche mirate alla sua architettura. La componente di deep learning del pianificatore robotico creato da Barbu, Kuo e Katz, d'altra parte, mostra passo passo il suo ragionamento, chiarire ciò che ogni parola che elabora trasmette sul mondo e come ha combinato i risultati delle sue analisi. Ciò consente ai ricercatori di individuare i problemi che gli hanno impedito di completare con successo una determinata azione in passato e di apportare modifiche all'architettura che potrebbero garantirne il successo nei tentativi futuri.

"Siamo molto entusiasti dell'idea che i robot possano imparare rapidamente la lingua e imparare rapidamente nuove parole con pochissimo aiuto da parte degli umani, " disse Barbu. "Normalmente, il deep learning è considerato molto affamato di dati; questo lavoro rafforza l'idea che quando si costruiscono i principi giusti (composizionalità) e gli agenti eseguono azioni significative non hanno bisogno di così tanti dati".

I ricercatori hanno valutato le prestazioni del loro pianificatore in una serie di esperimenti, confrontando anche le sue prestazioni con quelle dei modelli RRT esistenti. In questi test, il pianificatore ha acquisito con successo il significato delle parole e ha usato ciò che ha imparato per rappresentare sequenze di frasi che non ha mai incontrato prima, superando tutti i modelli a cui è stato confrontato.

Nel futuro, il modello sviluppato da questo team di ricercatori potrebbe informare lo sviluppo di robot in grado di elaborare e seguire i comandi del linguaggio naturale in modo più efficace. Al momento, il loro pianificatore consente ai robot di elaborare ed eseguire semplici istruzioni come "prendi il piatto sul tavolo", ma non è ancora in grado di cogliere il significato di quelli più complessi, come "raccogli la bambola ogni volta che cade a terra e puliscila". Barbù, Kuo e Katz stanno quindi cercando di ampliare la gamma di frasi che il robot può comprendere.

"Il nostro obiettivo futuro a lungo termine è esplorare l'idea della pianificazione inversa, " disse Kuo. "Ciò significa che se possiamo trasformare il linguaggio in azioni robotiche, potremmo anche guardare le azioni e chiedere al robot 'cosa stava pensando qualcuno quando lo ha fatto?' Speriamo che questo serva come chiave per sbloccare il linguaggio del corpo nei robot".

© 2020 Scienza X Rete