Credito:Shutterstock/Sergey Tinyakov

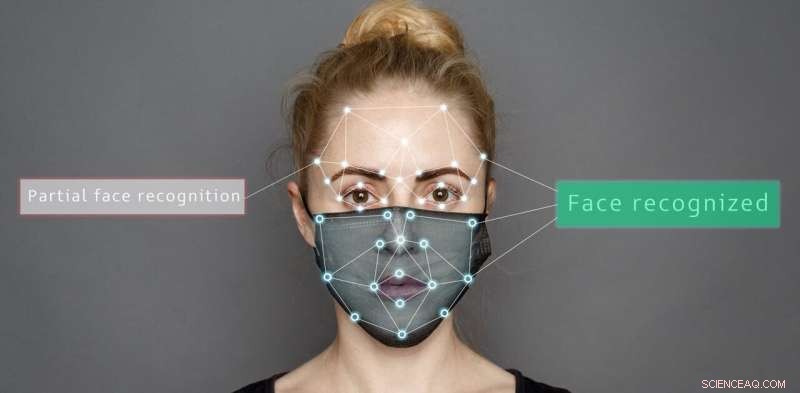

I sistemi artificiali come i robot per l'assistenza domiciliare o la tecnologia di assistenza alla guida stanno diventando sempre più comuni ed è giunto il momento di indagare se le persone o gli algoritmi sono più bravi a leggere le emozioni, in particolare data la sfida aggiuntiva causata dalle coperture per il viso.

Nel nostro recente studio, abbiamo confrontato il modo in cui le maschere per il viso o gli occhiali da sole influenzano la nostra capacità di determinare emozioni diverse rispetto all'accuratezza dei sistemi artificiali.

Abbiamo presentato immagini di espressioni facciali emotive e aggiunto due diversi tipi di maschere:la maschera intera utilizzata dagli operatori in prima linea e una maschera introdotta di recente con una finestra trasparente per consentire la lettura delle labbra.

I nostri risultati mostrano algoritmi e persone entrambi lottano quando i volti sono parzialmente oscurati. Ma i sistemi artificiali hanno maggiori probabilità di interpretare erroneamente le emozioni in modi insoliti.

I sistemi artificiali hanno ottenuto risultati significativamente migliori rispetto alle persone nel riconoscere le emozioni quando il viso non era coperto:il 98,48% rispetto all'82,72% di sette diversi tipi di emozioni.

Ma a seconda del tipo di copertura, la precisione sia per le persone che per i sistemi artificiali variava. Ad esempio, gli occhiali da sole hanno oscurato la paura per le persone, mentre le maschere parziali hanno aiutato sia le persone che i sistemi artificiali a identificare correttamente la felicità.

È importante sottolineare che le persone classificavano le espressioni sconosciute principalmente come neutre, ma i sistemi artificiali erano meno sistematici. Spesso selezionavano in modo errato la rabbia per le immagini oscurate con una maschera completa e rabbia, felicità, neutralità o sorpresa per le espressioni parzialmente mascherate.

Lo studio ha utilizzato maschere complete e parziali e occhiali da sole per oscurare parti del viso. Autore fornito

Decodifica delle espressioni facciali

La nostra capacità di riconoscere le emozioni utilizza il sistema visivo del cervello per interpretare ciò che vediamo. Abbiamo anche un'area del cervello specializzata per il riconoscimento facciale, nota come area del viso fusiforme, che aiuta a interpretare le informazioni rivelate dai volti delle persone.

Insieme al contesto di una situazione particolare (interazione sociale, linguaggio e movimento del corpo) e alla nostra comprensione dei comportamenti passati e alla simpatia verso i nostri sentimenti, possiamo decodificare come si sentono le persone.

È stato proposto un sistema di unità di azione facciale per decodificare le emozioni sulla base di segnali facciali. Include unità come "the cheek raiser" e "the lip corner puller", che sono entrambi considerati parte di un'espressione di felicità.

Al contrario, i sistemi artificiali analizzano i pixel dalle immagini di un volto quando classificano le emozioni. Passano i valori di intensità dei pixel attraverso una rete di filtri che imitano il sistema visivo umano.

La scoperta che i sistemi artificiali classificano erroneamente le emozioni da volti parzialmente oscurati è importante. Potrebbe portare a comportamenti imprevisti dei robot che interagiscono con le persone che indossano maschere per il viso.

Immagina se classificano erroneamente un'emozione negativa, come rabbia o tristezza, come espressione emotiva positiva. I sistemi artificiali cercherebbero di interagire con una persona che intraprende azioni sull'interpretazione sbagliata di cui sono felici. Ciò potrebbe avere effetti dannosi per la sicurezza di questi sistemi artificiali e per gli esseri umani interagenti.

Riesci a leggere l'emozione dei ricercatori dai loro volti coperti? Sia i sistemi artificiali che le persone sono compromessi nella categorizzazione delle emozioni quando i volti sono oscurati. Autore fornito

Rischi derivanti dall'utilizzo di algoritmi per leggere le emozioni

La nostra ricerca ribadisce che gli algoritmi sono suscettibili di pregiudizi nel loro giudizio. Ad esempio, le prestazioni dei sistemi artificiali sono fortemente influenzate quando si tratta di classificare le emozioni dalle immagini naturali. Anche solo l'angolazione o l'ombra del sole possono influenzare i risultati.

Gli algoritmi possono anche essere di parte razziale. Come hanno rilevato studi precedenti, anche una piccola modifica al colore dell'immagine, che non ha nulla a che fare con le espressioni emotive, può portare a un calo delle prestazioni degli algoritmi utilizzati nei sistemi artificiali.

Come se ciò non bastasse, anche piccole perturbazioni visive, impercettibili all'occhio umano, possono indurre questi sistemi a identificare erroneamente un input come qualcos'altro.

Alcuni di questi problemi di classificazione errata possono essere risolti. Ad esempio, gli algoritmi possono essere progettati per considerare le caratteristiche legate alle emozioni come la forma della bocca, piuttosto che raccogliere informazioni dal colore e dall'intensità dei pixel.

Un altro modo per risolvere questo problema è modificare le caratteristiche dei dati di addestramento, sovracampionando i dati di addestramento in modo che gli algoritmi imitino meglio il comportamento umano e commettano errori meno estremi quando classificano erroneamente un'espressione.

Ma nel complesso, le prestazioni di questi sistemi diminuiscono quando si interpretano le immagini in situazioni del mondo reale quando i volti sono parzialmente coperti.

Sebbene i robot possano rivendicare una precisione superiore a quella umana nel riconoscimento delle emozioni per immagini statiche di volti completamente visibili, nelle situazioni del mondo reale che sperimentiamo ogni giorno, le loro prestazioni non sono ancora umane.