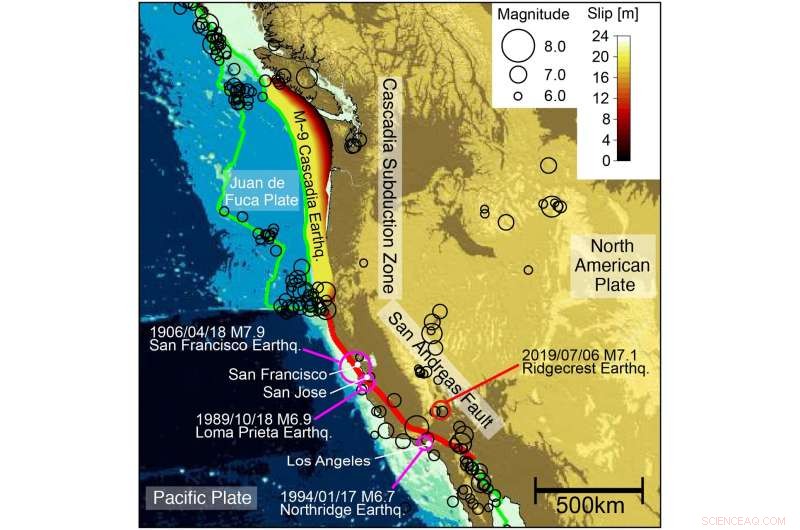

La faglia di Sant'Andrea (linee rosse) e gli altri confini delle placche (linee verdi). I contorni colorati indicano la presunta distribuzione della faglia del terremoto del 1700 nella zona di subduzione della Cascadia. I cerchi mostrano la distribuzione dei terremoti nel 1900-2019. Terremoti disastrosi (cerchi viola) e città danneggiate sono mostrati con il terremoto di Ridgecrest M7.1-2019 (cerchio rosso). Attestazione:UTkyo

Ogni anno, da poche centinaia a decine di migliaia di morti sono attribuite agli effetti catastrofici dei grandi terremoti. A parte lo scuotimento del terreno, i rischi sismici includono frane, rotture di dighe, allagamento, e peggio, se il fondo del mare viene improvvisamente spostato durante un terremoto, può innescare uno tsunami mortale.

Anche se i terremoti non possono essere prevenuti, i processi che coinvolgono le placche tettoniche della Terra che costituiscono la sua crosta e il mantello superiore possono fornire agli scienziati indizi sui possibili effetti di questi imminenti disastri prima che arrivino.

Un team guidato dal professor Tsuyoshi Ichimura dell'Earthquake Research Institute (ERI) dell'Università di Tokyo (UTokyo) sta studiando la deformazione delle placche tettoniche per aiutare la previsione fisica di disastri naturali come i terremoti. Nello specifico, il team sta simulando un confine di placca tettonica che si estende da Vancouver, British Columbia, giù nel nord della California. A questo confine, chiamato zona di subduzione della Cascadia, l'esploratore costiero, Juan de Fuca, e le placche Gorda si spostano a est e si spostano sotto la placca nordamericana, un processo noto come subduzione che può innescare terremoti di grande magnitudo e attività vulcanica.

Il team ha recentemente esteso e ottimizzato uno dei suoi codici scientifici per il supercomputer più potente e intelligente al mondo per la scienza aperta, l'IBM AC922 Summit presso l'Oak Ridge Leadership Computing Facility (OLCF), una struttura per gli utenti dell'Office of Science del Dipartimento dell'Energia degli Stati Uniti (DOE) situata presso l'Oak Ridge National Laboratory (ORNL) del DOE.

Trasformando il risolutore ImpliCit a elementi finiti non strutturati con codice UNICORN (Structured grid roughNing) in un algoritmo simile all'intelligenza artificiale (AI), il team ha eseguito UNICORN a 416 petaflop e ha ottenuto un'accelerazione di 75 volte rispetto a un precedente solutore all'avanguardia sfruttando appieno la potenza dei Tensor Core sulle GPU Volta di Summit. I Tensor Core sono unità di elaborazione specializzate che eseguono rapidamente moltiplicazioni e addizioni di matrici utilizzando calcoli di precisione mista.

"I Tensor Core non sono disponibili per qualsiasi tipo di calcolo, "ha detto Kohei Fujita, professore assistente presso ERI. "Per questa ragione, abbiamo dovuto allineare tutti i nostri modelli di accesso ai dati e modelli di moltiplicazione per adattarli." I modelli di accesso ai dati determinano come un programma software accede ai dati in memoria e possono essere organizzati in modo più efficiente per sfruttare una particolare architettura del computer.

Usando UNICORNO, il team UTokyo ha simulato un 1, 944 chilometri × 2, 646 km × 480 km nella zona di subduzione della Cascadia per osservare come si deforma la placca tettonica a causa di un fenomeno chiamato "scivolamento di faglia, " uno spostamento improvviso che si verifica al confine della placca.

Il team ha affermato che il nuovo solutore può essere utilizzato come strumento per aiutare gli scienziati nell'arduo compito della previsione dei terremoti a lungo termine, un obiettivo che, quando realizzato, potrebbe portare alla previsione dei terremoti e alla mitigazione dei disastri.

In precedenza, il team ha dimostrato un approccio generale per introdurre l'IA nelle applicazioni scientifiche nel risolutore iMplicit con intelligenza artificiale e tRAnsprecision computing, o MOTRA, code, un risultato che lo scorso anno è valso loro una nomination come finalista dell'Association for Computing Machinery Gordon Bell.

UNICORN esegue calcoli più densi, permettendogli di sfruttare appieno l'architettura unica di Summit, che dispone di 9, 216 CPU IBM POWER9 e 27, 648 GPU NVIDIA Volta. La parte di codice più costosa dal punto di vista computazionale è stata eseguita a 1,1 exaflop utilizzando una precisione mista, un'impresa importante per un codice basato su equazioni piuttosto che su calcoli di deep learning. (I codici basati su quest'ultimo sono intrinsecamente ottimali per sistemi come Summit.)

Per futuri problemi sismici, il team dovrà applicare UNICORN per analizzare la crosta terrestre e le risposte del mantello a uno slittamento di faglia nel tempo. Ciò richiederà migliaia di simulazioni, quindi centinaia o migliaia di iterazioni aggiuntive per confrontare i risultati con gli eventi sismici del mondo reale.

"Per raggiungere i nostri obiettivi di previsione dei terremoti, dovremo fare molte simulazioni di deformazione della crosta e poi confrontare i nostri risultati con i record osservati dai terremoti passati, " disse Ichimura.

Il team presenta questo lavoro alla Supercomputing Conference 2019, SC19, in un poster intitolato "416-PFLOPS Fast Scalable Implicit Solver on Low-Ordered Unstructured Finite Elements Accelerated by 1.10-ExaFLOPS Kernel with Reformulated AI-Like Algorithm:For Equation-Based Earthquake Modeling". Questo lavoro è stato condotto come ricerca congiunta con NVIDIA, ORNL, l'Agenzia giapponese per le scienze e le tecnologie marine-terrestri, l'Università del Texas ad Austin, e RIKEN. Inoltre, il team sta presentando il lavoro al Workshop sulla programmazione degli acceleratori utilizzando le direttive tenutosi in collaborazione con SC19.