Quando l'informazione online fa paura, può scatenare odio e violenza. Credito:UVgreen/Shutterstock.com

Quando un senatore degli Stati Uniti ha chiesto al CEO di Facebook Mark Zuckerberg, "Puoi definire un discorso di odio?" era probabilmente la domanda più importante che i social network devono affrontare:come identificare l'estremismo all'interno delle loro comunità.

I crimini d'odio nel 21° secolo seguono uno schema familiare in cui una filippica online si intensifica in azioni violente. Prima di aprire il fuoco nella sinagoga dell'Albero della Vita a Pittsburgh, il killer accusato si era sfogato sul social network di estrema destra Gab sui migranti honduregni che viaggiavano verso il confine con gli Stati Uniti, e la presunta cospirazione ebraica dietro tutto ciò. Poi ha dichiarato, "Non posso restare a guardare la mia gente che viene massacrata. Al diavolo le tue ottiche, Sto entrando." Il modello degli estremisti che scaricano la loro intolleranza online è stato una caratteristica inquietante di alcuni recenti crimini d'odio. Ma la maggior parte dell'odio online non è così flagrante, o altrettanto facile da individuare.

Come ho scoperto nel mio studio del 2017 sull'estremismo nei social network e nei blog politici, piuttosto che un palese bigottismo, la maggior parte dell'odio online assomiglia molto alla paura. Non si esprime in insulti razziali o inviti al confronto, ma piuttosto in accuse infondate di invasori ispanici che si riversavano nel paese, crimine nero su bianco o legge della sharia che si infiltra nelle città americane. Narrazioni isteriche come queste sono diventate il veicolo preferito dagli estremisti di oggi e possono essere più efficaci nel provocare la violenza nel mondo reale rispetto agli stereotipati incitamenti all'odio.

La facilità di diffondere la paura

Su Twitter, un meme popolare in giro di recente descrive la "rete terroristica islamica" diffusa su una mappa degli Stati Uniti, mentre un account Facebook chiamato "America Under Attack" condivide un articolo con i suoi 17, 000 seguaci sugli "Angry Young Men and Gangbangers" che marciano verso il confine. E su Gab, innumerevoli profili parlano di piani ebraici per sabotare la cultura americana, sovranità e presidente.

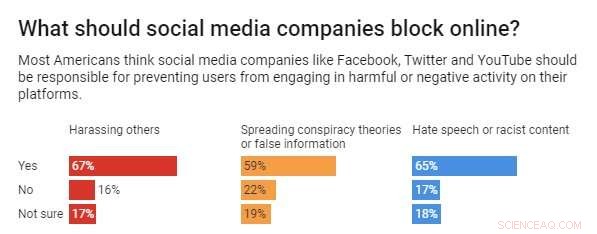

Credito:Grafico:La conversazione, CC-BY-ND Fonte:HuffPost/YouGov

Pur non essendo apertamente antagonistico, queste note suonano bene ad un pubblico che ha trovato nei social media un luogo dove poter esprimere apertamente la propria intolleranza, fintanto che si colorano all'interno delle linee. Possono evitare l'esposizione che attira l'incitamento all'odio tradizionale. Considerando che il raduno nazionalista bianco a Charlottesville è stato di alto profilo e rivelatore, i social network possono essere anonimi e discreti, e quindi liberatorio per il razzista non dichiarato. Ciò rappresenta una dura sfida per piattaforme come Facebook, Twitter e YouTube.

Combattere l'odio

Ovviamente questa non è solo una sfida per le società di social media. Il pubblico in generale sta affrontando la complessa questione di come rispondere alle narrazioni infiammatorie e prevenute che stanno alimentando le paure razziali e la conseguente ostilità. Però, i social network hanno la capacità unica di abbassare il volume sull'intolleranza se determinano che un utente ha effettivamente violato i loro termini di servizio. Ad esempio, ad aprile 2018, Facebook ha rimosso due pagine associate al nazionalista bianco Richard Spencer. Pochi mesi dopo, Twitter ha sospeso diversi account associati al gruppo di estrema destra The Proud Boys per aver violato la sua politica "che vieta i gruppi estremisti violenti".

Ancora, alcuni critici sostengono che le reti non si muovano abbastanza velocemente. C'è una pressione crescente affinché questi siti web controllino l'estremismo che è fiorito nei loro spazi, oppure diventano essi stessi sorvegliati. Un recente sondaggio Huffpost/YouGov ha rivelato che due terzi degli americani volevano che i social network impedissero agli utenti di pubblicare "incitamento all'odio o contenuti razzisti".

In risposta, Facebook ha intensificato i suoi sforzi contro l'estremismo, riportando a maggio di aver rimosso "2,5 milioni di discorsi di odio, "oltre un terzo dei quali è stato identificato utilizzando l'intelligenza artificiale, il resto da monitor umani o segnalati dagli utenti. Ma anche se Zuckerberg ha promesso più azione nel novembre 2018, l'azienda ha riconosciuto che insegnare la sua tecnologia per identificare l'incitamento all'odio è estremamente difficile a causa di tutti i contesti e le sfumature che possono alterare drasticamente questi significati.

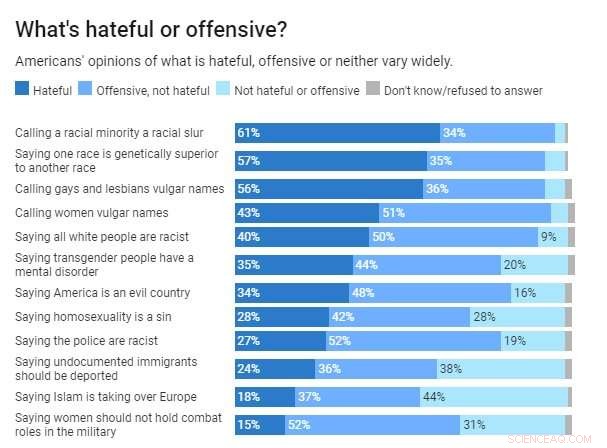

Le percentuali totali potrebbero non corrispondere esattamente a 100 a causa dell'arrotondamento. Credito:Grafico:La conversazione, CC-BY-ND Fonte:Istituto Cato

Inoltre, il consenso pubblico su ciò che costituisce effettivamente l'incitamento all'odio è nella migliore delle ipotesi ambiguo. Il conservatore Cato Institute ha riscontrato un ampio disaccordo tra gli americani sul tipo di discorso che dovrebbe essere qualificato come odio, o discorso offensivo, o giusta critica. E così, queste discrepanze sollevano l'ovvia domanda:come può un algoritmo identificare l'incitamento all'odio se noi umani riusciamo a malapena a definirlo da soli?

La paura accende la miccia

L'ambiguità di ciò che costituisce l'incitamento all'odio sta fornendo ampia copertura agli estremisti moderni per infondere ansie culturali nelle reti popolari. Ciò rappresenta forse il pericolo più evidente:innescare la paranoia razziale delle persone può anche essere estremamente potente nello stimolare l'ostilità.

Il defunto studioso della comunicazione George Gerbner ha scoperto che, contrariamente alle credenze popolari, la forte esposizione alla violenza dei media non ha reso le persone più violente. Piuttosto, li rendeva più timorosi che altri facessero loro violenza, che spesso porta a corrosiva sfiducia e risentimento culturale. Questo è esattamente ciò a cui stanno attingendo i razzisti di oggi, e quali social network devono imparare a individuare.

I post che parlano di complotti ebraici per distruggere l'America, o delitto nero su bianco, non chiedono direttamente la violenza, ma stanno amplificando i pregiudizi che possono indurre i seguaci ad agire. Questo è esattamente quello che è successo prima degli assalti mortali a una storica chiesa nera a Charleston nel 2015, e la sinagoga di Pittsburgh il mese scorso.

Per i social network, la sfida è duplice. Devono prima decidere se continuare a ospitare razzisti non violenti come Richard Spencer, che ha invocato "una pacifica pulizia etnica, " e rimane attivo su Twitter. O se è per questo, Il leader della Nation of Islam Louis Farrakhan, che di recente ha paragonato gli ebrei alle termiti, e continua a postare sulla sua pagina Facebook.

Quando Twitter e Facebook lasciano che questi profili rimangano attivi, le aziende prestano la credibilità delle loro comunità online a questi provocatori di razzismo o antisemitismo. Ma segnalano anche che le loro definizioni di odio potrebbero essere troppo ristrette.

Il discorso di odio più pericoloso a quanto pare non viene più trasmesso con insulti etnici o retorica delirante sulla supremazia bianca. Piuttosto, è tutto sui social media, in bella vista, portando hashtag come #WhiteGenocide, #BlackCrimes, #MigrantInvasion e #AmericaUnderAttack. Creano un'illusione di minaccia imminente su cui prosperano i radicali, e alla quale hanno risposto i più inclini alla violenza.

Questo articolo è stato ripubblicato da The Conversation con una licenza Creative Commons. Leggi l'articolo originale.